LTX Studio 为其开源视频生成模型 LTX Video 推出了三项全新的 LoRA 控制模块,让 AI 视频创作进入一个更具操控性与表现力的新阶段。

- Depth Control: LTX-Video-ICLoRA-depth-13b-0.9.7

- Pose Control: LTX-Video-ICLoRA-pose-13b-0.9.7

- Canny Control: LTX-Video-ICLoRA-canny-13b-0.9.7

这三款 LoRA 分别是:

- 🕺 姿势 LoRA(Pose LoRA)

- 🏞️ 深度 LoRA(Depth LoRA)

- ✏️ Canny LoRA

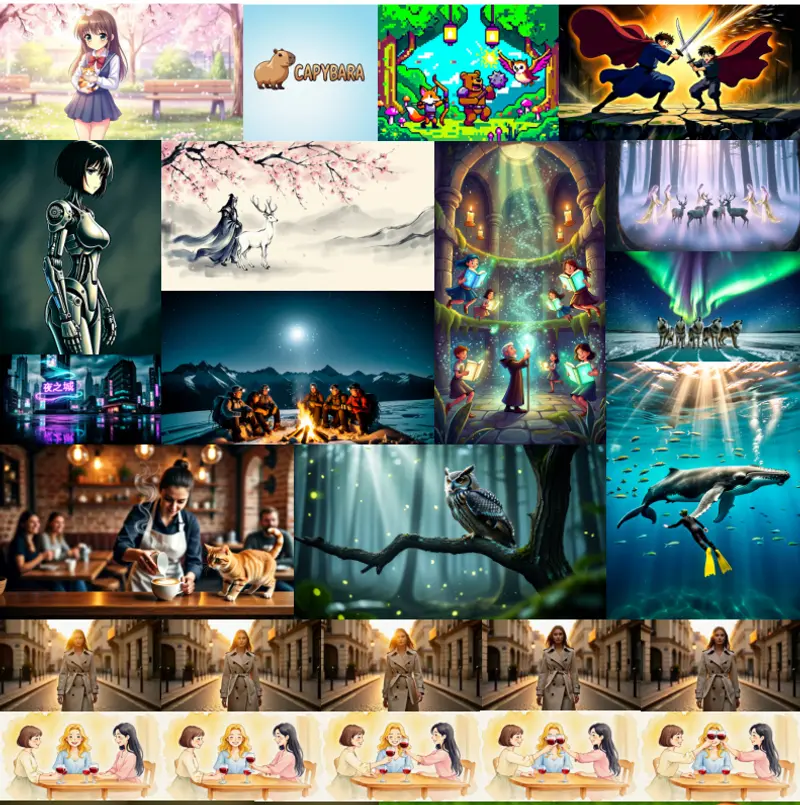

它们不仅支持在消费级硬件上训练和使用,而且只需少量样本即可实现精细控制,为视频生成带来了更强的可控性和创意自由度。

🧠 为什么推出这些 LoRA?

LTX Video 是目前少有的可在本地运行的高质量 AI 视频生成模型。然而,在复杂场景中如何实现对动作、构图与细节的精确控制,一直是视频生成的一大挑战。

此次推出的三款 LoRA 模块正是为了提升用户对视频内容的掌控能力,使 AI 视频创作更加“可预测、可编辑、可复用”。

🎛️ 三款 LoRA 功能详解

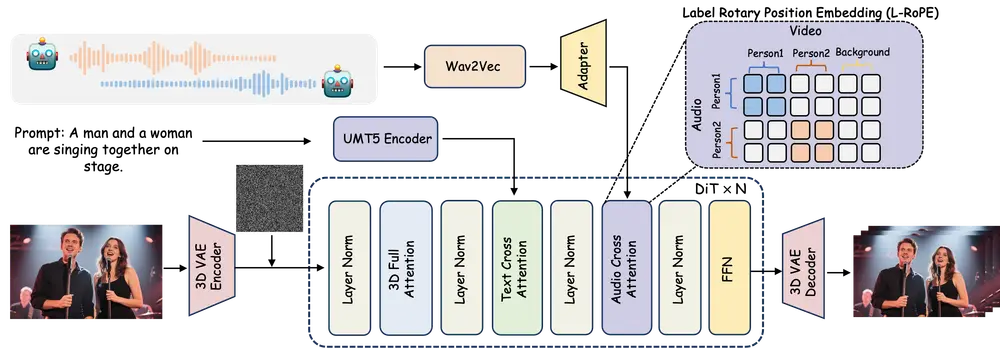

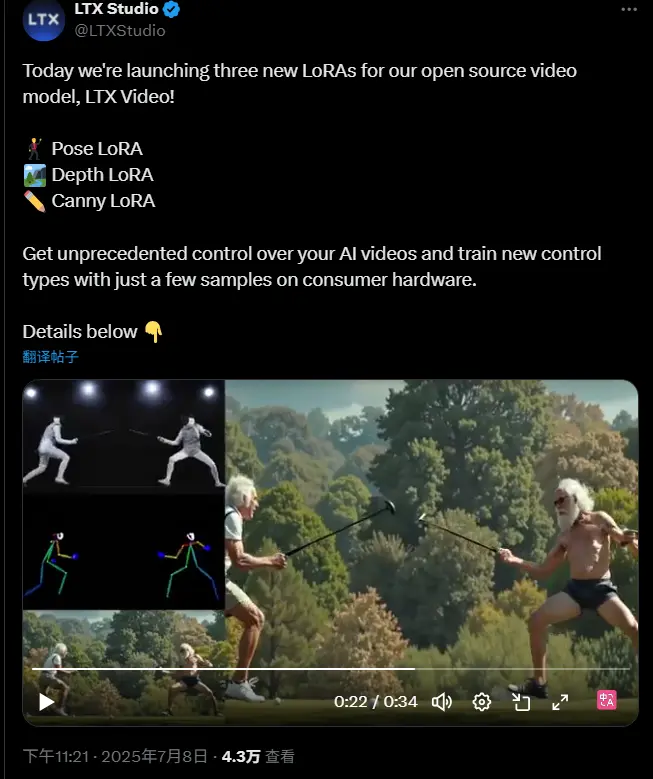

1. 姿势 LoRA(Pose LoRA)

从参考视频中提取人物骨骼信息,精准捕捉角色动作轨迹。

✅ 优势:

- 可用于引导角色运动路径

- 支持高精度动作控制

- 适用于动画角色驱动、舞蹈动作复制等场景

2. 深度 LoRA(Depth LoRA)

理解画面中的空间关系,保持对象之间的纵深感和比例一致性。

✅ 优势:

- 维持场景的立体感与透视逻辑

- 避免画面“平面化”或“扭曲”

- 适用于三维风格视频、虚拟布景合成

3. Canny LoRA

基于边缘检测机制,提取面部轮廓、物体边界等关键线条,确保风格迁移时保留核心特征。

✅ 优势:

- 精准保留人物面部特征

- 强化画面结构稳定性

- 支持高清风格转换与细节增强

🔧 开源训练代码同步发布

为了让社区能够快速应用并扩展这些 LoRA 模块,LTX Studio 同步发布了完整的 训练代码与流程文档。

这意味着:

- 用户可根据自己的需求训练定制化的 LoRA 模型

- 利用少量样本即可微调,适配特定风格或角色

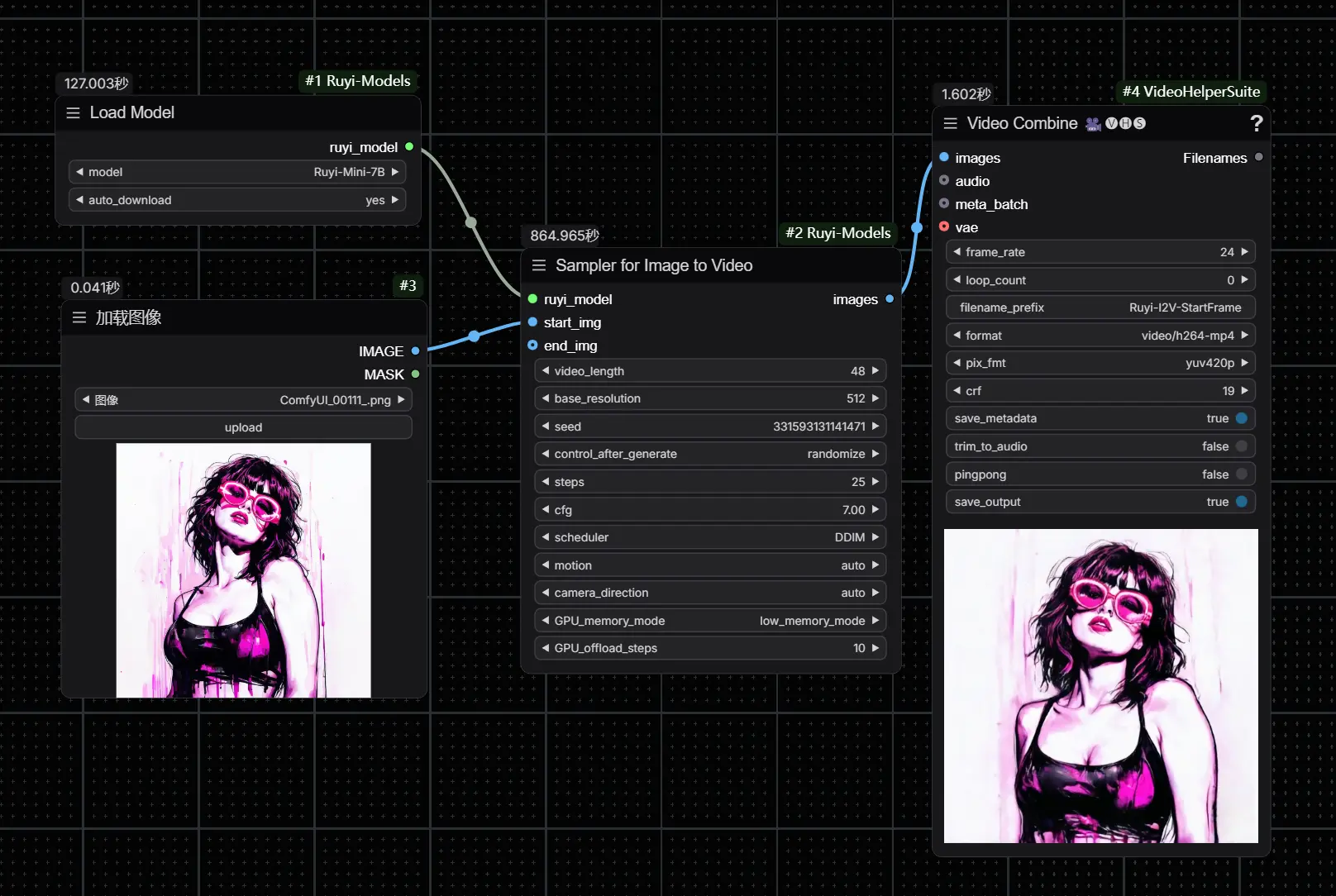

- 更好地整合到 ComfyUI、AIGC 工作流中

这一举措大大降低了 LoRA 的训练门槛,使得更多创作者和研究人员都能参与进来。

💡 为何值得关注?

- 完全开源:所有 LoRA 和训练方法均开放给社区;

- 轻量可用:无需高端 GPU,也能训练个性化 LoRA;

- 多 LoRA 联动:支持多个 LoRA 同时作用于同一视频生成任务;

- 本地部署友好:适合希望在本地环境中构建完整视频生成流水线的用户。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...