在当前的 AI 视觉创作领域,我们正陷入一种“工具碎片化”的困境:生成图片用 Midjourney,生成视频换 Runway,修图得开 Photoshop,剪视频又要另一套流程。这些工具不仅接口割裂,更难以协同工作——想要“参考一张图生成视频,再对其中几帧进行风格化编辑并应用到全片”,往往需要在多个软件间反复跳转,效果也难以保证一致性。

Capybara 项目组今日推出了全新的统一视觉创作基础模型 Capybara,旨在彻底终结这一混乱局面。

- GitHub:https://github.com/xgen-universe/Capybara

- 模型:https://huggingface.co/xgen-universe/Capybara

- Demo:https://inappetent-acrophonically-alison.ngrok-free.dev

Capybara 不是一个简单的模型集合,而是一个真正的单一架构、全能型 AI 系统。它基于先进的扩散模型与 Transformer 架构,将文本到图像/视频生成、指令式编辑、上下文条件生成以及关键帧传播等能力完美融合。无论是从零开始的创意生成,还是对现有素材的精细修改,只需一个模型、一套接口,即可流畅完成。

核心突破:真正的“统一”而非“拼凑”

Capybara 的最大亮点在于其原生统一性。它并非将多个专家模型打包,而是通过一套内部表示和生成机制,同时处理静态图像与动态视频、生成任务与编辑任务。

1. 全覆盖的任务矩阵

Capybara 支持四大类核心创作任务,覆盖了视觉生产的全生命周期:

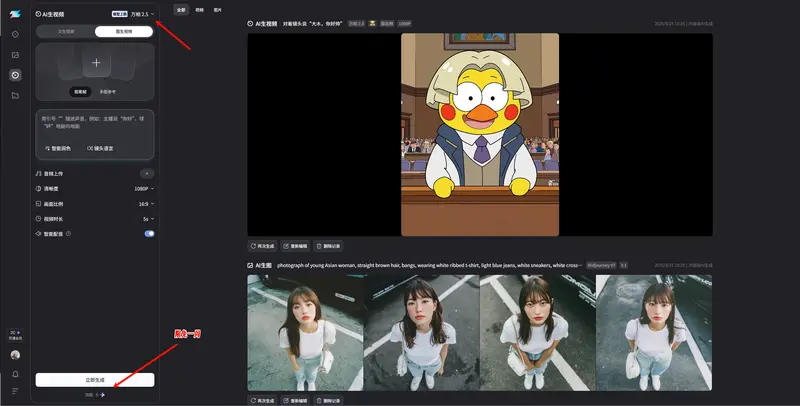

- 基础生成 (T2I/T2V):输入文字描述,直接生成高保真图片或连贯视频。

- 上下文条件生成:

- 主体一致性 (S2I/S2V):提供一张宠物照片,即可生成该宠物在各种场景下的新图或视频,身份锁定精准。

- 结构化控制 (C2I/C2V):支持草图、姿态图、深度图作为控制条件,实现精确构图。

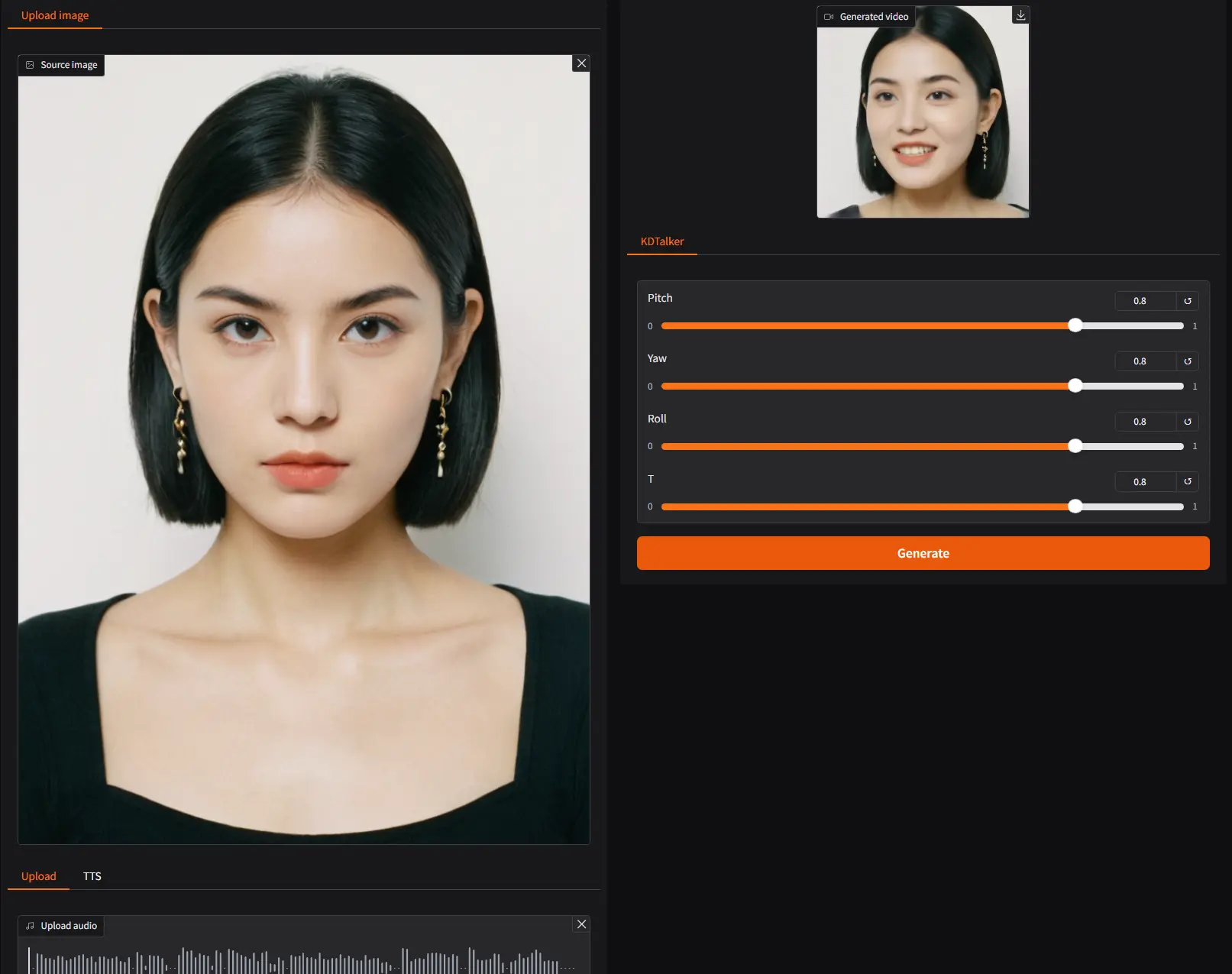

- 图生视频 (I2V):基于单张起始帧,自动演绎出自然流畅的后续动作。

- 指令式编辑 (TI2I/TV2V):输入“把白天变夜晚”或“给汽车换个颜色”,模型能精准修改指定区域,同时完美保护人物身份和背景结构。

- 上下文编辑与传播 (II2I/IV2V/VV2V):

- 风格迁移:参考另一张图片的风格来重塑当前内容。

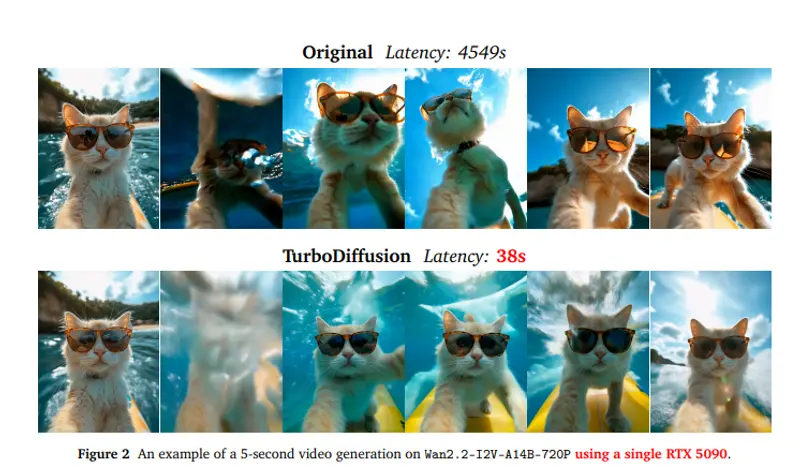

- 关键帧传播:这是视频编辑的杀手锏。只需编辑少数几帧(关键帧),模型即可自动将相同的修改逻辑平滑地应用到整段视频的其余部分,彻底解决长视频编辑的一致性难题。

2. 灵活的多模态“条件包”

Capybara 打破了单一输入的限制。你可以同时喂给它“文字描述 + 参考图片 + 草图 + 起始帧”,模型会像人类艺术家一样,综合所有信息进行创作。这种设计让复杂的创意意图表达变得直观而简单。

架构揭秘:“左右脑”分工的解耦智慧

为了实现既“听得懂”复杂指令,又“画得出”精细画面,Capybara 采用了创新的解耦式双通路架构:

- 左脑(语义模块):

- 基于强大的预训练视觉语言模型(如 Qwen3-VL-8B-Instruct),负责“理解”。

- 它分析文字指令、解读参考图意图、拆解多模态约束。该模块在训练中保持冻结,确保保留顶级的语义推理能力。

- 右脑(视觉模块):

- 基于扩散模型架构,负责“创作”。

- 它接收左脑的语义信号,结合具体的视觉条件(如草图、姿态),在像素级别进行高质量的生成与重绘。

- 联合工作区 (MMDiT):

- 左右脑的信息在此深度融合,通过去噪过程逐步构建出最终的视觉内容。

这种设计巧妙避免了传统模型“懂但画不好”或“画得好但听不懂”的困境。

渐进式训练:从基础到精通

Capybara 并非一蹴而就,而是采用了科学的三阶段课程学习策略:

- 第一阶段:重建与上下文生成。基于 Hunyuan-Video-1.5 初始化,重点训练标准生成和基于草图/起始帧的条件生成,建立稳定的多模态接口。

- 第二阶段:编辑任务专项训练。引入指令编辑、参考图编辑及关键的传播任务,教会模型如何在保持原有内容不变的前提下,精准执行局部修改并推广至全局。

- 第三阶段:质量调优。使用高质量样本进行微调,大幅提升指令遵循度、视觉保真度及视频的时间稳定性(消除闪烁)。

此外,对于极复杂的任务,Capybara 还支持智能体闭环 (Agentic Creation) 模式:规划→编辑→评估→优化。智能体能自动拆解意图、生成候选、自我评估并迭代优化,直到产出完美结果。

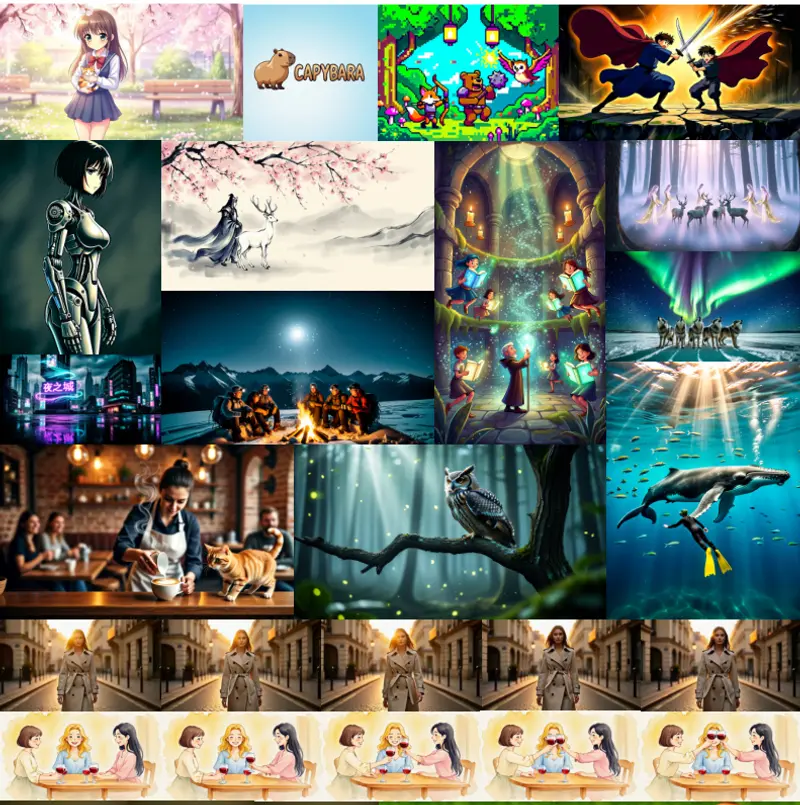

实测表现:全能且专业

虽然技术报告未披露具体定量指标,但大量定性展示证明了 Capybara 的卓越能力:

- 图像生成:涵盖写实、动漫、艺术插画等多种风格,细节丰富,构图合理。

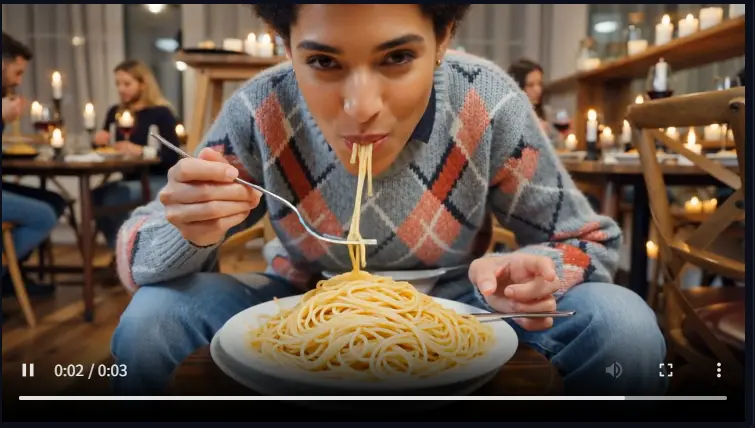

- 视频生成:运动自然流畅,主体身份稳定,无时间闪烁现象。

- 精准编辑:无论是“白天变黑夜”的光影重构,还是“更换服装”的物体替换,非编辑区域均保持高度一致。

- 关键帧传播:在长视频编辑中,仅需修改首尾几帧,中间过渡帧即可自动生成,且动作连贯、风格统一,极大提升了视频后期效率。

如何开始?

Capybara 已开放模型组件下载,主要包含两部分:

- 主模型:包含所有必需的生成与编辑权重。

- 改写模型:基于 Qwen3-VL-8B-Instruct,用于优化和理解复杂的用户指令。

| 组件 | 描述 | 来源 |

|---|---|---|

| 主模型 | 核心生成与编辑引擎 | Huggingface |

| 改写模型 | 指令理解与优化 (Qwen3-VL-8B) | Huggingface |

相关文章