来自南洋理工大学、北京大学和上海人工智能实验室推出新型3D生成模型LN3Diff,它是一个基于潜在空间的神经辐射场扩散模型,用于快速生成高质量的3D对象。

想象一下,你有一张2D图片或者一段文本描述,LN3Diff能够根据这些信息生成一个详细的3D模型,就像用文字或图片作为蓝图来构建一个三维的物体。

主要功能:

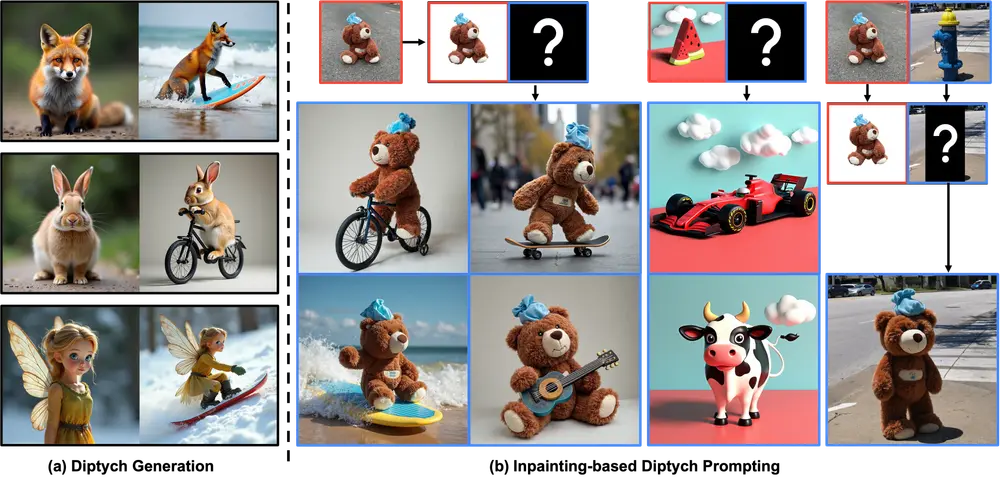

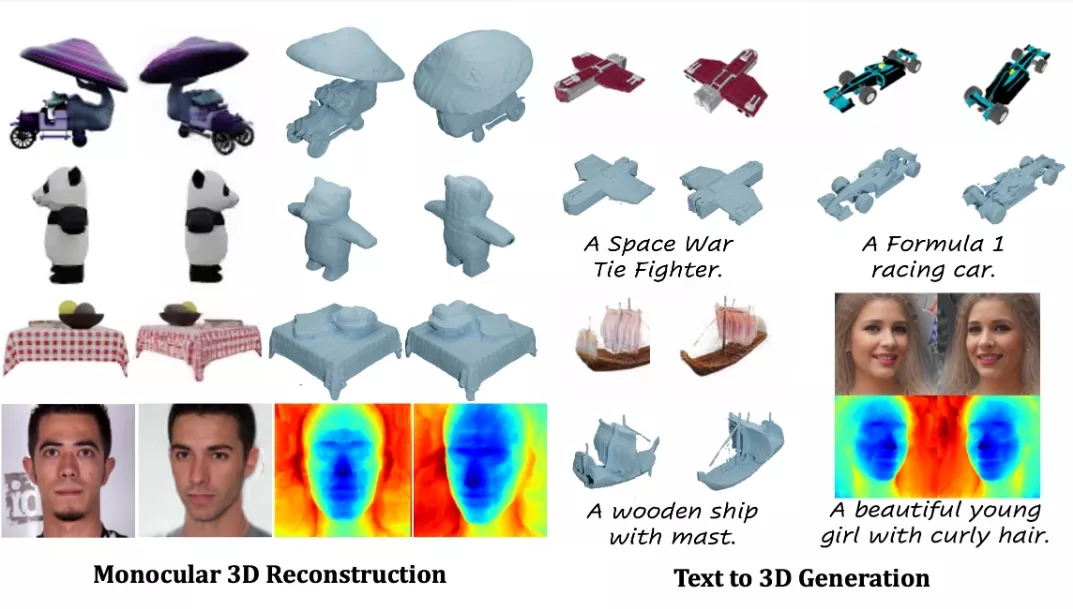

- 3D对象生成: 根据文本描述或2D图像生成高质量的3D模型。

- 单目3D重建: 使用单个视角的图像来重建3D场景。

- 条件3D生成: 可以根据特定的条件(如文本标签或图像)来生成3D对象。

主要特点:

- 高效率: LN3Diff在推理速度上优于现有的3D扩散方法,不需要每个实例的优化。

- 高质量: 在ShapeNet等3D生成基准测试中展示了卓越的性能。

- 通用性: 适用于各种数据集,包括具有挑战性的类别和复杂几何形状的数据集。

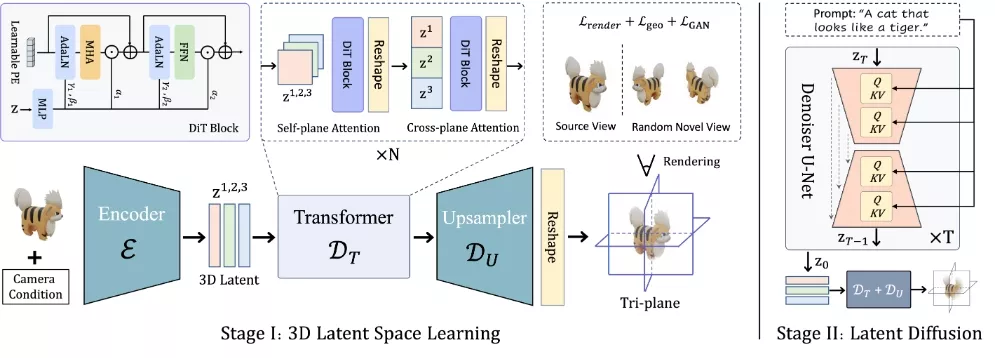

工作原理:LN3Diff的工作原理分为两个阶段:

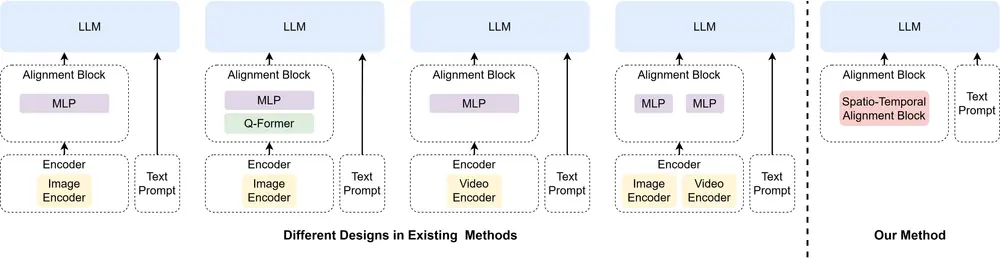

- 潜在空间学习: 使用变分自编码器(VAE)将输入图像编码到一个结构化、紧凑的3D感知潜在空间中。这个潜在空间通过基于Transformer的解码器逐步解码成一个高容量的3D神经辐射场。

- 潜在扩散学习: 在训练阶段,通过扩散模型在3D感知潜在空间上进行训练,以便在推理时能够生成高质量的3D对象。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...