随着大语言模型(LLMs)的发展,我们正进入一个代理式人工智能(Agent AI)时代。这些模型不仅能够生成文本,还能进行任务规划、逻辑推理,并调用外部工具来扩展能力边界。

但真正的前沿在于:不是仅仅使用已有工具,而是动态地创造新工具。通过为特定任务自动生成代码,模型可以实现更灵活、更具适应性的推理过程,这是迈向通用智能的重要一步。

PyVision 是什么?

由上海人工智能实验室、莱斯大学、香港中文大学和新加坡国立大学联合提出,PyVision 是一个交互式框架,允许多模态大型语言模型(MLLMs):

- 自主生成 Python 代码

- 在运行时执行并验证结果

- 根据反馈迭代优化推理过程

该框架基于 Python 丰富的库生态构建(如 OpenCV、Pillow、NumPy),并设计了一个稳健的运行时环境,支持 MLLM(如 GPT-4.1 和 Claude-4.0-Sonnet)与 Python 解释器之间的多轮交互。

- 项目主页:https://agent-x.space/pyvision

- GitHub:https://github.com/agents-x-project/PyVision

- Demo:https://huggingface.co/spaces/Agents-X/PyVision

🎯 不再是简单的函数调用 —— 模型将从零开始编写定制脚本,以解决当前视觉任务。

为什么 PyVision 重要?

传统方法的局限性:

早期神经符号系统(如神经模块网络)虽然具备良好的透明性和可解释性,但存在两个关键问题:

- 工具集固定,缺乏灵活性

- 多为单轮执行,难以迭代优化

而 PyVision 利用现代 MLLMs 的编码与推理能力,突破了这些限制:

- 动态生成工具:不再依赖预定义 API

- 多轮交互机制:逐步完善推理路径

- 领域与任务敏感:自动适配不同视觉任务

PyVision 的核心功能

| 功能 | 描述 |

|---|---|

| ✅ 动态工具生成 | 根据具体任务自动生成 Python 脚本 |

| ✅ 多轮交互 | 支持多次代码生成与结果反馈,逐步优化答案 |

| ✅ 任务适应性 | 自动匹配图像处理、医学分析、逻辑推理等场景 |

| ✅ 多模态输入 | 支持图像、视频等多种视觉输入结合文本提示 |

PyVision 的技术特点

| 特点 | 说明 |

|---|---|

| 🔁 动态工具生成 | 不依赖静态工具库,按需生成代码 |

| ⏳ 多轮交互框架 | 多次尝试优化推理路径,提升准确性 |

| 🧠 利用 Python 生态 | 结合 OpenCV、Pandas、NumPy 等库增强表达力 |

| 📊 任务与领域敏感 | 针对医学图像、遥感图像等不同场景自动调整策略 |

工作原理详解

1. 系统提示设计

PyVision 使用精心设计的系统提示,引导 MLLM:

- 如何访问输入图像

- 如何组织代码结构

- 如何返回最终推理结果

2. 代码生成与执行

- 每轮交互中,模型生成一段 Python 代码

- 代码在隔离环境中执行,输出结果(如数值、图像、可视化图表)回传给模型

- 模型基于结果更新上下文,准备下一轮推理

3. 多轮优化机制

- 模型通过多轮尝试不断修正错误

- 可识别视觉错觉、像素级差异等复杂现象

- 实现可验证、可追溯的推理流程

4. 工具分类体系

通过对生成代码的分析,PyVision 构建了四类工具模板:

| 类别 | 示例工具 |

|---|---|

| 基础图像处理 | 图像滤波、边缘检测、直方图分析 |

| 高级图像处理 | 分割、目标识别、特征提取 |

| 视觉提示与草图 | 绘制标注、绘制对比区域 |

| 数值与统计分析 | 计算面积、比较像素均值、误差分析 |

测试结果与性能提升

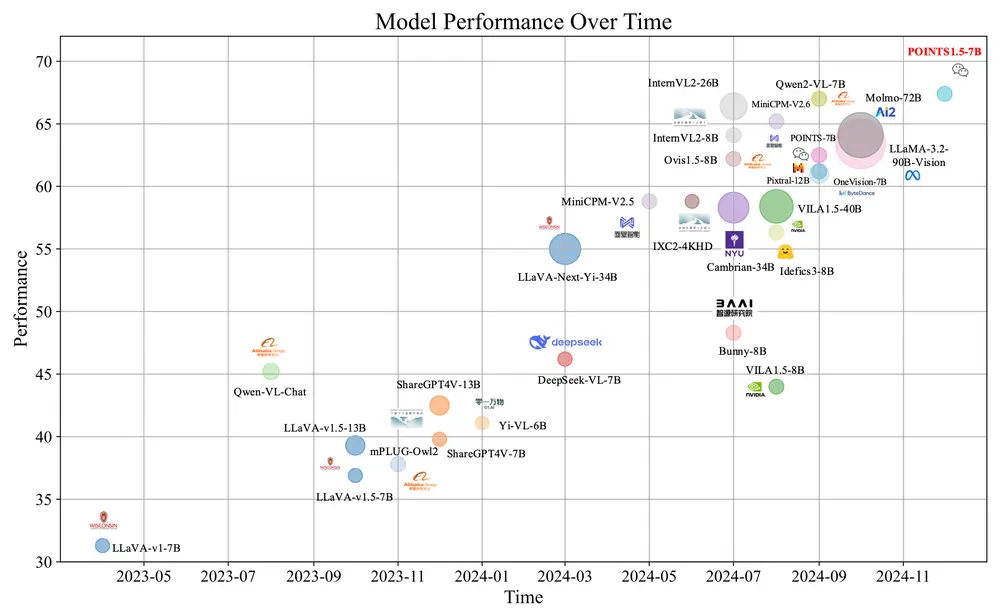

在多个基准数据集上,PyVision 显著提升了后端模型的表现:

| 模型 | 数据集 | 提升幅度 |

|---|---|---|

| GPT-4.1 | V* 数据集 | +7.8% |

| Claude-4.0-Sonnet | VLMsAreBlind-mini 数据集 | +31.1% |

性能提升的关键因素:

- 任务依赖性:不同模型在不同类型任务中表现各异

- Claude 更擅长抽象推理任务

- GPT 更擅长感知层面的任务

- 工具使用模式:

- Claude 通常生成更多代码块,逐步验证

- GPT 倾向于一次完成任务,代码更紧凑

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...