谷歌近日宣布推出其最新的开源医疗 AI 模型系列——MedGemma,并同时发布了轻量级图像编码器 MedSigLIP。这是继健康 AI 开发者基础(HAI-DEF)项目之后,谷歌在医疗 AI 领域迈出的重要一步。

这些模型不仅性能强大,还完全开源,旨在为全球开发者提供一个可定制、可扩展、注重隐私的医疗 AI 开发起点。

医疗 AI 的新方向:高效、灵活、安全

随着 AI 在医疗行业的广泛应用,从辅助诊断到患者管理,对 AI 系统的要求也日益提高:不仅要准确、高效,还要兼顾数据隐私和系统可控性。

为此,谷歌推出了 HAI-DEF 项目,作为一系列轻量级开源模型的基础平台。今年5月,谷歌进一步推出了 MedGemma 系列,基于 Gemma 3 构建,专为医疗与生命科学领域设计。

新模型发布:MedGemma 27B 多模态 + MedSigLIP 图像编码器

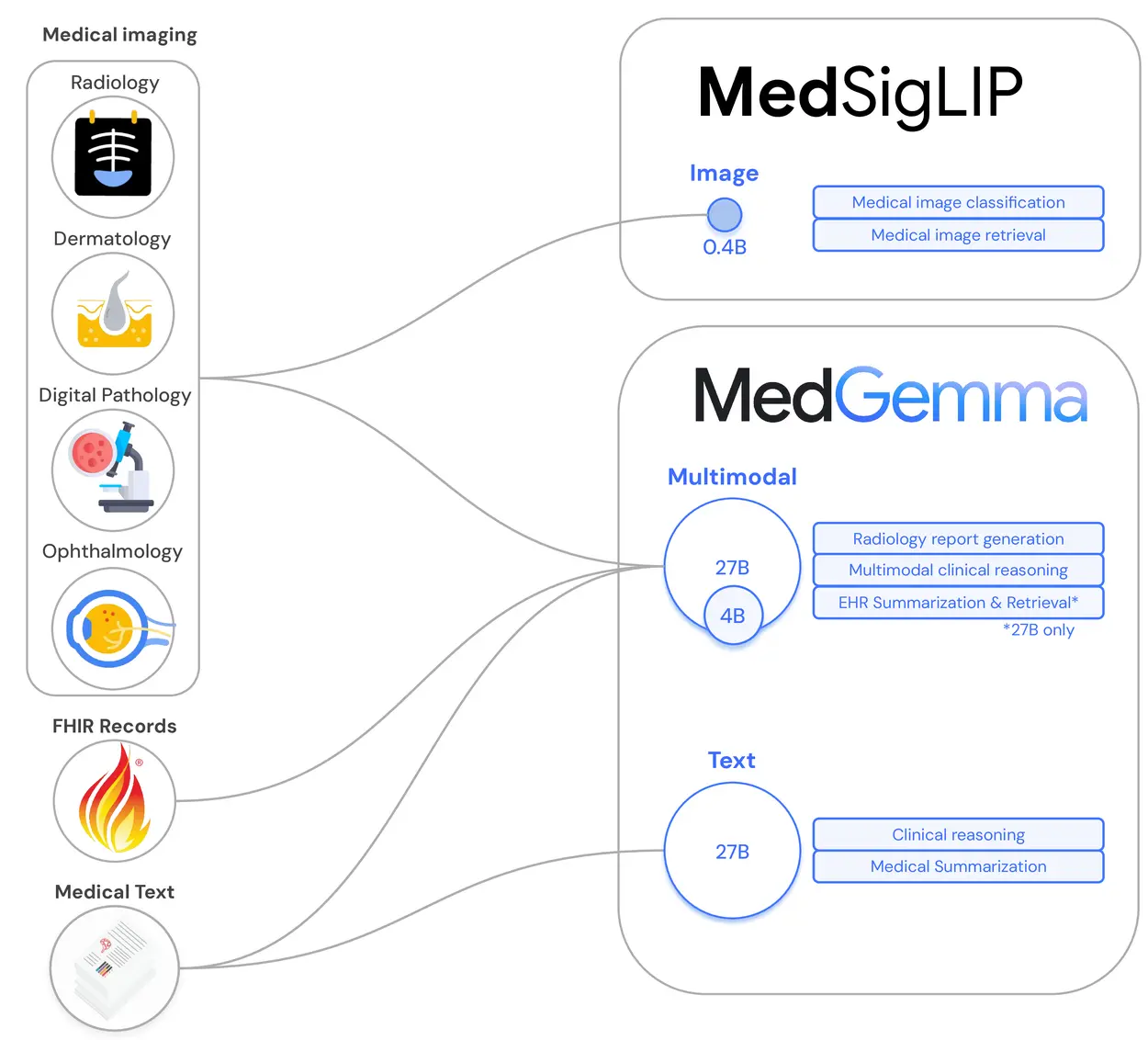

本次更新中,谷歌正式发布两款新模型:

✅ MedGemma 27B 多模态模型

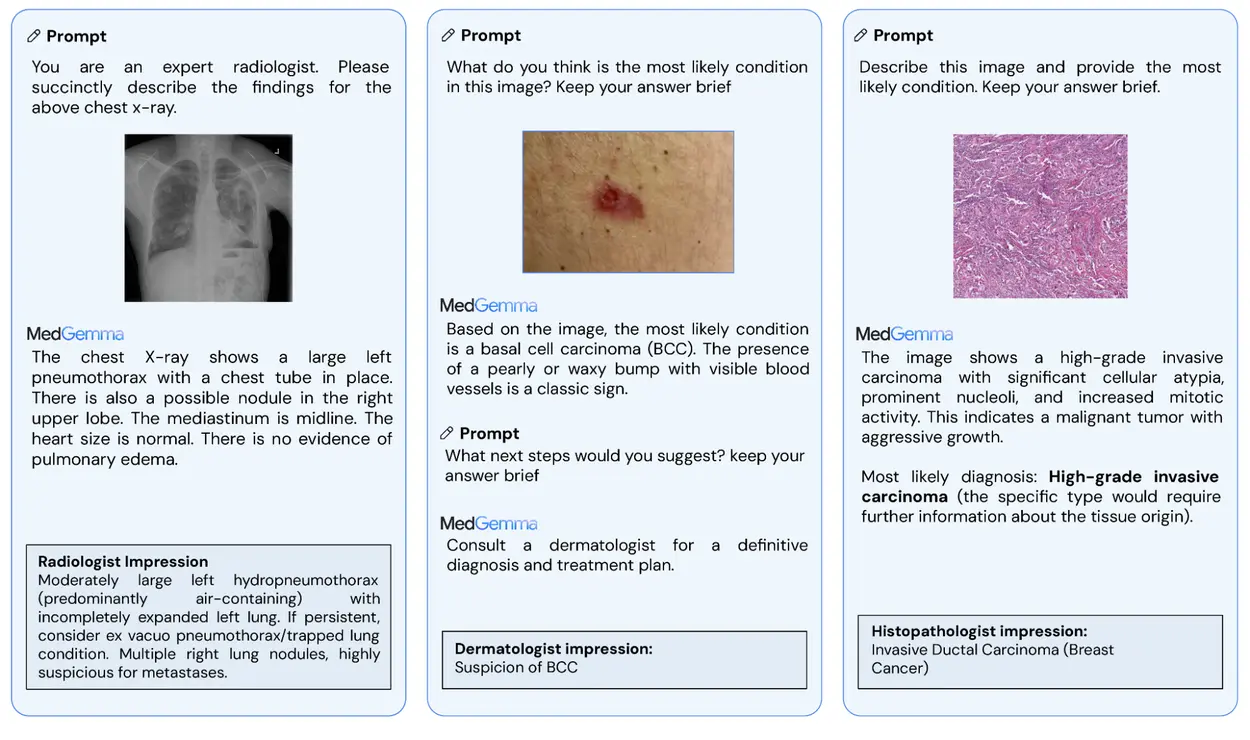

- 支持文本和图像输入,生成高质量文本输出。

- 可处理复杂多模态任务,如电子健康记录解读、医学影像分析等。

- 在多个医学基准测试中表现优异,是当前小型开源模型中性能最强之一。

✅ MedSigLIP

- 基于 SigLIP 架构构建的轻量级图像编码器(仅400M参数)。

- 经过医疗图像调优,适用于胸部X光、病理切片、皮肤病图像等多种医学影像任务。

- 同时保持对自然图像的强大识别能力,具备跨模态检索与分类功能。

性能亮点一览

| 模型 | 特点 | 应用场景 |

|---|---|---|

| MedGemma 4B 多模态 | 小型但高性能,在MedQA得分64.4%,81%医生认可其报告准确性 | X光报告生成、医学问答、结构化摘要 |

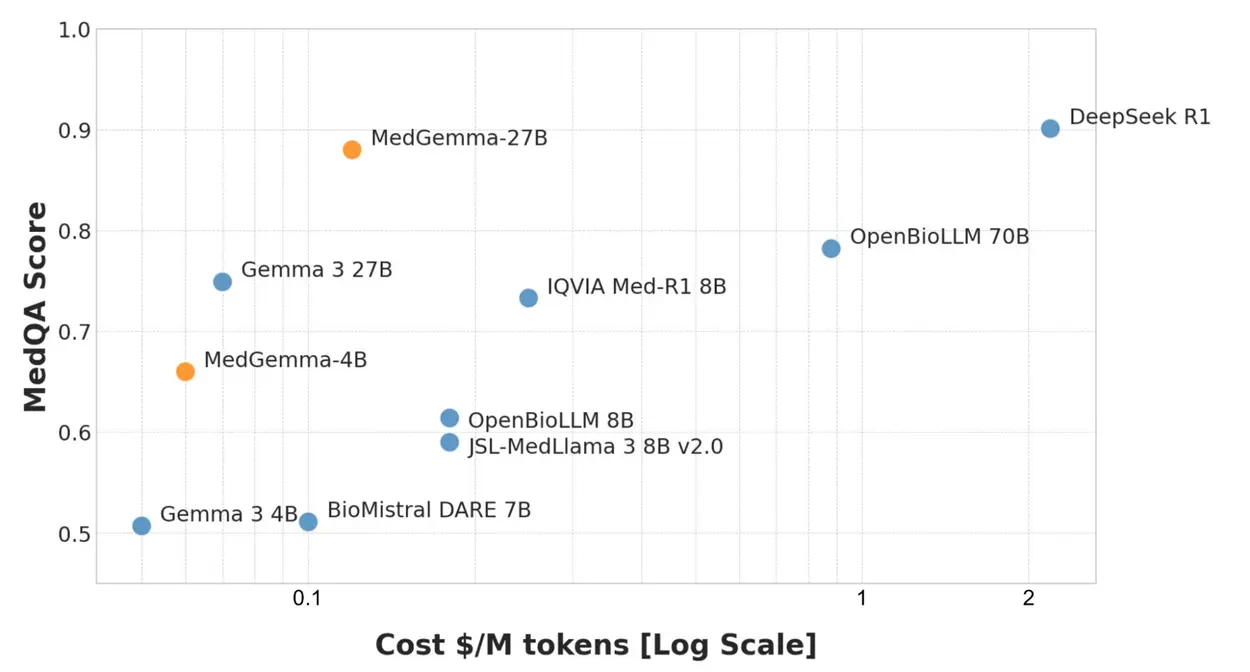

| MedGemma 27B 文本/多模态 | 更大规模,MedQA得分87.7%,接近DeepSeek R1水平,推理成本低至其十分之一 | 电子病历解读、医学知识推理、多模态问答 |

| MedSigLIP | 支持零样本分类、语义检索、图像匹配,适配多种医学图像 | 分类、检索、分诊辅助、图像相似度分析 |

值得一提的是,这些模型均可在单个 GPU 上运行,甚至 MedGemma 4B 和 MedSigLIP 还可在移动设备上部署。

技术架构与训练方式

MedGemma 系列基于 Gemma 3 构建,并通过专门优化的医学图像编码器进行训练。该编码器后来独立发布为 MedSigLIP。

谷歌特别强调保留了 Gemma 的通用能力,使 MedGemma 不仅适用于纯医疗任务,还能应对混合内容场景,并支持多语言指令响应。

开源的价值:灵活性、隐私与可重复性

开源是 MedGemma 系列的核心优势之一:

- 隐私保护:模型可本地部署,避免敏感数据上传云端。

- 高度定制:开发者可根据具体任务微调模型,提升特定场景下的性能。

- 稳定可靠:模型参数固定,不会因 API 更新而变动,保障医疗系统的稳定性与一致性。

如何开始使用?

谷歌已在 GitHub 上提供了详细的使用示例和微调指南,帮助开发者快速上手:

- 支持 Hugging Face 格式加载

- 可无缝集成到 Vertex AI 等云服务

- 提供演示代码与端点部署示例

此外,HAI-DEF 官网和 Hugging Face 页面均已上线相关资源,开发者可通过以下链接访问:

- 项目主页:https://deepmind.google/models/gemma/medgemma/

- 模型:https://huggingface.co/collections/google/MedGemma-release-680aade845f90bec6a3f60c4

⚠️ 使用免责声明

尽管 MedGemma 与 MedSigLIP 展现出强大的潜力,但它们仍需经过适当的验证与调整后才能用于实际医疗场景。

注意:这些模型不应用于直接指导临床诊断、治疗决策或任何直接影响患者的实践应用。

所有输出应视为初步结果,需结合专业判断与临床验证。

相关文章