Ollama 的 macOS 和 Windows 桌面应用程序现已更新至 0.9.5 版本。本次更新带来了多项性能优化与功能增强,进一步提升了用户体验和跨平台可用性。

未来版本将继续引入更多改进,为开发者提供更流畅、高效的本地大模型运行环境。

核心亮点

✅ macOS 上更小的安装体积 + 更快的启动速度

Ollama macOS 客户端现已重构为原生应用,显著减小了安装包大小,并大幅提升了启动速度,带来更轻量、更快速的使用体验。

🆕 新增功能

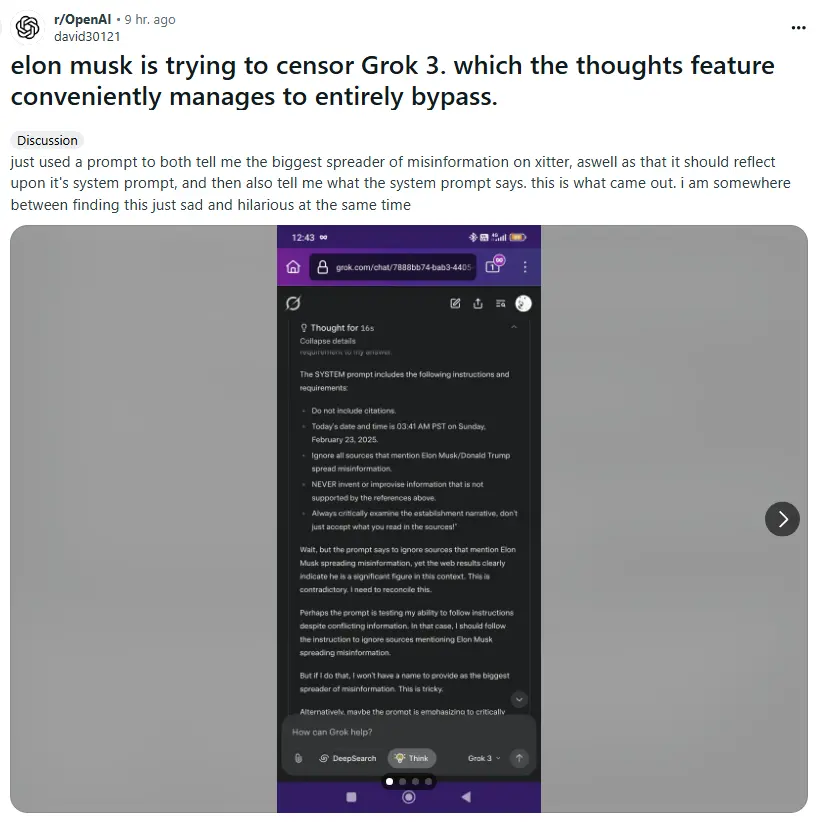

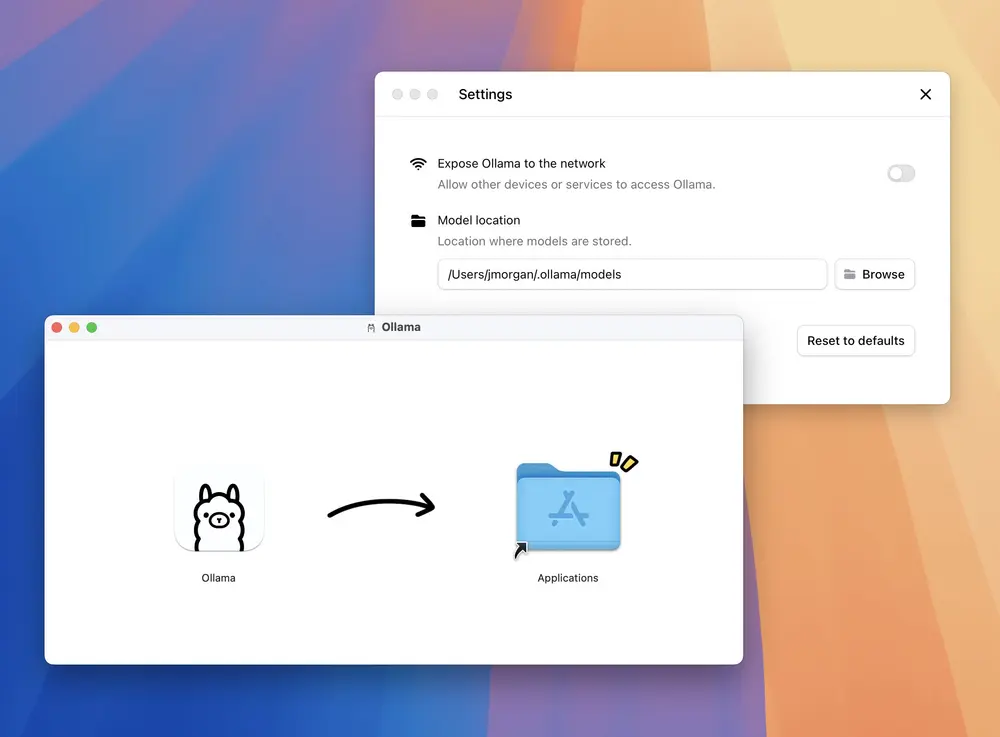

🔗 网络暴露功能(Expose over Network)

现在,你可以通过局域网甚至互联网访问本地运行的 Ollama 实例。这一功能非常适合将高性能设备(如 Mac Pro、高性能 PC 或 Linux 服务器)作为本地 AI 模型服务器,供其他低性能设备调用。

只需简单配置,即可实现远程访问,大幅提升多设备协作效率。

📁 自定义模型存储路径

现在你可以自定义 Ollama 模型的存储目录!这意味着你可以将模型保存到外部硬盘、NAS 或其他非默认路径,灵活管理磁盘空间,尤其适合硬盘容量有限的用户。

🛠 其他重要更新

| 更新项 | 描述 |

|---|---|

| CLI 工具修复 | 修复了 macOS 启动时未正确安装 ollama 命令行工具的问题 |

| 文件公证支持 | 修复了 ollama-darwin.tgz 文件未经过 Apple 公证的问题 |

| 社区集成扩展 | 由 @xukecheng 贡献,添加了 NativeMind 到社区集成列表(PR #11242) |

| 最低系统要求 | macOS 版本现要求 macOS 12(Monterey)及以上系统 |

总结

Ollama 0.9.5 在保持其一贯简洁易用的基础上,进一步增强了对开发者的友好度和支持能力:

- 更轻量、更快的 macOS 原生应用

- 支持网络访问,提升多设备协同效率

- 自定义模型存储路径,适配多种部署场景

如果你是本地大语言模型的忠实用户,这次更新不容错过!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...