Ollama 是一个开源的框架,专门设计用于简化在本地机器上部署和管理大语言模型,Ollama 提供了简单的命令行界面(CLI),用户可以通过一条命令快速启动和运行大型模型,支持多种预构建的模型,用户可以从官方模型库中选择并下载所需的模型,Ollama 支持多种操作系统,包括 macOS、Windows 和 Linux,并且提供了 Docker 镜像,以方便在不同环境中部署。

如何安装及运行Ollama?

1、下载Ollama安装包

从官网下载Ollama安装包,根据自己的系统进行下载

2、安装Ollama

下载完成后,双击安装包进行安装。在安装过程中,需要遵循安装向导的指示,按照步骤完成安装。需要注意的是Ollama不可以自定义安装路径,会强制安装在C盘。安装完毕后会打开命令提示符(CMD)。

3、下载模型

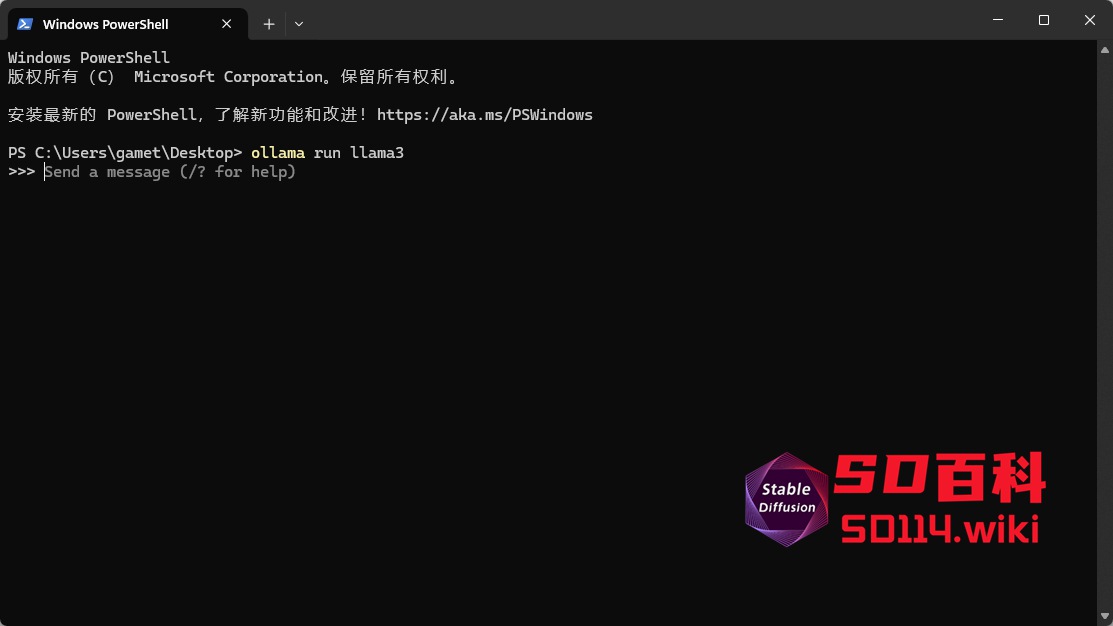

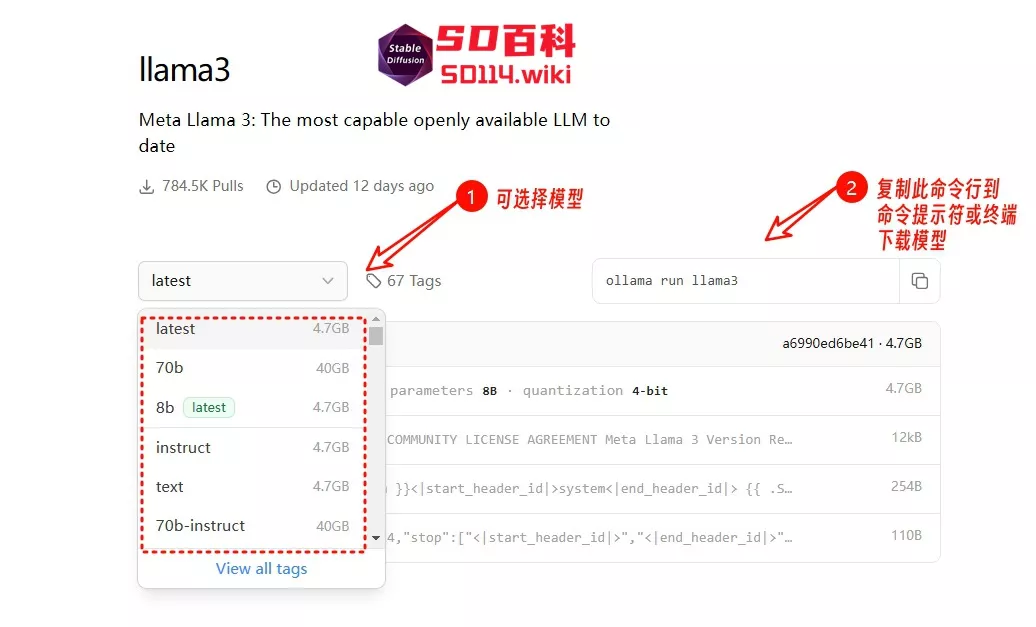

要在本地使用Ollama,我们还需要下载模型才可以,我们可以在官方的模型库找到适合在自己电脑上运行的模型,以llama3为例,复制命令行到命令提示符或终端,即可自动下载

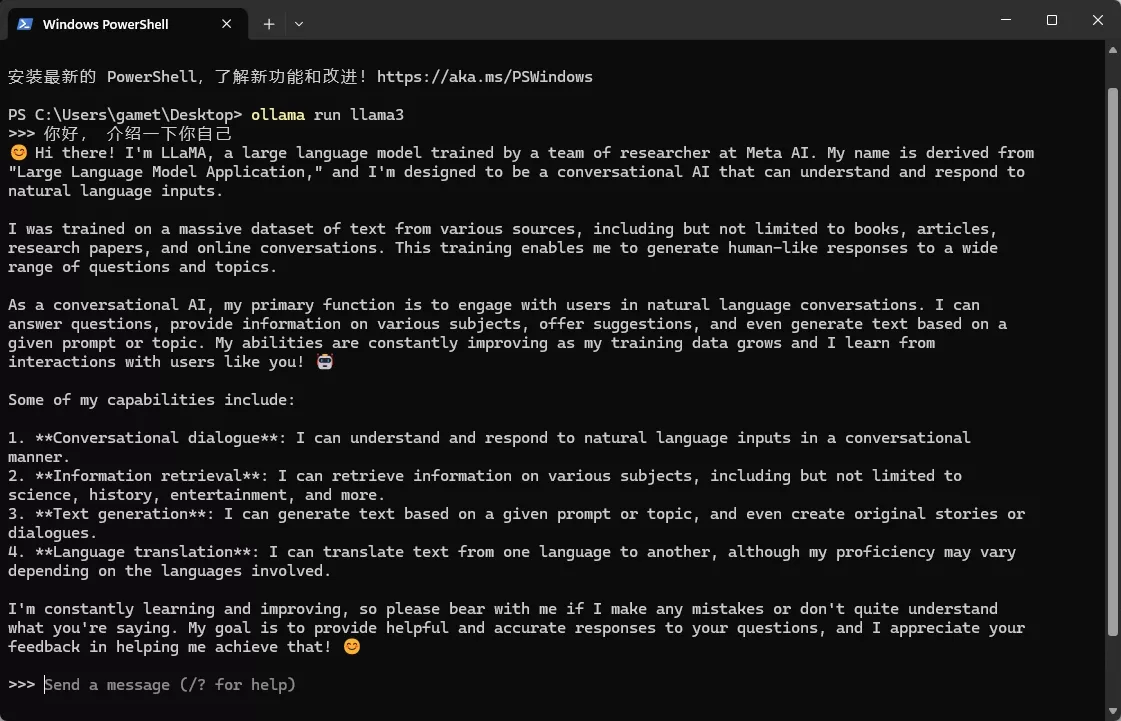

下载完毕后,即可开启对话。Ollama的Windows版本默认直接会调用本机的显卡,无需额外设置,Ollama不仅支持英伟达显卡还支持AMD显卡,当然也支持CPU运行,只是使用CPU运行会比较慢。

4、迁移模型

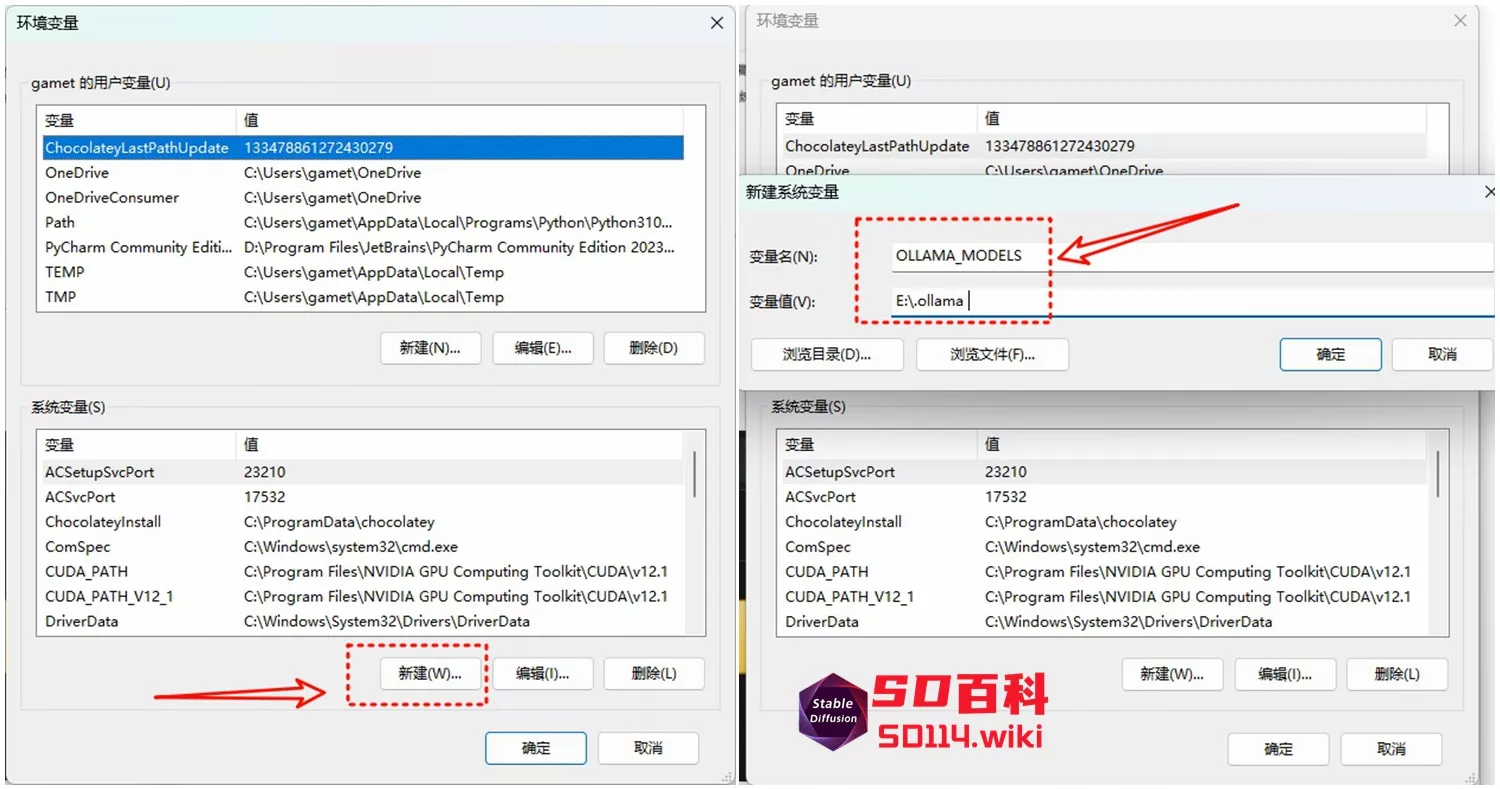

Ollama会将模型下载到C盘,如果你的C盘空间不足,可以更改默认路径,将模型下载到其他盘。可以通过新建环境变量OLLAMA_MODELS进行修改。

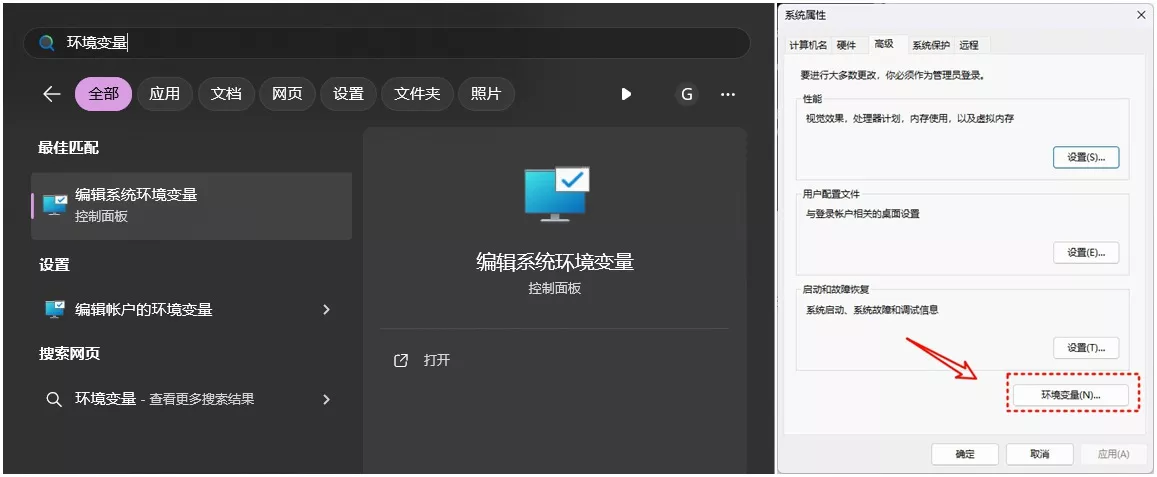

(1)在开始菜单搜索框搜索”环境变量“,打开系统属性界面,点击“环境变量”

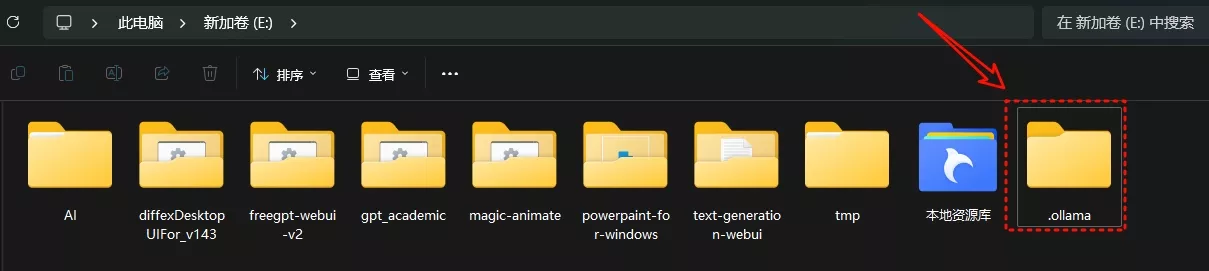

(2)在你容量比较大的盘,新建一个文件夹,重命名为.ollama

(3)在环境变量设置界面中,系统变量下方,点击“新建”按钮,创建名为OLLAMA_MODELS的新环境变量,并将其值设置为新的模型保存路径,例如E:\.ollama ,点击“确定”按钮保存设置,并重启电脑使修改生效

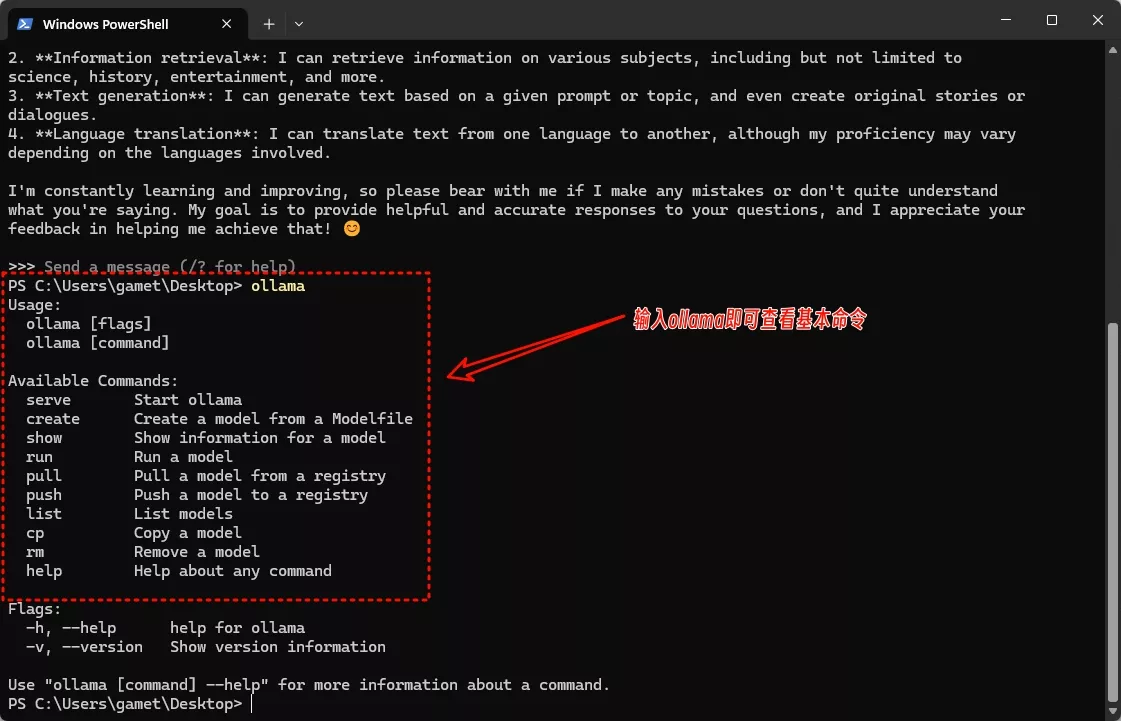

5、Ollama的基本命令

在命令提示符或终端里输入ollama回车,就能看到ollama的一些基本命令:

- ollama serve - 启动 Ollama 服务,允许在没有桌面应用程序的情况下运行 Ollama。

- ollama create - 根据 Modelfile 创建一个新模型。Modelfile 是一个定义模型配置的文件。

- ollama show - 显示一个模型的详细信息,包括其参数和状态。

- ollama run - 运行一个已存在的模型,可以与模型进行交互或执行特定的模型驱动任务。

- ollama pull - 从注册表中拉取(下载)一个模型,以便在本地使用。

- ollama push - 将一个模型推送(上传)到注册表,使其可以在其他位置使用或分享。

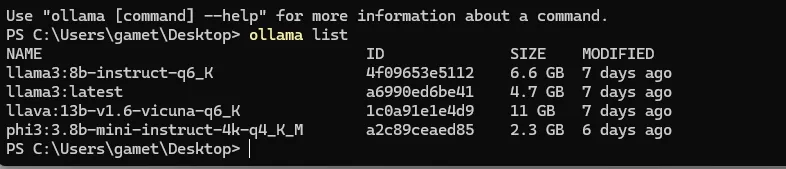

- ollama list - 列出当前可用的所有模型,包括那些已经下载到本地的模型。

- ollama cp - 复制一个模型,可以用于备份或在不同的配置下运行相同的模型。

- ollama rm - 删除一个本地模型,释放存储空间。

- ollama help - 提供关于任何命令的帮助信息,如果不确定如何使用某个命令,可以使用

help来获取使用指南。

比如ollama list,就可以查看已经下载的模型

如何使用Ollama?

在终端或命令提示符里就可以使用Ollama,不够易用,而开源的Ollama 有一系列开源工具供大家使用,包括网页、桌面、终端等交互界面及诸多插件和拓展。Ollama的GitHub页面,已经为大家列出了可供使用的工具:

Page Assist

Page Assist 是一款开源浏览器扩展,为你的本地 AI 模型提供侧边栏和 Web UI。它允许你从任何网页与你的模型进行交互。

Open WebUI

Open WebUI 是一个可扩展的、功能丰富的、用户友好的自托管 Web 用户界面(WebUI),它被设计为完全离线操作。它支持多种大型语言模型(LLM)运行器,包括 Ollama 和兼容 OpenAI 的 API。Open WebUI 具有最接近 ChatGPT 的界面和最丰富的功能特性,只是它需要以 Docker 部署。

- 推荐指数:⭐⭐⭐⭐⭐

- GitHub:https://github.com/open-webui/open-webui

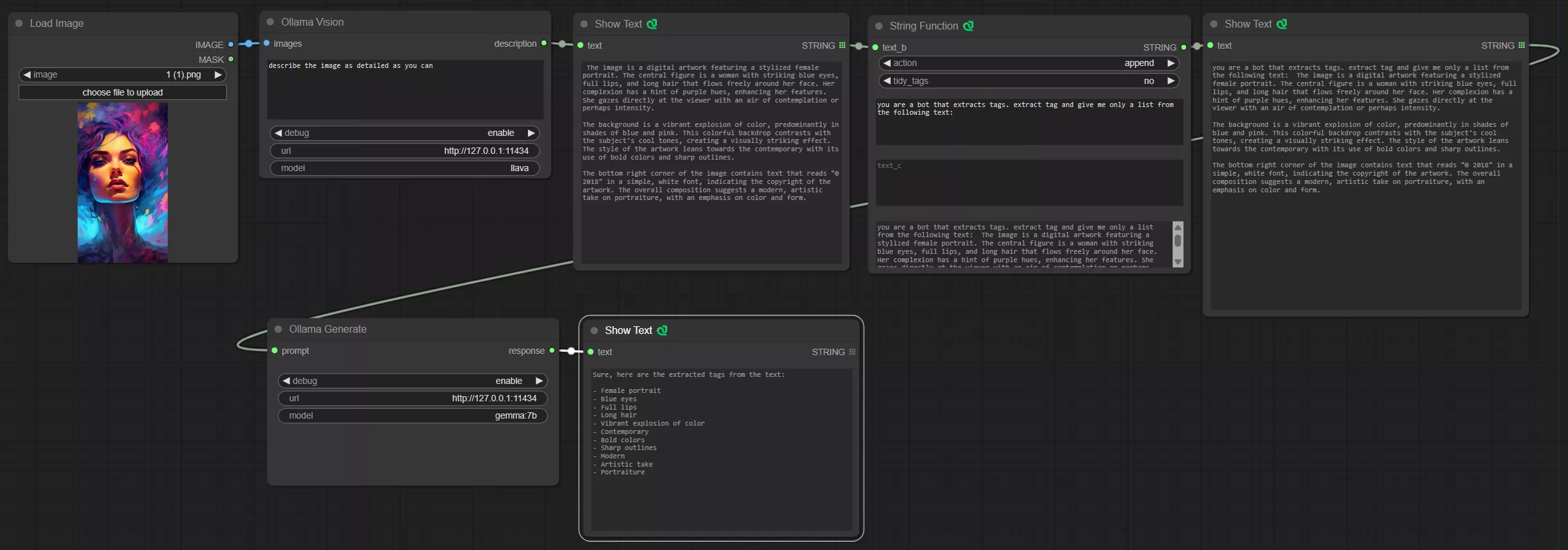

ComfyUI Ollama

这款插件让你可以在Comfyui中调用Ollama,不仅可以聊天还可以使用带视觉能力的模型生成图片描述,也可以自定义提示词对你的提示词进行润色,然后再进行图片生成。可以通过ComfyUI Manager安装此插件。

- 推荐指数:⭐⭐⭐⭐⭐

- GitHub:https://github.com/stavsap/comfyui-ollama

相关:

相关软件

PromptHub - 最新版

Skywork 桌面版 - 最新版

![Ollama的使用截图[1]](https://pic.sd114.wiki/wp-content/uploads/2025/02/1739699725-1739699725-Ollama-2.webp)