Ollama 是一个基于 llama.cpp 的应用,可以直接在本地运行开源的大语言模型,之前只能在官网上下载模型或者从Hugging Face上导入,有点麻烦,现在Ollama 与Hugging Face合作,大家可以通过命令行从Hugging Face下载GGUF格式的大模型,无需创建新的 Model 文件。目前Hugging Face上有超过4万5千多个开源的 GGUF格式模型,您可以使用一个简单的 ollama run 命令运行其中的任何一个。

相关:

开始使用非常简单:

ollama run hf.co/{username}/{repository}请注意,您可以使用 hf.co 和 huggingface.co 作为域名。

以下是一些您可以尝试的模型:

ollama run hf.co/bartowski/Llama-3.2-1B-Instruct-GGUF

ollama run hf.co/mlabonne/Meta-Llama-3.1-8B-Instruct-abliterated-GGUF

ollama run hf.co/arcee-ai/SuperNova-Medius-GGUF

ollama run hf.co/bartowski/Humanish-LLama3-8B-Instruct-GGUF自定义量化

默认情况下,使用 Q4_K_M 量化方案,当模型仓库中存在时。如果没有,我们将默认选择一个在仓库中存在的合理量化类型。

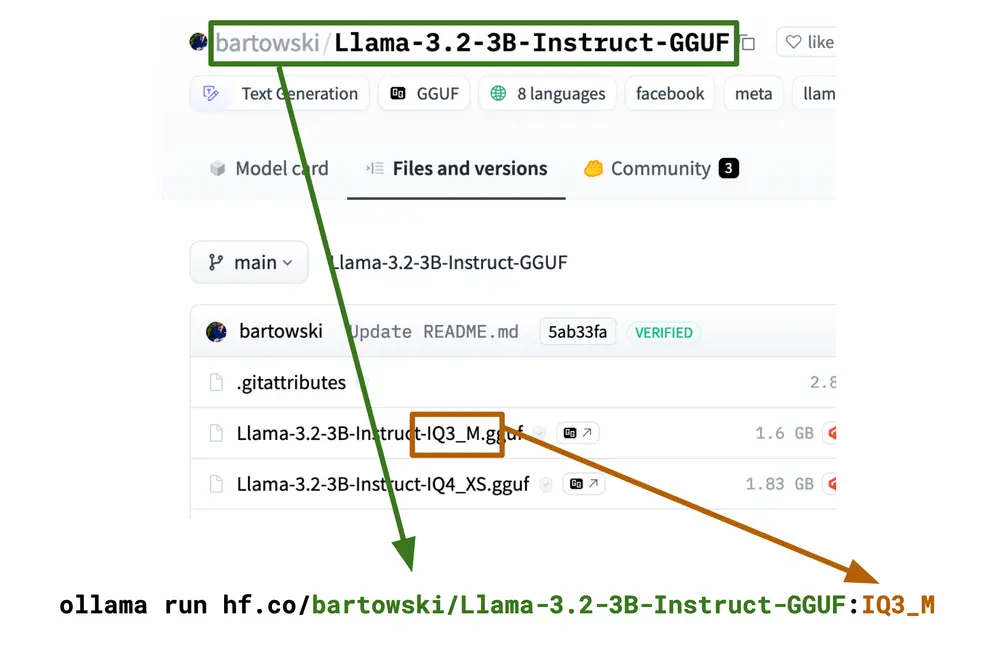

要选择不同的方案,只需添加一个标签:

ollama run hf.co/{username}/{repository}:{quantization}

例如:

ollama run hf.co/bartowski/Llama-3.2-3B-Instruct-GGUF:IQ3_M

ollama run hf.co/bartowski/Llama-3.2-3B-Instruct-GGUF:Q8_0

# 量化名称不区分大小写,这也可以

ollama run hf.co/bartowski/Llama-3.2-3B-Instruct-GGUF:iq3_m

# 您也可以直接使用完整文件名作为标签

ollama run hf.co/bartowski/Llama-3.2-3B-Instruct-GGUF:Llama-3.2-3B-Instruct-IQ3_M.gguf自定义聊天模板和参数

默认情况下,将自动从常用模板列表中选择一个模板。它将根据 GGUF 文件中内置的 tokenizer.chat_template 元数据选择。

如果您的 GGUF 文件没有内置模板,或者您想要自定义您的聊天模板,您可以在仓库中创建一个名为 template 的新文件。模板必须是 Go 模板,而不是 Jinja 模板。这里有一个例子:

{{ if .System }}<|system|>

{{ .System }}<|end|>

{{ end }}{{ if .Prompt }}<|user|>

{{ .Prompt }}<|end|>

{{ end }}<|assistant|>

{{ .Response }}<|end|>要了解有关 Go 模板格式的更多信息,请参阅这份文档

您可以选择性地通过在仓库中放入一个名为 system 的新文件来配置系统提示。

要更改采样参数,请在仓库中创建一个名为 params 的文件。该文件必须为 JSON 格式。有关所有可用参数的列表,请参阅这份文档。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...