首尔国立大学、 微软亚洲研究院和浦项科技大学的研究人员推出提出了一种**基于解耦身份和运动的主体驱动视频生成(Subject-driven Video Generation via Disentangled Identity and Motion)**的新方法,通过解耦主体特定的学习和时间动态,实现零样本(zero-shot)的主体驱动视频生成。这种方法的核心在于利用图像定制数据集(image customization dataset)直接训练视频定制模型,而无需依赖大规模的、标注的视频数据集,从而显著降低了数据获取和计算成本。

例如,我们有一张图片,内容是一只猫在草地上。使用这种方法,我们可以生成一个视频,其中这只猫在草地上奔跑,同时保持其身份特征(如毛色、体型等)的一致性,同时还能自然地模拟猫的运动和场景的变化。

主要功能

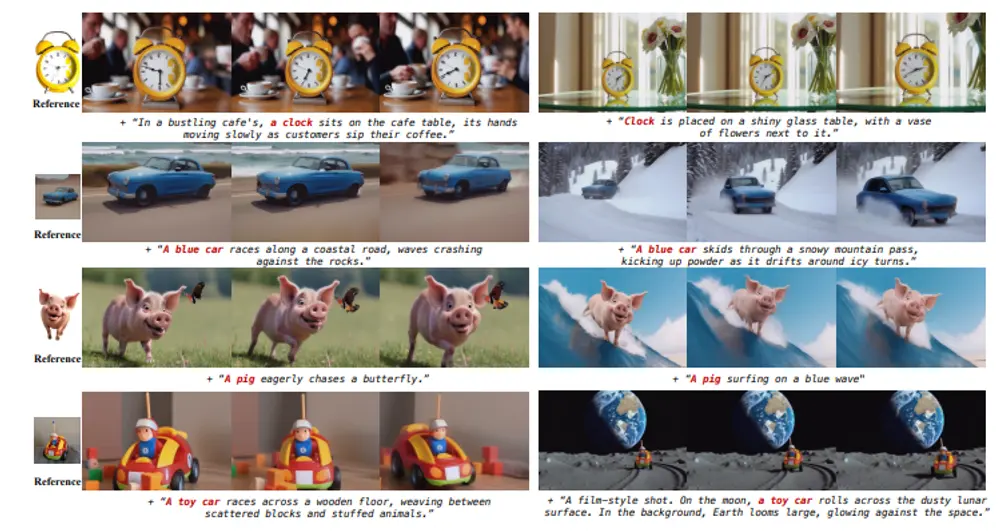

- 主体驱动视频生成:能够根据输入的主体图像生成与之相关的视频内容。

- 身份一致性:在生成的视频中保持主体的身份特征,即使在不同的场景和动作中。

- 时间连贯性:生成的视频在时间上具有连贯性,运动自然流畅。

- 零样本学习:无需针对每个主体进行优化或依赖大规模标注的视频数据集。

主要特点

- 解耦身份和运动:通过将视频生成任务分解为身份注入(identity injection)和时间动态保持(temporal awareness preservation)两个部分,分别利用图像数据和少量未标注视频数据进行训练。

- 随机切换训练:引入随机切换(stochastic switching)机制,在身份注入和时间动态保持之间交替优化,避免灾难性遗忘(catastrophic forgetting)。

- 随机帧选择和图像令牌丢弃:通过随机选择参考帧和丢弃图像令牌,减少模型对单一参考帧的过度依赖,提高视频生成的多样性和自然性。

工作原理

- 身份注入:使用图像定制数据集(S2I dataset),通过微调预训练的视频合成模型,注入主体特定的特征。

- 时间动态保持:利用少量未标注的视频数据集(I2V fine-tuning),通过单帧引导视频生成,保持模型的时间动态能力。

- 随机切换训练:在每个训练迭代中,根据概率参数 ( p ) 随机选择是进行身份注入训练还是时间动态保持训练,平衡两者的优化目标。

- 随机帧选择和图像令牌丢弃:在I2V微调中,随机选择参考帧并丢弃图像令牌,减少模型对特定帧的过度依赖,提高视频生成的自然性。

测试结果

论文通过多个基准测试和定性比较验证了方法的有效性:

- 定量结果:在VBench基准测试中,该方法在运动平滑度(98.72)、动态程度(60.19)、文本对齐(CLIP-T: 32.24)和身份一致性(DINO-I: 59.29)方面均优于现有的视频定制模型。

- 定性结果:生成的视频在保持主体身份的同时,展示了自然的时间过渡和运动,优于其他基线方法。

- 人类偏好研究:在人类偏好研究中,该方法在身份一致性、提示对齐、运动质量和整体视觉吸引力方面均优于基线方法。

通过这种方法,论文展示了在无需大规模标注数据的情况下,如何高效地生成高质量的主体驱动视频,为视频生成领域提供了一种新的视角和解决方案。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...