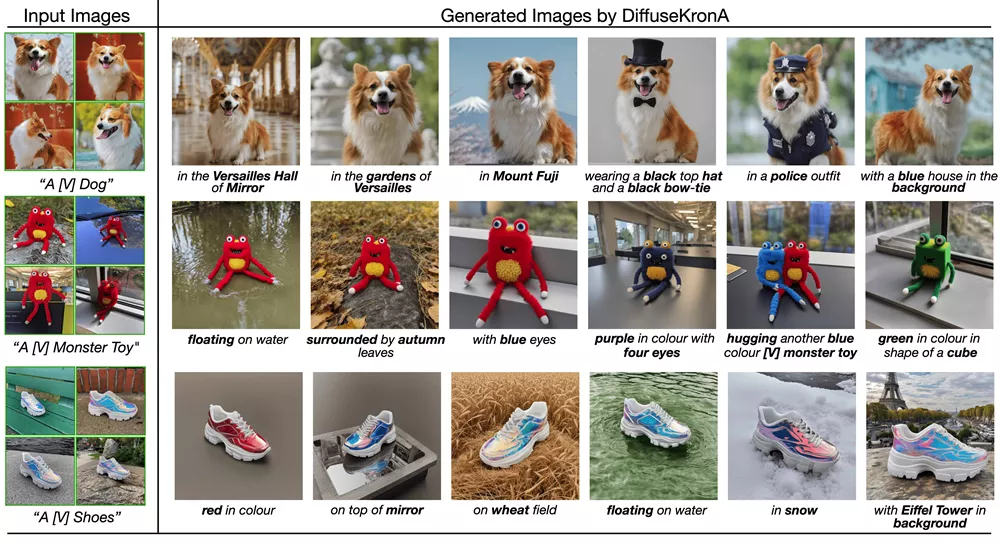

来自印度信息技术研究所、Hugging Face、阳明交通大学、IBM 研究院的研究人员提出一种用于个性化扩散模型的参数高效微调方法DiffuseKronA,主要功能是在保持图像生成质量的同时,显著减少模型的参数数量。

利用Kronecker积的方法进行微调。这种方法可以减少35%到99.947%的可训练参数,相比现有方法如LoRA-DreamBooth和原始DreamBooth,参数数量显著减少。此外,DiffuseKronA还能够提高图像生成的质量,并解决了超参数敏感性的问题。

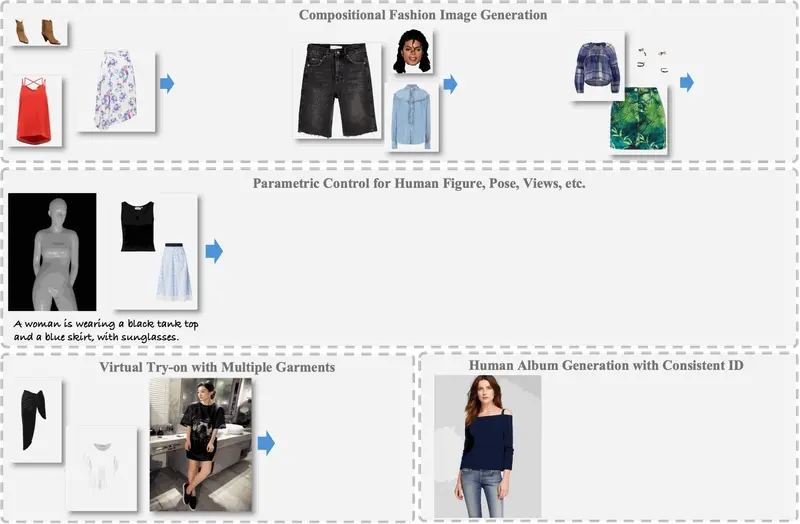

主要功能:

- 利用少量训练样本(通常为3到5张),DiffuseKronA可以生成具有特定主题的高质量图像。

- 该技术能够保持原始模型的生成能力,同时引入新的主题。

- 通过调整Kronecker因子,可以实现高达50%的参数减少,同时保持与全量微调模型相当的结果质量。

主要特点:

- 参数效率高:相比LoRA-DreamBooth减少了35%的训练参数,比原始DreamBooth减少了99.947%。

- 稳定性强:在不同的超参数设置下,生成的图像质量保持一致性,降低了过度依赖超参数调整的依赖性。

- 文本对齐和保真度高:能更好地捕捉输入文本中的语义细节,并产生与文本高度一致的图像。

- 可解释性强:通过更可控的分解方式,使得DiffuseKronA更加透明和易于理解。

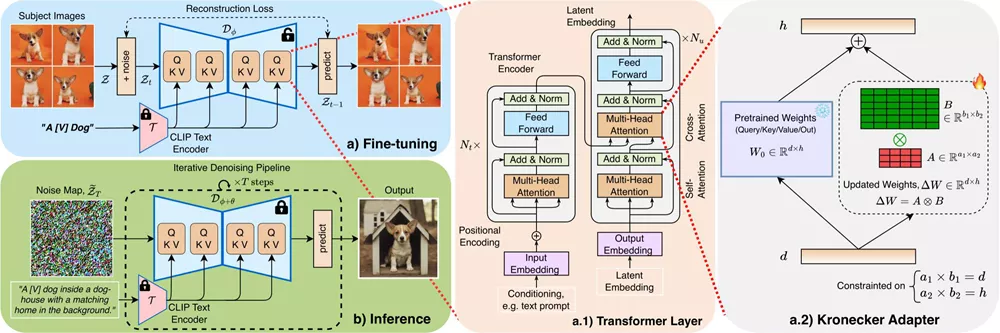

工作原理:

- DiffuseKronA基于Kronecker乘积,这种数学操作允许不同大小的矩阵相乘,从而捕获数据中复杂的模式和关系。

- 通过更新注意力层中的权重矩阵,而不是整个网络,DiffuseKronA实现了高效的参数更新。

- 使用两个可控的Kronecker因子,可以根据需要调整模型的表示能力和参数数量。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...