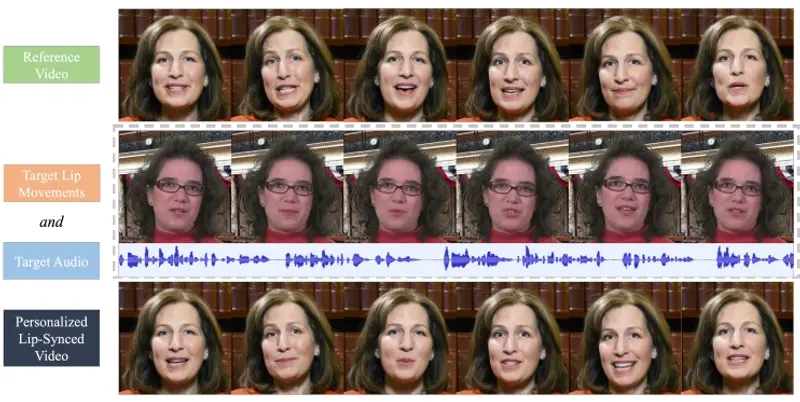

PaLM2-VAdapter模型的主要目的是更有效地连接视觉编码器和大语言模型,以提高它们之间的协同工作效果。

它能够有效地将传统的视觉编码器(vision encoders)和大语言模型(LLMs)结合起来,以提高视觉-语言(vision-language)任务的性能。PaLM2-VAdapter通过渐进式对齐策略训练一个小型的PaLM2语言模型作为视觉-语言适配器,从而在保持模型参数数量较少的情况下,实现快速收敛、高性能和强可扩展性。

主要功能:

- 将视觉编码器和大型语言模型结合起来,提高视觉-语言任务的性能。

- 使用渐进式对齐策略训练小型PaLM2语言模型作为适配器。

主要特点:

- 渐进式对齐策略: 分为两个阶段训练,首先作为语言模型解码器,然后作为视觉-语言适配器。

- 快速收敛: 相比于现有的适配器架构,PaLM2-VAdapter需要更少的训练步骤就能达到收敛。

- 高性能: 在多个视觉问答(VQA)和图像/视频描述任务上,PaLM2-VAdapter展现出与最新技术相媲美的性能。

- 强可扩展性: 当视觉编码器和语言模型的规模增加时,PaLM2-VAdapter的性能有显著提升。

工作原理:

- 第一阶段(LM解码器训练): 使用预训练的小型PaLM2模型作为语言模型解码器,通过视觉-语言生成任务进行微调。

- 第二阶段(适配器训练): 在第一阶段训练的基础上,添加一个额外的感知器重采样器(perceiver resampler)层,将小型PaLM2模型训练为视觉-语言适配器,以对齐相同的视觉编码器和更大的PaLM2解码器。

应用场景:

- 图像和视频描述: PaLM2-VAdapter可以用于生成图像和视频的描述,帮助用户理解视觉内容。

- 视觉问答: 在图像或视频中提出问题,PaLM2-VAdapter能够提供准确的答案,适用于教育、娱乐和辅助技术等领域。

- 多模态内容创作: 利用PaLM2-VAdapter,可以结合文本和视觉信息创作新的多媒体内容,如自动生成故事、剧本等。

PaLM2-VAdapter通过创新的渐进式对齐策略,有效地结合了视觉和语言模型,提高了视觉-语言任务的效率和性能,同时减少了模型参数数量,为多模态学习和应用开辟了新的可能性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...