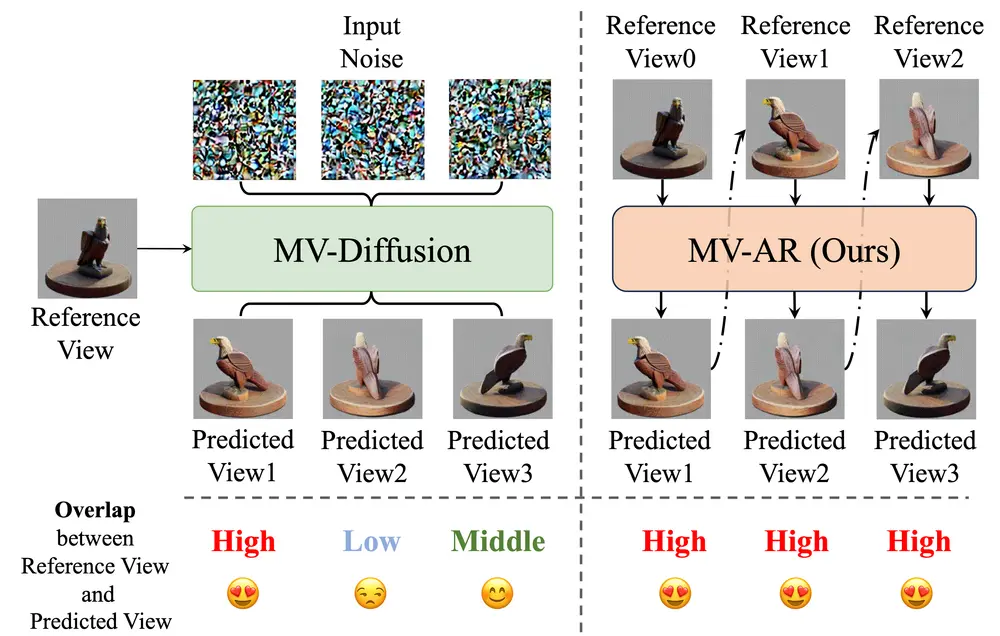

华中科技大学的研究团队聚焦于潜在扩散模型(latent diffusion models)中的优化困境,即视觉分词器(visual tokenizer)中每令牌特征维度的增加虽能提升重建质量,但会降低生成性能,且需要更大的扩散模型和更多训练迭代来实现可比的生成效果。例如,我们有一个图像生成任务,需要在保持图像细节的同时,快速生成高质量的图像。传统的LDMs在提高视觉标记器的特征维度以增强重建质量时,会遇到生成性能下降的问题。该团队提出的VA-VAE(Vision foundation model Aligned Variational AutoEncoder)和LightningDiT框架,可以在不牺牲重建质量的前提下,显著提升生成性能。

- GitHub:https://github.com/hustvl/LightningDiT

- 模型:https://huggingface.co/hustvl/lightningdit-xl-imagenet256-800ep

主要功能

主要特点

工作原理

VA - VAE 的训练

- 利用视觉基础模型对齐:在训练视觉分词器时,通过 VF Loss 将其潜在空间与预训练的视觉基础模型(如 DINOv2、MAE 等)进行对齐。对于给定图像,同时经过视觉分词器编码器和冻结的视觉基础模型处理,得到图像潜在表示和基础视觉表示,然后通过线性变换将视觉分词器的潜在表示投影到与基础模型相同的维度,计算两者之间的边际余弦相似度损失和边际距离矩阵相似度损失,以优化潜在空间。

- 自适应权重调整:采用自适应加权机制,在反向传播前计算重建损失和 VF Loss 在编码器最后卷积层上的梯度,根据梯度比值设置自适应权重,确保 VF Loss 和重建损失对模型优化有相似影响,从而快速对齐不同 VAE 训练管道中的损失尺度,同时仍可手动调整超参数进一步优化性能。

LightningDiT 的构建与训练

- 模型架构与训练设置:以 DiT - XL/2 为基础模型,采用 SD - VAE(f8d4 规格)作为视觉分词器,利用预提取的分词器潜在特征在 ImageNet 上进行训练。设置 DiT 的 patch size 为 1,确保整个系统下采样率为 16,其他架构参数与 DiT 一致。训练过程中采用多种优化策略,如计算层面的加速、扩散优化和模型架构优化等,且观察到不同加速策略间的非正交性,进行了合理组合。

- 渐进训练策略:对于使用 VF Loss(DINOv2)的分词器,采用渐进训练策略延长训练时间至 125 个周期,以获得更强生成能力的 VA - VAE,然后使用 LightningDiT - XL 在特定参数设置下训练 800 个周期,在训练后期调整 lognorm 参数以提升学习效果。采样时使用 250 步 Euler 积分器,并采用 cfg interval 和 timestep shift 等技术提升采样性能。

具体应用场景

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...