12月16日,无问芯穹宣布正式开源其“端模型+端软件+端IP”端上智能一体化解决方案中的小模型——Megrez-3B-Omni,以及纯语言版本模型 Megrez-3B-Instruct。这一举措标志着端侧智能技术的重大突破,特别是在多模态理解和推理效率方面。

- Megrez-3B-Instruct:https://huggingface.co/Infinigence/Megrez-3B-Instruct

- Megrez-3B-Omni:https://huggingface.co/Infinigence/Megrez-3B-Omni

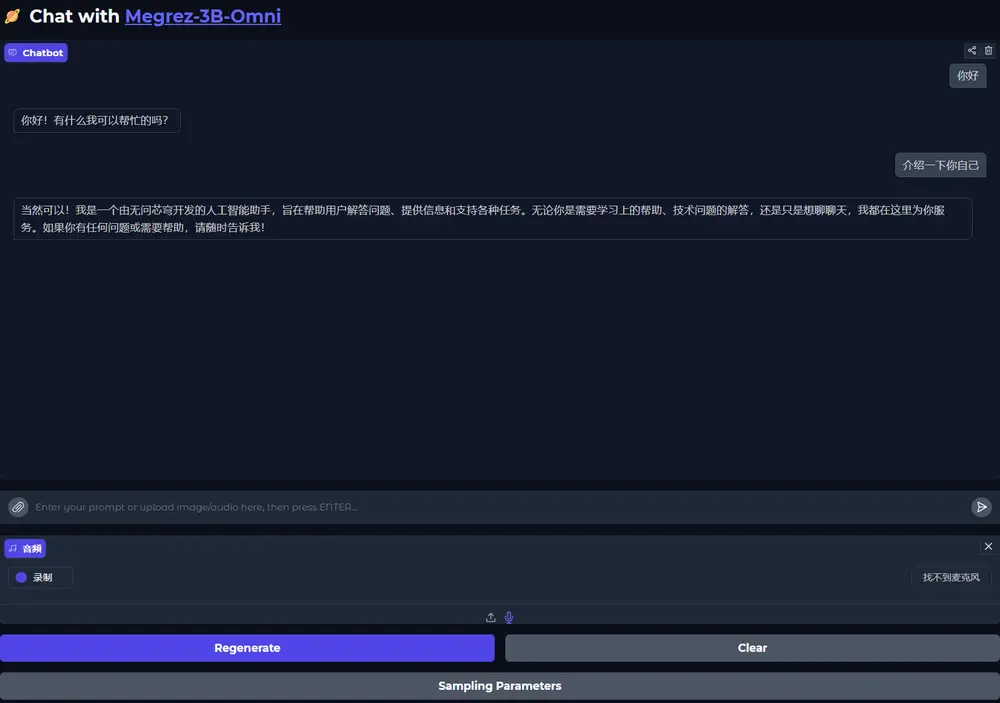

- Demo:https://huggingface.co/spaces/Infinigence/Megrez-3B-Omni

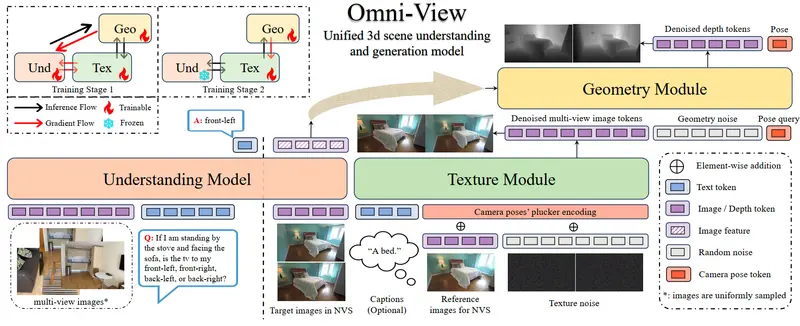

Megrez-3B-Omni 是全球首个端侧全模态理解开源模型,专为手机、平板等端侧设备设计,具备图片、音频、文本三种模态数据的处理能力。该模型在多个主流测评基准中取得了最优性能,显著提升了端侧设备的智能水平和用户体验。

模型特点

1、全模态高性能

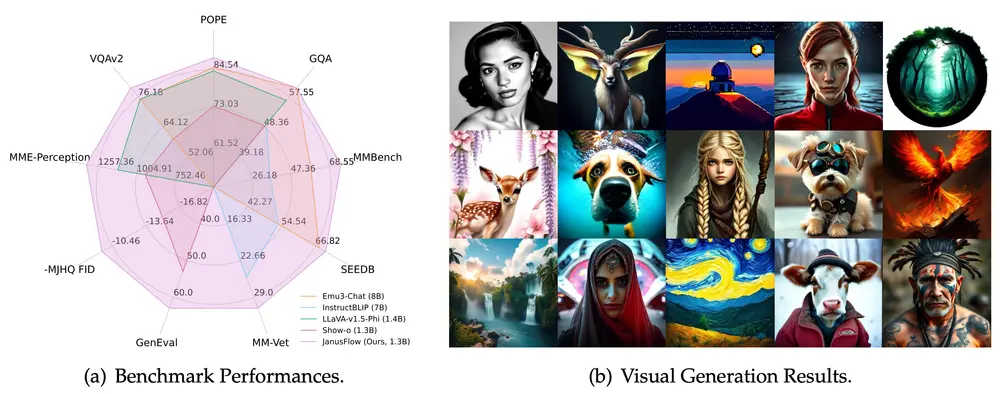

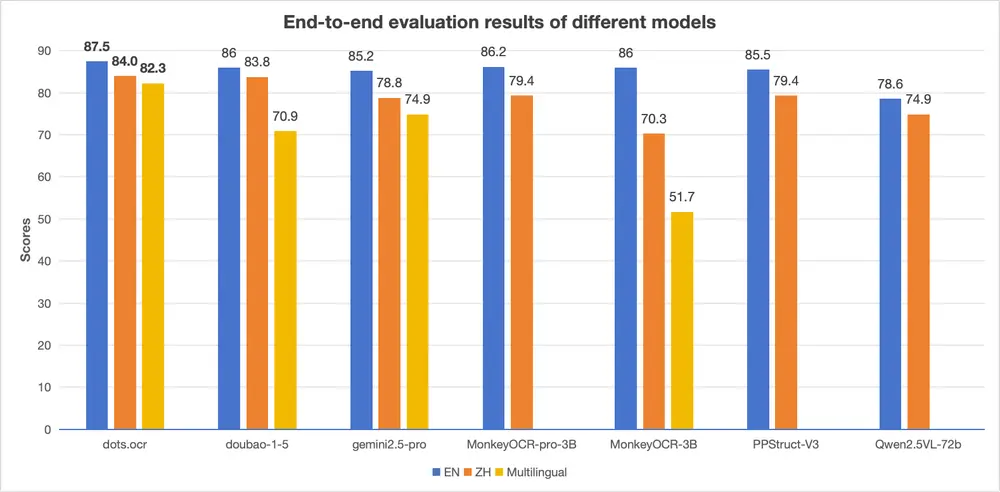

- 图片理解:Megrez-3B-Omni 在图像理解方面表现出色,尽管模型规模仅为30亿参数,但其综合性能可以全面超过34B参数的大型模型,如 LLaVA-NeXT-Yi-34B。它在 OpenCompass、MME、MMMU、OCRBench 等多个主流测试集上取得了最高精度,尤其在场景理解、OCR(光学字符识别)等任务中表现优异,能够准确识别模糊的印刷体和复杂的手写字。

- 文本理解:作为全模态理解模型,Megrez-3B-Omni 没有牺牲文本处理能力,反而将上一代14B大模型的优秀能力压缩至3B规模,显著降低了计算成本并提升了计算效率。它在 C-EVAL、MMLU/MMLU Pro、AlignBench 等权威测试集上取得端上模型最优精度,成为全球领先的文本理解模型。

- 音频理解:Megrez-3B-Omni 支持中文和英文的语音输入,并能够处理复杂的多轮对话场景。它不仅支持对输入图片或文字的语音提问,还能实现不同模态间的自由切换,用户可以通过语音指令直接获取文本响应,提供更直观、自然的交互体验。

2、令人惊叹的推理效率

- 软硬件协同优化:Megrez-3B-Omni 通过深入理解硬件特性,采用软硬件协同优化策略,确保各参数与主流硬件高度适配,最大化硬件性能的利用。与上一代及其他端侧大语言模型相比,单模态版本的 Megrez-3B-Instruct 在推理速度上取得了显著提升,最大推理速度可以领先同精度模型 300%。

3、多场景灵活应用

- WebSearch 功能:Megrez-3B-Instruct 集成了 WebSearch 功能,能够智能判断何时需要调用外部工具进行网页搜索,辅助回答用户的问题。用户可以构建属于自己的 AI 搜索系统,通过网络获取最新信息,克服小模型的幻觉问题和知识储备不足的局限。模型能够在搜索和对话之间智能切换,避免过度依赖搜索或完全不调用搜索的问题,提供带参考信息的结构化输出。

端上智能一体化解决方案

无问芯穹的技术团队源自清华大学电子工程系 NICS-EFC 实验室,在模型压缩、推理加速及硬件能耗优化等领域拥有深厚的学术研究和工程实践经验。他们致力于为端侧设备提供更完整、对硬件利用更高效的智能方案,推动大模型在端侧设备上的高效部署和运行。

1、 端模型

- Megrez-3B-Omni 和 Megrez-3B-Instruct 是该解决方案的核心组成部分,专为端侧设备优化,能够在资源有限的环境中快速部署并高效运行。

2、端软件

- 无问芯穹提供了端上推理软件,支持 CPU、GPU 和 NPU 的同时推理,并通过跨越软硬件层次的系统优化,额外带来最高可达 70% 的性能提升,最大化端侧硬件性能的利用。

3、端IP

- 无问芯穹还提供了 IP 设计方案,进一步优化了端侧设备的硬件架构,确保模型在不同硬件平台上的高效运行。

未来展望

无问芯穹表示,Megrez-3B-Omni 是一个能力预览,未来将继续迭代 Megrez 系列,提升自动化水平至“edge device use”效果,让用户只需要给出简单的语音指令,即可完成端设备的设置或应用操作。通过“端模型+端软件+端IP”一体化设计,无问芯穹将持续致力于为端侧设备提供更完整的智能解决方案,促进大模型在端侧设备上的高效部署,推动端侧智能更快迎接 AGI(通用人工智能)的到来。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...