香港中文大学、英伟达、上海人工智能实验室、InnoHK和香港理工大学的研究人员推出新型方法StreamChat,它旨在增强大型多模态模型(LMMs)与流媒体视频内容的交互能力。在流媒体交互场景中,现有方法仅依赖于提问时刻可用的视觉信息,导致模型在解码过程中无法感知后续视频流的变化,从而产生显著延迟。StreamChat通过在每个解码步骤更新视觉上下文,确保模型在整个解码过程中使用最新的视频内容,从而解决这一限制。

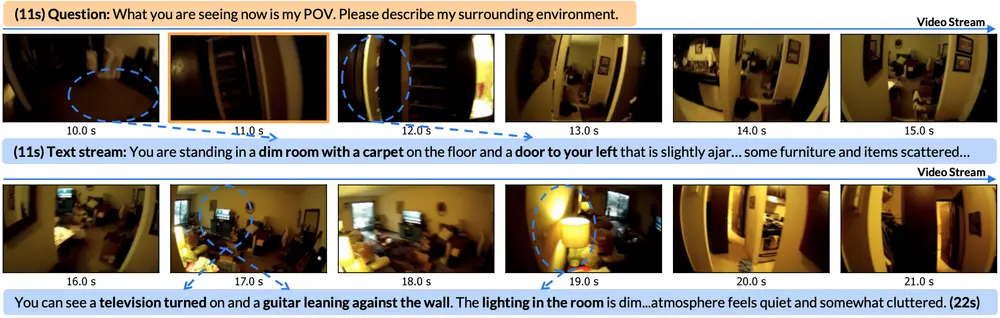

例如,用户在观看一个直播视频,视频中的场景从昏暗的房间逐渐过渡到明亮的户外场景。用户在视频的第11秒提问:“你现在看到的是我的视角,请描述我周围的环境。”StreamChat能够在解码回答时动态更新视觉上下文,捕捉视频内容的动态变化,并根据最新的视频流内容回答用户的问题。

主要功能和特点

- 动态视觉上下文更新:StreamChat在每个解码步骤更新视觉上下文,确保模型使用最新的视频流内容。

- 灵活高效的架构:通过基于交叉注意力(cross-attention)的架构,StreamChat能够有效处理动态视频输入,同时保持流媒体交互的推理效率。

- 并行3D-RoPE机制:StreamChat引入了并行的3D相对位置编码(RoPE)机制,以更好地编码流媒体交互场景中的视觉和文本令牌的相对时间信息。

- 新的密集指令数据集:为了训练流媒体交互模型,StreamChat构建了一个新的密集指令数据集,该数据集基于现有的密集描述数据集,并为指令-回答对中的每个单词标注时间戳。

工作原理

StreamChat的工作原理包括以下几个关键步骤:

- 视觉令牌提取:使用预训练的视觉模型从输入的流媒体视频中提取视觉令牌。

- 交叉注意力机制:将文本令牌作为查询,视觉令牌作为键和值,通过交叉注意力块将视觉令牌与大型语言模型(LLM)集成。

- 视觉前馈网络(V-FFN)专家:在每个交叉注意力块之后,使用V-FFN专家更新视觉令牌,并将更新后的令牌输入到后续的交叉注意力块中。

- 并行3D-RoPE:为视觉和文本令牌分配相同的时间索引,确保在流媒体设置中,特定时间戳的文本和视觉令牌共享相同的时间位置。

- 流媒体评估:构建流媒体评估基准,评估LMMs在流媒体交互场景中的表现。

具体应用场景

- 实时视频问答:在直播或实时视频流中,用户可以提问,StreamChat能够根据视频内容的实时变化提供准确的答案。

- 视频内容分析:对于需要实时分析和响应的视频内容,如监控视频,StreamChat可以提供动态的视觉上下文更新,以支持更准确的分析。

- 交互式视频娱乐:在视频游戏或互动式视频应用中,StreamChat可以根据游戏进程中的视觉变化与玩家进行交互。

- 教育和培训:在需要根据视频内容实时提供反馈的教育或培训场景中,StreamChat可以作为一个强大的交互工具。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...