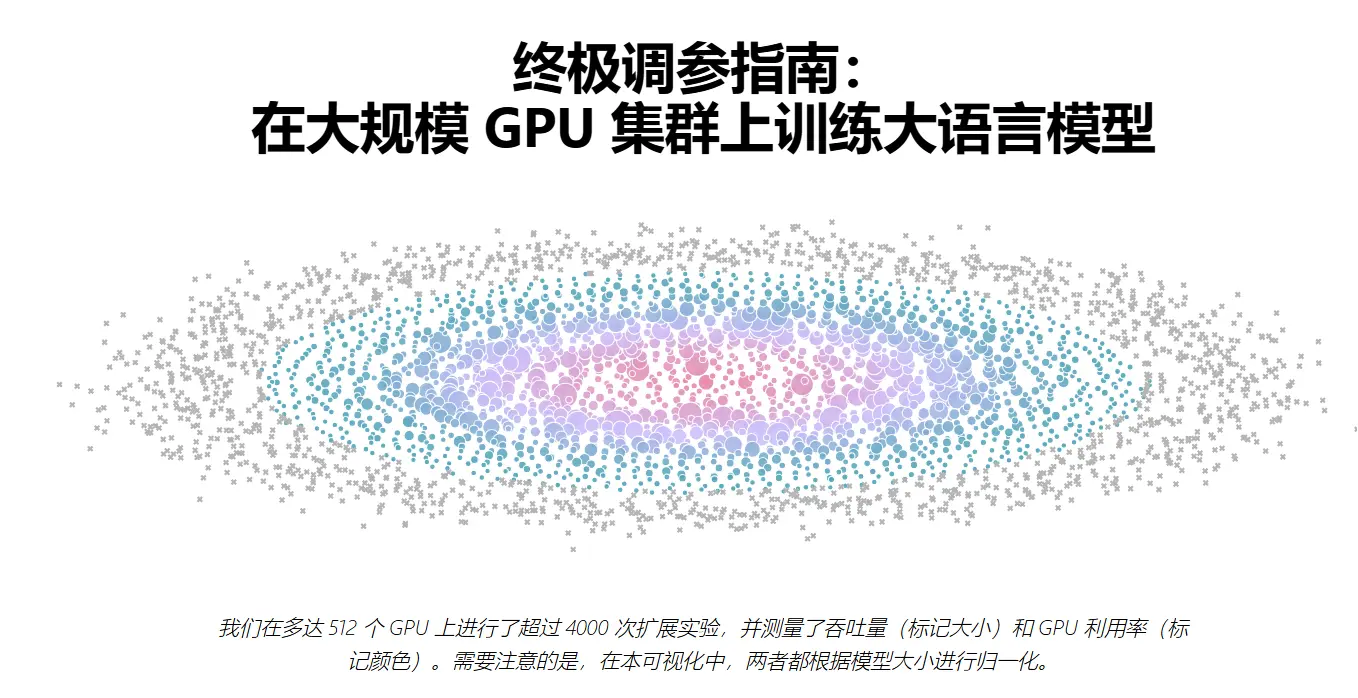

Hugging Face旗下的Nanotron团队发布了一本名为《Ultrascale-Playbook》的综合性书籍。这本书全面介绍了分布式/并行化和低级技术,旨在帮助读者高效地在大规模GPU集群上训练大语言模型。简单来说,这是一本关于训练工程的科普书,涵盖了从基础到高级的多种技术细节。此外,他们还推出了一个小工具来预测模型训练占用的显存。。

书籍亮点

免费开源

《Ultrascale-Playbook》是一本完全免费且开源的书籍。读者可以通过Hugging Face的官方网站或相关链接免费获取电子版。此外,团队还计划将这本书印刷成实体书,并向在线版的第一批读者免费赠送实体副本。

综合性强

这本书不仅涵盖了5D并行、ZeRO、快速CUDA内核等高级技术,还深入探讨了如何以及为什么重叠计算和通信。书中结合了动机、理论、以及来自4000多个扩展实验的交互式图表,甚至还有与NotebookLM podcasters共同学习的环节,帮助读者更好地理解和应用这些技术。

实用性强

书中不仅介绍了各种技术的原理和动机,还提供了实际应用中的案例分析。例如:

- DeepSeek是如何仅用500万美元完成训练的?

- Mistral为什么选择训练一个MoE(Mixture of Experts)模型?

- PyTorch原生数据并行实现的底层为何如此复杂?

- ZeRO-3和流水线并行的优缺点是什么?

- Meta用于训练Llama 3的上下文并行技术与序列并行有何不同?

- FP8和BF16的性能对比如何?

为什么这本书重要?

推动人工智能民主化的关键在于让更多人了解并掌握构建、训练和微调高性能模型的技术。《Ultrascale-Playbook》不仅是一本技术手册,更是一个知识库,它将驱动现代大语言模型高效训练的核心技术以连贯、易读且详细的方式呈现出来。

- 目标受众:这本书适合希望深入理解大规模模型训练的工程师、研究人员以及对AI扩展感兴趣的爱好者。

- 形式多样:除了文本内容,书中还包含交互式图表、Notebook示例以及LM podcasters的音频资源,为学习者提供了丰富的学习体验。

从博客到实体书

最初,《Ultrascale-Playbook》只是一个简单的博客帖子,但随着内容的不断扩展,最终演变成了一篇超过3万字的互动文章。为了更好地传播知识,Hugging Face决定将其印刷成一本真正的100页实体书——《超快速手册》,涵盖分布式训练和快速AI训练的所有科学知识。

数据统计

相关导航

Droidrun

GPT‑4o 图片精选

image2prompt

BabelDOC

HomeBox

DengeAI - Video Prompt Generator

llm.pdf