VideoGameBench

VideoGameBench是一个强大的工具,为评估视觉-语言模型在视频游戏中的多模态理解与推理能力提供了一个标准化的平台。通过支持多种游戏平台和类型,它为研究人员和开发者提供了一个灵活且多样化的测试环境。

LMArena(原Chatbot Arena)是一个开放平台,专注于通过人类偏好评估大语言模型(LLMs)和AI绘画模型的性能。该平台由加州大学伯克利分校的SkyLab和LMSYS研究团队开发,为LLMs提供一个公正、透明的评估环境。

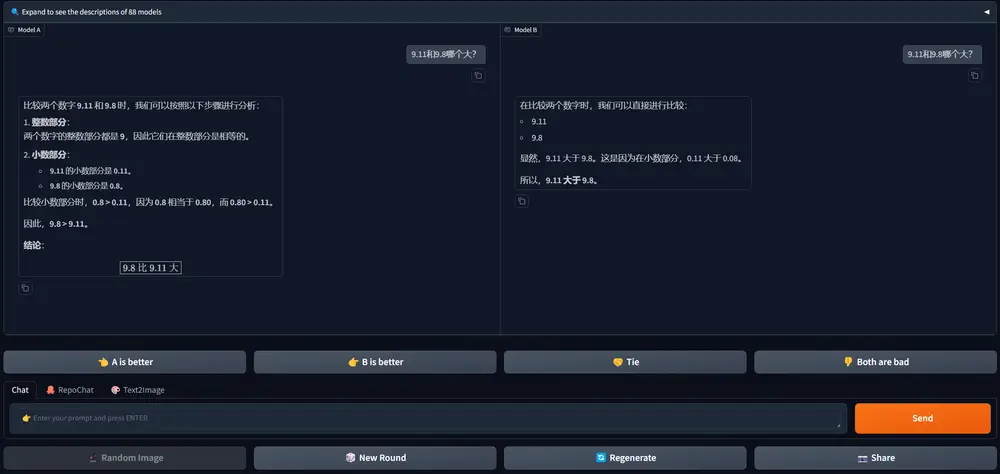

用户可以通过以下步骤使用LMArena:

Chatbot Arena表示热情邀请大家体验LMArena的全新Beta版。数月来,团队深入研究社区反馈,致力于改进网站——修复错误/漏洞、优化UI布局等。Beta版从头重建,具体改进包括: