大语言模型(LLM)正在从“会说话的系统”演变为能操作数字世界的“行动者”。它们不再只是回答问题,而是开始调用API、更新数据库、管理任务流程——这种能力的核心,是MCP(Model-Controller-Provider)架构。

但问题是:我们如何判断一个AI代理是否真的可靠?现有的评估方式大多停留在“读取数据”或“执行简单命令”的层面,难以反映复杂工作流中的实际表现。

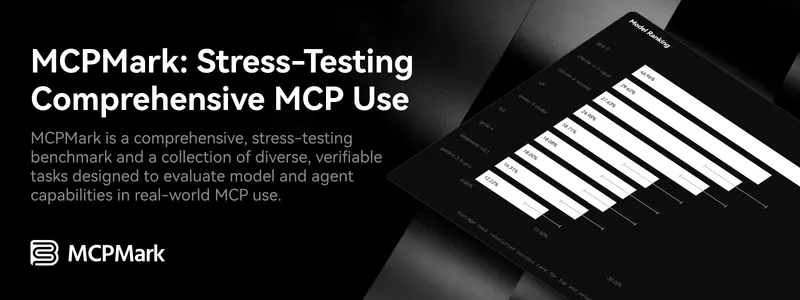

为此,研究团队推出了 MCPMark ——一个面向真实使用场景的全面压力测试基准。它不是理论推演,而是一次对当前顶尖AI系统的实战检验。

127个任务,模拟真实数字工作流

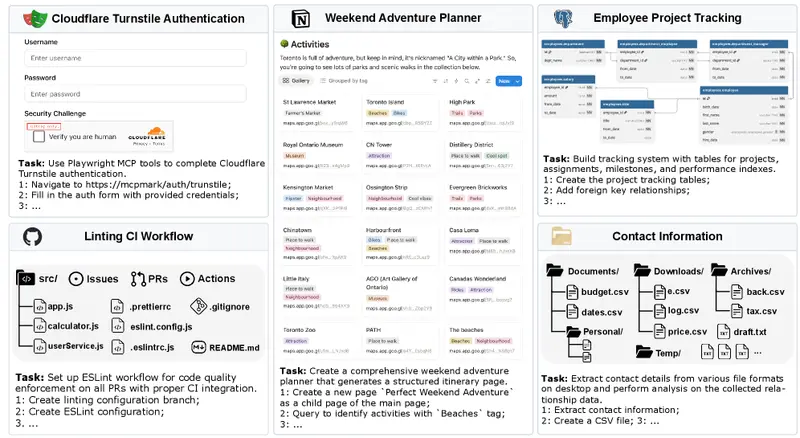

MCPMark包含127个精心设计的任务,覆盖多个行业场景,如项目管理、客户关系维护、自动化运维等。每个任务都具备以下特点:

- 多步骤交互:要求模型连续完成创建、读取、更新、删除(CRUD)操作;

- 依赖上下文决策:后续动作基于前序结果动态调整;

- 可验证性高:通过程序脚本自动验证输出状态是否符合预期;

- 起始状态明确:所有任务从预设环境出发,确保公平对比。

这些任务由领域专家与AI工程师协作构建,模拟的是真实职业环境中常见的复合型需求。例如:“根据销售线索创建客户档案 → 同步至CRM系统 → 安排跟进会议 → 更新进度并通知团队”。

这不是一次简单的问答挑战,而是一场完整的“数字生存测试”。

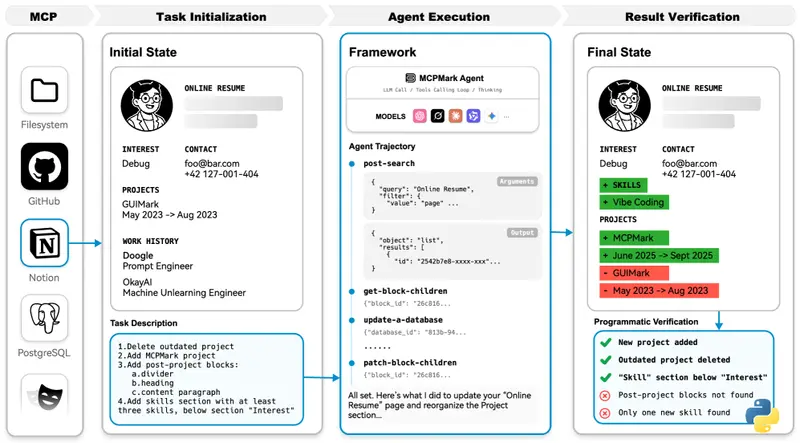

测试结果:顶级模型也仅勉强及格

研究人员在统一的轻量级代理框架下,测试了包括 gpt-5-medium、claude-sonnet-4 和 o3 在内的主流模型。评估指标包括:

- pass@1:首次尝试即成功;

- pass^4:四次尝试内至少一次成功;

- 平均执行轮次与工具调用次数。

结果令人警醒:

| 模型 | pass@1 | pass^4 |

|---|---|---|

| gpt-5-medium | 52.56% | 33.86% |

| claude-sonnet-4 | <30% | <15% |

| o3 | <30% | <15% |

平均来看,每个任务需要 16.2轮执行 和 17.4次工具调用 才可能达成目标。这意味着模型往往需要反复试错,而非一次性正确推理。

这组数据揭示了一个关键事实:当前AI代理的能力仍高度依赖“尝试-失败-修正”循环,缺乏稳定、高效的自主执行能力。

三大核心瓶颈浮现

从MCPMark的结果中,可以提炼出制约AI代理发展的三个关键瓶颈:

1. 推理能力不足:仍停留在“反应式操作”

多数模型表现出“看到什么就做什么”的行为模式,缺乏前瞻规划和抽象推理。它们无法像人类一样理解任务目标的本质,从而制定最优路径。

改进方向:

- 强化内部思维链(reasoning trace);

- 支持反事实推理与方案预演;

- 提升跨任务泛化能力。

2. 上下文管理低效:历史信息成为负担

随着任务步骤增加,模型接收到的工具返回值、对话记录、中间状态不断累积,导致注意力分散甚至崩溃。

典型现象:

- 忽略关键更新提示;

- 重复调用已执行的操作;

- 因响应过长被截断而丢失信息。

解决思路:

- 开发自动摘要机制,压缩历史轨迹;

- 设计更简洁的工具输出格式;

- 引入外部记忆存储与检索模块。

3. 执行稳定性差:表现波动大

同一模型在同一任务上多次运行,可能出现完全不同的结果。这种不一致性严重影响可信度。

根本原因:

- 工具调用顺序错误;

- 参数拼写失误;

- 缺乏自我纠错机制。

未来需构建具备“调试能力”的代理系统,能够在出错后自主识别问题、回滚状态并重新尝试。

MCPMark的意义:不只是测性能,更是指明方向

MCPMark的价值不仅在于暴露短板,更在于为技术演进提供了明确坐标:

- 对模型开发者:提示需加强长期推理与状态追踪能力;

- 对框架设计者:推动上下文压缩、错误恢复、执行监控等功能集成;

- 对工具提供方:呼吁标准化API响应格式,提升可解释性与容错性。

更重要的是,它确立了一个原则:评估AI代理,必须回归真实场景的复杂性。

下一步:让基准本身也能进化

尽管MCPMark已是目前最贴近现实的MCP评测体系,但它仍有局限:

- 任务生成成本高:依赖人工设计,扩展困难;

- 难度梯度陡峭:不利于中小模型参与对比;

- 用户意图过于明确:缺少模糊指令下的适应性测试。

未来的迭代方向包括:

- 引入半自动任务生成机制,结合模板+语义变异扩大规模;

- 增加细粒度难度分级,支持边缘设备模型评估;

- 加入模糊需求场景,例如“帮我处理最近那个项目的事”,考验澄清与推断能力;

- 接入更多类型MCP服务器,涵盖云平台、企业ERP、IoT接口等多元生态。

数据统计

相关导航

Next AI Draw.io

awesome-LLM-resources

UQLM

WorldVQA

MCPMark

SciArena

Firecrawl