On-Device AI

On-Device AI 为苹果用户提供了一种全新的 AI 使用方式,无需网络连接,即可随时随地享受 AI 的强大功能。它不仅保护了您的隐私,还通过本地运行提升了性能和效率。

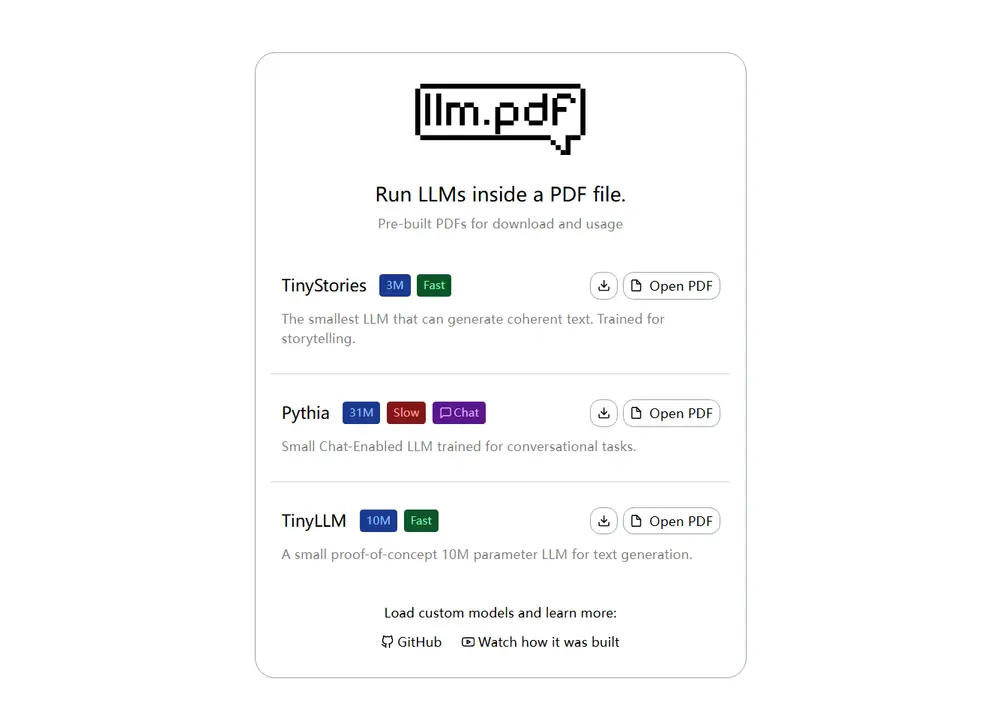

llm.pdf 并不是一个实用工具,而是一个技术探索项目——它试图回答一个问题:

我们能否仅用一个 PDF 文件,完成大语言模型(LLM)的推理?

答案是:可以。尽管效率有限,但这个项目成功实现了在标准 PDF 阅读器中运行完整的 LLM 推理流程。

llm.pdf 的核心技术基于以下几个关键步骤:

llama.cpp 编译为 asm.js(一种可在浏览器中运行的低级 JavaScript 表示),使其能在支持 JavaScript 的环境中执行。当用户用支持 JavaScript 的 PDF 阅读器打开该文件时,模型会在本地解码、加载并执行推理,整个过程发生在用户的设备上。

📽️ 想看完整实现过程?作者在 YouTube 上发布了详细讲解视频(文末附链接)。

项目提供了一个脚本,用于将任意兼容的 LLM 模型打包为可运行的 PDF 文件。

进入 scripts 目录,运行以下命令:

cd scripts

python3 generatePDF.py --model "path/for/model.gguf" --output "path/to/output.pdf"

该脚本会自动完成以下操作:

你生成的 PDF 将具备与原始项目相同的功能:在支持 JS 的 PDF 阅读器中启动本地推理。

由于运行环境受限(JavaScript + 单线程 + 解码开销),模型性能受显著影响。选择模型时请注意以下几点: