企业正在被视频淹没。

从数十年的电视广播档案,到成千上万家门店的监控摄像头,再到影视制作中堆积如山的原始素材——这些内容大多静静躺在服务器里,从未被真正“理解”或利用。它们被称为 “暗数据”:自动产生、却长期闲置的数字资产。

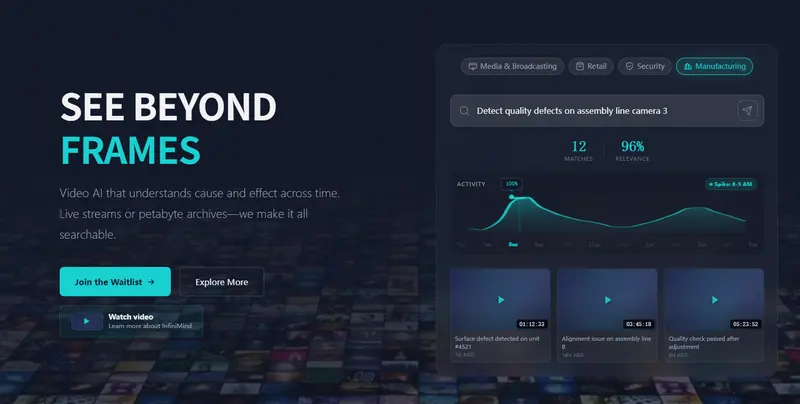

为唤醒这些沉睡的视频,两位前谷歌日本员工——Aza Kai(CEO)和 Hiraku Yanagita(COO)——共同创立了东京初创公司 InfiniMind,目标是构建一套基础设施,将海量视频与音频转化为结构化、可查询、可行动的业务洞察。

为什么现在才可能?

Kai 曾在谷歌负责云平台、机器学习、广告系统及视频推荐模型,后领导数据科学团队。他指出,过去十年虽然 GPU 性能每年提升 15–20%、成本持续下降,但真正的瓶颈在于 AI 的能力。

早期的视频分析工具只能识别单帧中的物体,无法追踪叙事逻辑、理解因果关系,更无法回答“谁在什么时候说了什么?”“产品是否出现在黄金时段?”这类复杂问题。对于拥有 PB 级素材的媒体或零售企业来说,连最基本的内容检索都困难重重。

转折点出现在 2021 至 2023 年:视觉-语言模型(VLM)取得突破,AI 开始真正“理解”视频内容,而不仅是“看到”画面。

“我们早在谷歌时就预见到这个拐点,”Kai 表示,“到 2024 年,技术成熟了,市场需求也清晰了——我们必须自己来建这家公司。”

产品落地:从日本试点走向全球

InfiniMind 首款产品 TV Pulse 已于 2025 年 4 月在日本正式推出。该平台可实时分析电视节目内容,帮助媒体和零售客户:

- 追踪产品曝光与品牌露出

- 监测观众情绪与公关影响

- 量化广告投放效果

在与多家主流电视台和广告代理商完成试点后,TV Pulse 已获得首批付费客户,包括大型批发商和媒体集团。

如今,公司正将重心转向其旗舰产品 DeepFrame——一个面向长视频的智能分析平台。它能处理长达 200 小时的连续视频,精准定位特定场景、发言人、事件或对话片段。

- Beta 版计划于 2026 年 3 月发布

- 正式版将于 2026 年 4 月上线

与市面上通用视频 API(如 TwelveLabs)不同,InfiniMind 专注企业级深度用例:安防监控、合规审查、内容归档、商业情报等。

技术差异化:不止于“看得见”,更要“看得懂”

Kai 强调,InfiniMind 的核心优势在于三点:

- 多模态融合:同时分析视觉、语音、音频和文本,构建完整语义理解;

- 无限长度支持:无需分段,直接处理整部纪录片或全天监控录像;

- 成本效率:在保证可用精度的前提下,大幅降低 PB 级视频分析的单位成本。

“我们的解决方案无需写代码,”他说,“客户只需上传视频,系统自动生成可操作的洞察。”

这解决了当前市场的两难:要么追求实验室级精度但成本高昂,要么仅支持短视频片段。InfiniMind 选择了一条中间路径——实用、可扩展、企业友好。

融资与扩张

InfiniMind 近期完成 580 万美元种子轮融资,由 UTEC 领投,CX2、Headline Asia、Chiba Dojo 及 a16z Scout 的一位 AI 研究员参投。

资金将用于:

- 持续优化 DeepFrame 模型

- 扩展分布式工程基础设施

- 招聘更多 AI 与系统工程师

- 拓展日本与美国市场

公司总部将迁至美国,同时保留东京办公室。Kai 认为,日本是理想的试验场:“这里有顶尖的硬件生态、高素质工程师,以及对技术要求严苛的早期客户,让我们能在真实场景中打磨产品。”

终极愿景:通过视频理解现实

在 Kai 看来,视频智能不仅是商业工具,更是通向通用人工智能(AGI)的关键路径。

“理解通用视频,本质上就是理解现实。工业应用很重要,但我们的终极目标是推动技术边界,帮助人类基于更完整的现实认知,做出更优决策。”

当 PB 级的“暗视频”被点亮,企业将不再只是存储数据,而是真正从时间中提取价值。

数据统计

相关导航

Zendesk

SlideBot AI

AIMedia

AstrBot

NEXA AI

GLM-PC

Demo2APK