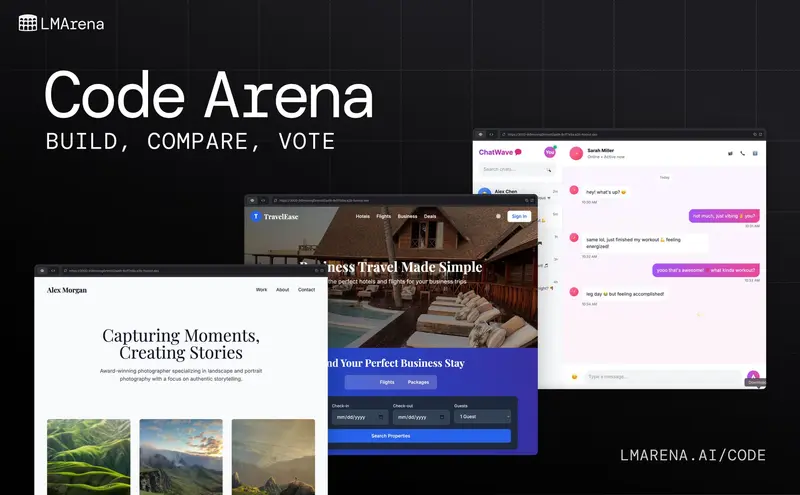

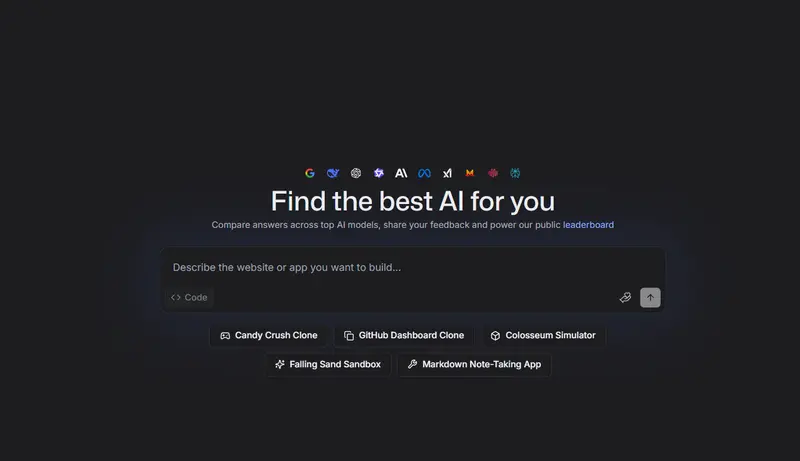

LMArena 宣布推出全新评估平台 Code Arena,专为真实世界场景设计,聚焦 AI 编程模型的全开发周期评估。不同于传统仅关注代码正确性的基准工具,Code Arena 以“代理式编程”为核心,完整记录从需求规划、迭代构建到调试优化的全流程,为开发者、研究人员及模型构建者提供透明、可复现的评估方案,目前已公开面向所有关注 AI 辅助开发的用户上线。

核心痛点:传统评估无法匹配 AI 编程模型的进化

如今的 AI 编程模型早已超越“一键生成代码”的初级阶段,成为能自主规划、搭建完整应用(如网页、系统重构)、实时调试的“编程代理”。但传统评估基准存在明显局限:仅聚焦代码是否可编译、能否通过静态测试用例,却忽略了软件开发本质是迭代创造的过程——规划、测试、优化的闭环才是真实开发的核心。

“问题早已不是‘模型会不会写代码’,而是‘它能把真实应用从头到尾做到多好’”,Code Arena 正是为解决这一痛点而生,将评估维度从“代码正确性”扩展到“全流程实战能力”。

核心特性:真实开发场景+全链路透明可追溯

Code Arena 以“贴近真实开发”为设计核心,打造了交互式、可追溯的评估环境,核心特性包括:

- 代理式行为模拟:模型以编程代理身份运行,可自主调用结构化工具(创建文件、编辑文件、读取文件),完整展示推理与执行过程,如同真实开发者思考与操作;

- 全周期流程记录:从需求接收、规划、生成到优化,每一步操作都被版本化记录,支持会话暂停、恢复、跨时间继续,状态永不丢失;

- 实时生成与预览:代码边生成边通过安全前端(CodeMirror 6)渲染,评估者可实时查看源码并交互预览应用效果,直观感受开发过程;

- 完整项目结构支持:生成结果包含 HTML/CSS/JS 等完整项目树,可检查模型对文件依赖管理、递归编辑的处理能力;

- 唯一可追溯 ID:每一次评估都绑定专属 ID,关联提示词、模型版本、操作记录、人工投票等全链路信息,确保结果可复现、可审计;

- 可分享协作:单次构建生成唯一链接,支持分享给同行测试、评审或对比,让评估成为参与式过程。

评估流程:从需求到结果的科学闭环

Code Arena 的每一次评估都是可完整复现的科学实验,流程清晰且严谨:

- 提交任务:评估者或开发者提交具体需求(如“开发支持暗黑模式的 Markdown 编辑器”);

- 模型规划:模型理解需求后,通过结构化工具调用规划执行步骤,模拟真实开发的思考过程;

- 实时生成:模型迭代生成可部署的完整应用,过程实时流式传输;

- 全量记录:所有操作(创建、编辑、执行)快照存储于 Cloudflare R2,数据库留存永久追溯链路;

- 人工盲比投票:人类评估者对模型输出进行两两盲评,从功能完整性、易用性、需求还原度,到设计品味等多维度打分,投票结果包含完整上下文(模型版本、延迟、环境);

- 科学汇总:结构化人工判断实时同步至排行榜,展示置信区间与方差,避免单一平均分的片面性。

从 WebDev Arena 到 Code Arena:重构评估体系

Code Arena 并非从零起步,而是取代了 Arena 此前运营的 WebDev Arena——后者作为早期大规模“人在回路”编程基准,首次实现了评估的参与式与透明化。但随着用户量增长和对精度、可复现性的要求提升,旧系统已难以满足真实世界的高标准。

Code Arena 进行了全栈重构,核心升级点包括:

- 强化方法论严谨性:聚焦代理式工具使用,支持递归编辑与依赖管理,更贴近真实开发;

- 数据处理透明化:全链路可追溯 ID 确保每一个结果都可验证,避免数据污染;

- 科学测量标准:结构化人工评估+统计聚合,引入评委一致性、置信区间等维度,让评估更可信;

- 全新干净排行榜:摒弃旧数据干扰,从零开始构建排行榜,确保模型对比的公平性。

旧版 WebDev Arena(WebDev Legacy)将作为历史档案退役,WebDev V2 排行榜成为面向未来的性能标准。同时,平台会对 UI 或流程改动进行偏见审计,量化对投票行为的影响并进行补偿,确保评估的一致性与公平性。

社区驱动+未来规划:打造“活的评估系统”

Code Arena 以社区为核心,开发者可通过平台提交挑战、参与实时测试、分享生成结果,集体反馈直接构成排行榜数据;Discord 社区与 Creator Community 则为用户提供交流、创意实践的空间,让评估不仅是“跑分”,更变得有趣、有创造力。

未来,Code Arena 还将持续迭代:

- 短期:优化数据质量、降低延迟、提升评估速度,支持多文件 React 应用生成,让模型能构建结构化代码仓库;

- 长期:上线代理支持、多模态输入、多文件项目隔离沙箱,贴近现代编程代理跨系统、跨界面的工作方式。

数据统计

相关导航

BrowseComp-Plus

ARC Prize

MCPMark

Yupp

忘忧棋牌室

WebDev Arena

MCPMark