尽管线性层的量化技术已经广泛应用于深度学习模型中,但在加速注意力机制方面的应用仍然有限。为了提高注意力计算的效率并保持高精度,清华大学的研究团队提出了 SageAttention2,这是一个基于低精度矩阵乘法的高效注意力计算方法。

例如,在自然语言处理中,一个模型可能需要处理长达数万甚至数十万的序列长度,这使得传统的注意力机制计算变得非常耗时和资源密集。SageAttention2通过量化技术,使得在硬件上执行的矩阵乘法操作更快,从而加速整个注意力计算过程。

SageAttention2 的关键技术

低精度矩阵乘法

SageAttention2 利用了显著更快的 4 位矩阵乘法(Matmul),并通过以下方法实现了高效的注意力计算:

矩阵量化:将查询矩阵 ( Q ) 和键矩阵 ( K ) 量化为 INT4 格式,将值矩阵 ( V ) 和中间矩阵 ( widetilde{P} ) 量化为 FP8 格式。这种量化方法在保持计算精度的同时,大幅减少了内存带宽和计算开销。

精度增强技术

为了进一步提高注意力计算的精度,SageAttention2 引入了以下技术:

平滑 Q 和 V:通过特定的方法平滑量化后的 ( Q ) 和 ( V ) 矩阵,增强 ( QK ) 和 ( PV ) 计算的准确性。这种方法确保了低精度计算结果的可靠性。

自适应量化方法

为了确保在不同模型和任务中的一致性能,SageAttention2 进行了以下优化:

量化精度分析:分析了量化精度随时间步和层的变化情况,提出了一种自适应量化方法。该方法根据具体的模型和任务需求,动态调整量化参数,确保端到端指标的稳定性。

工作原理

SageAttention2的工作原理包括以下几个步骤:

量化:将Q、K矩阵量化为4-bit整数(INT4),将P、V矩阵量化为8-bit浮点数(FP8)。 平滑处理:对Q和V矩阵进行平滑处理,以减少量化误差。 自适应量化:根据模型的不同层和时间步的量化准确性,动态选择使用4-bit或8-bit量化。 矩阵乘法:在量化后的矩阵上执行矩阵乘法操作,利用现代GPU的低精度计算能力,提高计算速度。 去量化:将量化后的计算结果转换回高精度格式,以进行后续的计算或输出。

性能表现

操作数性能

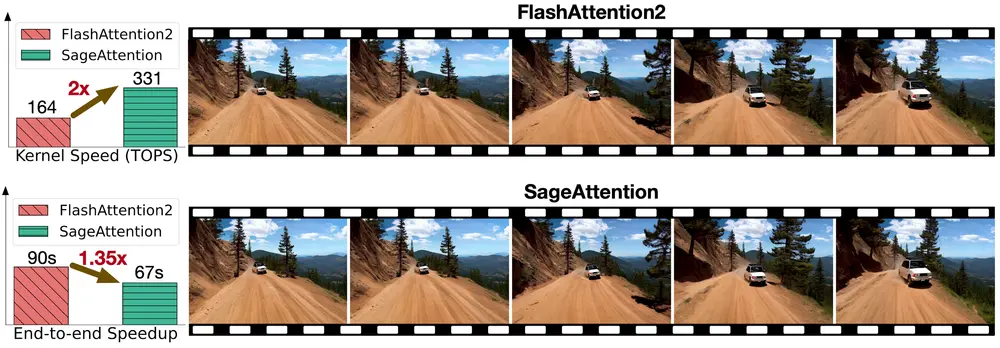

实验结果显示,SageAttention2 在 NVIDIA RTX 4090 GPU 上的每秒操作数(OPS)显著优于现有方法:

与 FlashAttention2 相比:SageAttention2 的 OPS 高出约 3 倍。 与 xformers 相比:SageAttention2 的 OPS 高出约 5 倍。

端到端指标

综合实验表明,SageAttention2 在多种任务中表现出色,包括大语言模型处理、图像生成和视频生成。这些任务中的端到端指标损失可以忽略不计,证明了方法的高效性和鲁棒性。

具体应用场景

SageAttention2可以应用于多种场景,包括但不限于:

大语言模型(LLM):在处理长文本和复杂语言任务时,SageAttention2可以加速模型的推理过程。 图像生成:在图像生成任务中,SageAttention2可以加速生成过程,同时保持生成图像的质量。 视频生成:对于需要实时或近实时视频生成的应用,SageAttention2可以提供更快的处理速度。 多模态学习:在需要同时处理文本、图像和视频数据的应用中,SageAttention2可以提高模型的计算效率。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...