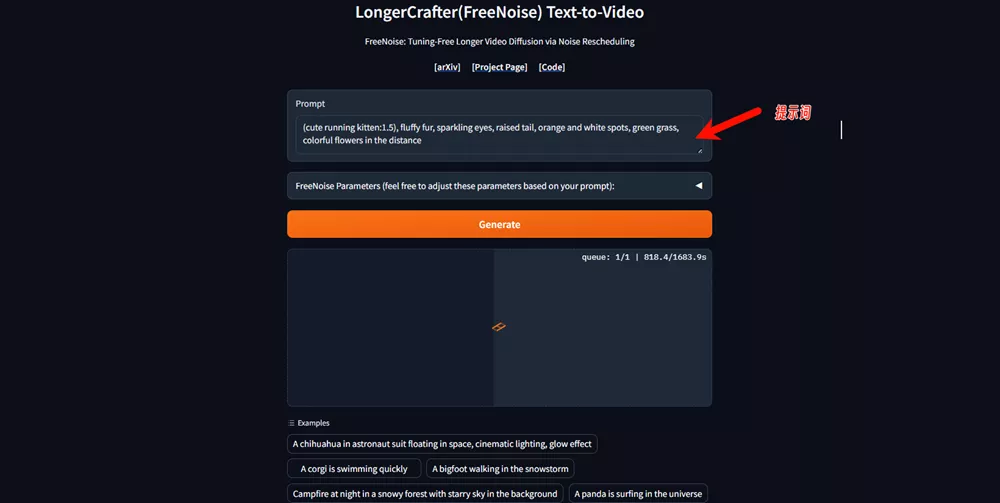

来自腾讯人工智能实验室、南洋理工大学、香港科技大学的研究人员提出了一种利用预训练的视频扩散模型生成高质量长视频的方法FreeNoise,它能够使模型在生成更长时间视频时保持内容的一致性,无需对模型进行调优,并且具有高效的推理速度。

FreeNoise的核心设计:

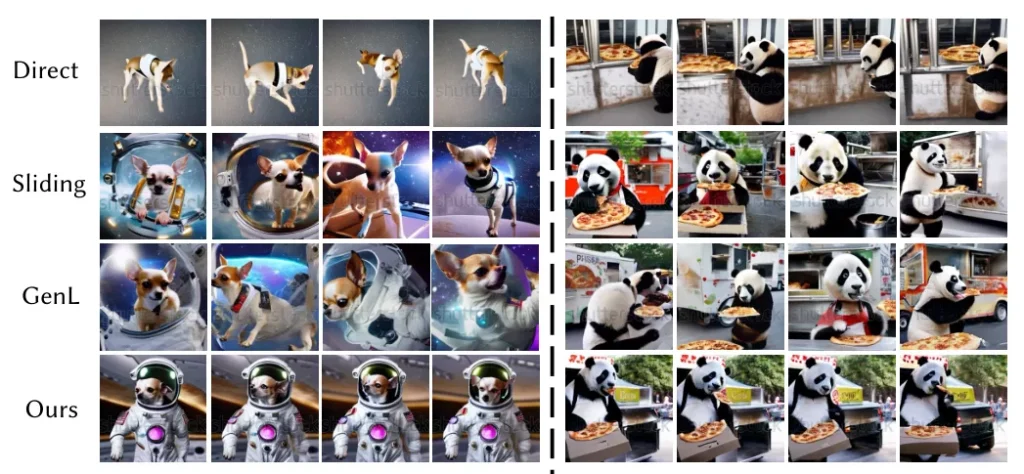

- 噪声重新调度(Noise Rescheduling): 通过打乱固定数量的噪声帧的顺序,生成具有内部随机性和长程相关性的噪声序列。然后采用基于窗口的注意力融合,在保持内容一致性的同时生成任意长度的视频。

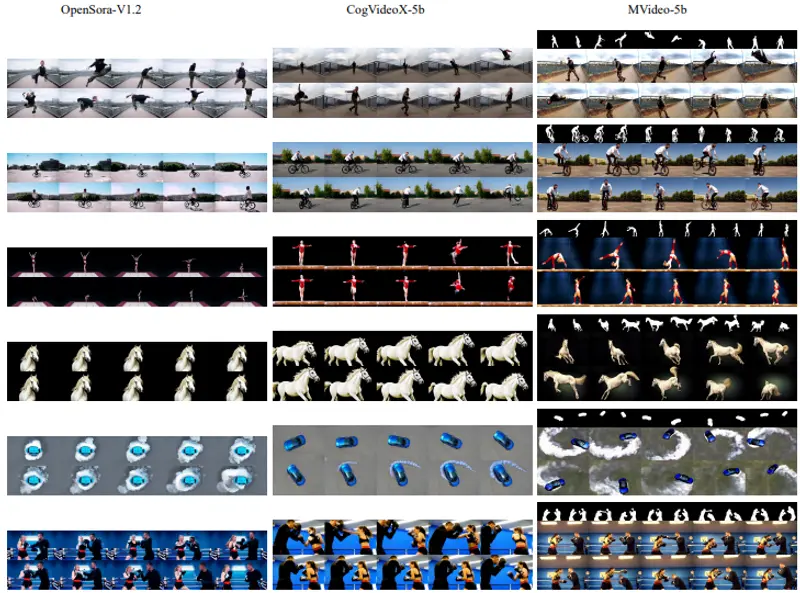

- 运动注入(Motion Injection): 逐步注入新的运动,首先用第一个提示控制大部分去噪步骤以保持整体布局和外观,然后只在特定步骤使用目标提示以控制对象形状和姿态,从而生成多提示的长视频。 这两种方法相结合,可以生成高质量、连贯的长视频,而无需对预训练模型进行调优。实验结果表明,这种方法明显优于直接采样和基于滑窗的方法,生成的视频质量更高且内容更一致。

这两种方法相结合,可以生成高质量、连贯的长视频,而无需对预训练模型进行调优。实验结果表明,这种方法明显优于直接采样和基于滑窗的方法,生成的视频质量更高且内容更一致。

FreeNoise的主要优势:

- 训练-推理一致性:利用噪声重新调度,实现了视频扩散模型在生成长视频时的训练-推理一致性,从而避免了训练-推理之间的偏差,提高了视频质量。

- 内容一致性:通过窗口融合注意力,保持了长视频内容的一致性,克服了滑窗法无法保持长期一致性的问题。

- 高效性:相比之前的最佳方法,该方法只需要额外不到20%的推理时间,而不会像Gen-L-Video那样需要额外的255%推理时间。

- 多提示生成:通过运动注入,实现了多提示条件下的长视频生成,从而支持不同动作连续切换。

- 无需调优:采用基于预训练模型的调优方法,避免了模型调优的过程。

FreeNoise的应用场景:

FreeNoise的应用场景广泛,特别是在需要生成具有连贯故事线和动态变化内容的视频领域。

在电影制作中,FreeNoise可以用来生成具有复杂情节和角色动作的长视频片段,而无需手动调整模型参数。在虚拟现实(VR)和增强现实(AR)应用中,FreeNoise可以用于创建动态环境和角色互动,提供更加丰富和真实的用户体验。

此外,FreeNoise还可以应用于教育、广告和娱乐行业,用于生成定制化的视频内容,满足用户对个性化和动态视频的需求。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...