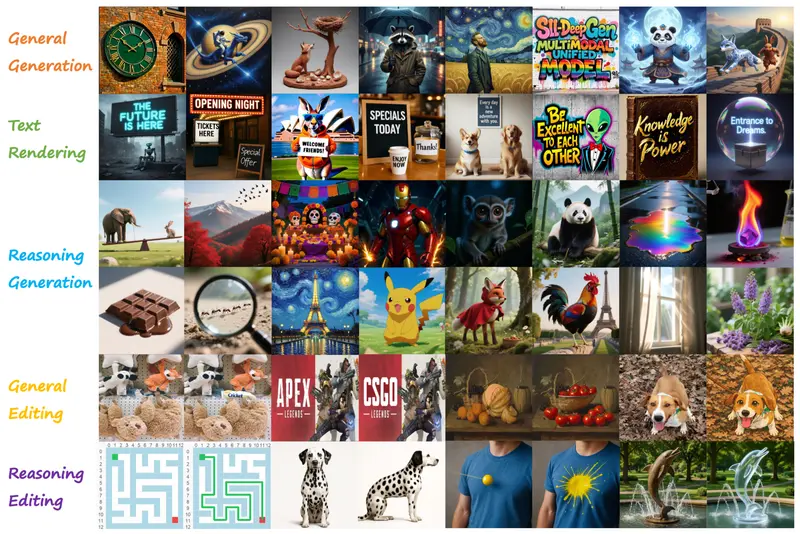

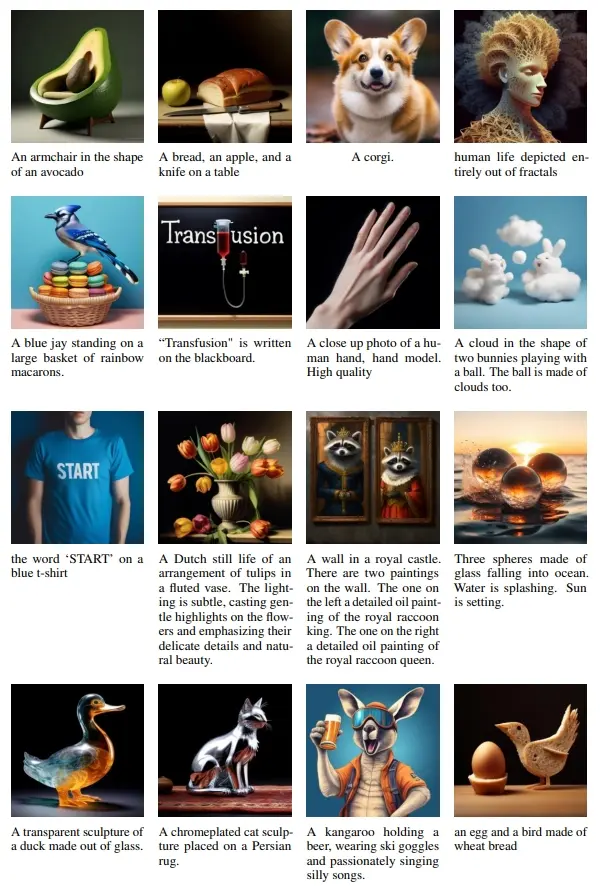

Meta、Waymo和南加州大学的研究人员推出多模态模型Transfusion,它能够同时处理离散数据(如文本)和连续数据(如图像)。Transfusion的核心思想是将语言模型的下一个词预测(next token prediction)和图像扩散模型结合起来,通过单一的变换器(transformer)模型来处理混合模态的序列数据。Transfusion在不同规模的实验中都显示出比现有方法更好的性能,无论是在图像生成的质量上,还是在文本生成的准确性上。此外,Transfusion模型还可以进行图像编辑,比如根据用户的指令改变图片中的某些元素。

例如,你想生成一张图片并描述它,你可以给Transfusion模型一个文本提示,比如“一个穿着西装的兔子站在未来城市的高楼大厦前”,模型就会生成一张图片,并可能生成描述,如“这只兔子看起来很专业,背景是充满科技感的城市景观”。

主要功能:

- 预训练多个参数量高达70亿的Transfusion模型,这些模型能够处理文本和图像数据。

- 通过模态特定的编码和解码层,提高模型性能,甚至可以将每张图像压缩到仅16个补丁。

主要特点:

- 多模态能力:Transfusion能够生成文本和图像,结合了两种模态的优势。

- 无需量化:与将图像量化为离散标记的方法相比,Transfusion直接在连续空间中处理图像,避免了信息损失。

- 扩展性:Transfusion模型在规模上具有很好的扩展性,随着模型大小的增加,性能显著提升。

工作原理:

- 数据表示:文本被标记化,图像被编码为潜在的补丁序列。

- 模型架构:Transfusion使用单一的变换器处理所有序列,无论模态如何。文本使用标准嵌入层转换,而图像则通过补丁化层表示。

- 注意力机制:文本使用因果注意力,图像补丁使用双向注意力。

- 训练目标:结合了语言模型的损失函数和图像扩散的损失函数,通过平衡系数结合两种损失。

具体应用场景:

- 文本到图像生成:根据文本描述生成图像,例如,根据“一只坐在草地上的可爱小猫”生成相应的图片。

- 图像到文本生成:为图像生成描述性文本,例如,为一张风景照片生成“夕阳下的宁静湖泊”。

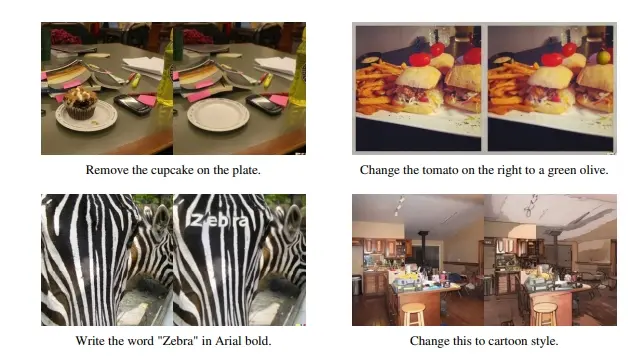

- 图像编辑:根据指令对图像进行编辑,如将图片中的某个物体替换或改变颜色。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...