新加坡国立大学的研究人员推出Video-Infinity系统,它是一个分布式的长视频生成框架。简单来说,Video-Infinity能够利用多个GPU(显卡)并行工作,快速生成长时间的视频内容。这对于传统的视频生成模型来说是一个挑战,因为它们通常只能生成很短的视频片段。这项技术的优势在于,它能够显著减少生成长视频所需的时间和资源,同时保持视频质量,为用户提供更加丰富和连续的视觉体验。

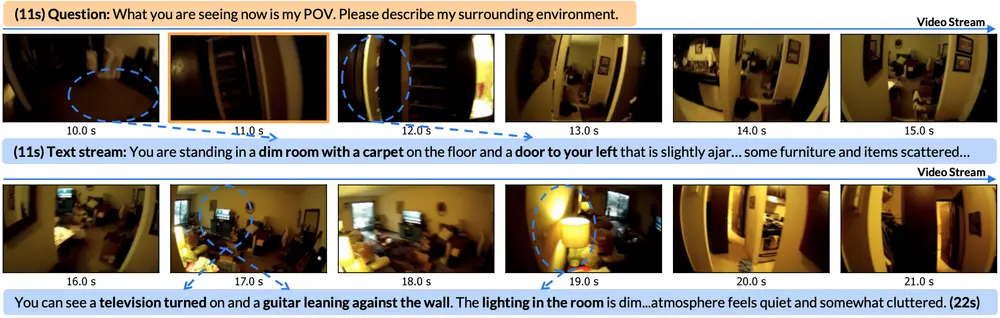

例如,你想要生成一段视频,内容是一只忠诚的金毛寻回犬在不同天气条件下等待主人回家。使用Video-Infinity,你可以在短时间内生成这样的视频,包括早晨、夜晚、雨中和雪中的场景。系统会将这个任务分割,让多个GPU同时工作,每个GPU负责生成视频的一部分,然后通过特定的机制确保这些部分在最终视频中连贯一致。

主要功能:

- 生成长视频:Video-Infinity能够生成长达2300帧的视频,相当于近100秒的内容。

- 分布式处理:通过在多个GPU上并行处理视频的不同部分,显著提高了视频生成的速度。

主要特点:

- 分布式生成:通过多个GPU并行工作,解决了单个GPU处理长视频时的内存和时间限制问题。

- Clip parallelism(片段并行化):一种机制,允许跨GPU高效地共享和同步上下文信息。

- Dual-scope attention(双范围注意力):调整时间自注意力机制,以在设备之间平衡局部和全局上下文。

工作原理:

- Video-Infinity将视频潜在表示(latent representation)分割成多个小块,每个小块由不同的GPU并行处理。

- 通过Clip parallelism,系统能够在GPU之间高效地交换时间信息,确保视频片段之间的连贯性。

- 利用Dual-scope attention,模型能够在保持局部连贯性的同时,引入全局上下文信息,从而生成具有整体一致性的长视频。

具体应用场景:

- 电影和视频制作:可以快速生成电影或视频中的长镜头,提高制作效率。

- 虚拟现实和游戏:为虚拟现实环境或视频游戏生成连续的动态背景。

- 动画制作:自动化长动画的生成过程,减少人工绘制的工作量。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...