新加坡国立大学推出通用且即插即用的加速方案AsyncDiff,它能够显著加速扩散模型(diffusion models)的运行速度。扩散模型是一种强大的生成模型,能够创造出各种数据,比如图片和视频,但在生成高质量内容时往往步骤多、速度慢。例如,你正在制作一部动画电影,需要生成大量的高质量画面。使用传统的扩散模型可能需要很长时间来生成每一帧图像。而AsyncDiff可以加速这一过程,通过并行处理来快速生成连贯且高质量的动画帧,从而节省制作时间和成本。

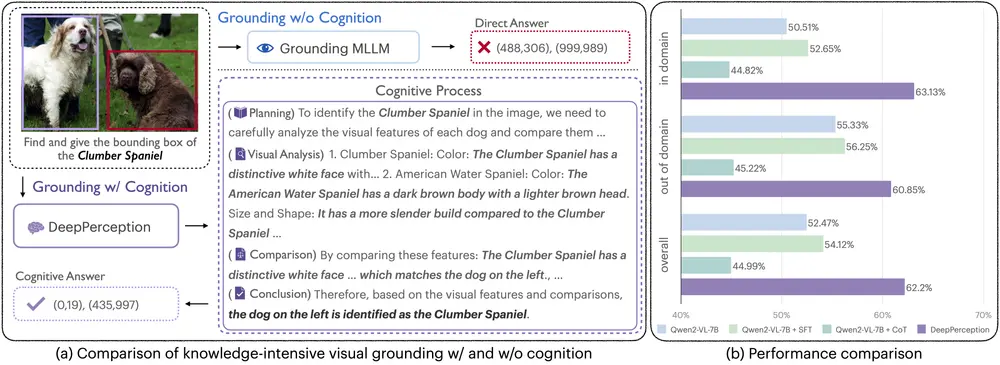

AsyncDiff能够在多台设备间实现模型并行,将笨重的噪声预测模型分割成多个组件,每个组件分配给不同的设备。AsyncDiff利用连续扩散步骤中隐藏状态之间的高度相似性,将传统的序贯去噪转变为异步过程。这样一来,每个组件都能够在其独立的设备上并行计算。所提出的策略显著减少了推理延迟,同时对生成质量的影响降到最低。具体而言,在使用四块英伟达 A5000 GPU的情况下,对于Stable Diffusion v2.1模型,AsyncDiff在几乎不影响生成质量的前提下实现了2.7倍的加速,并且在CLIP评分仅减少0.38的情况下达到了4.0倍的加速。实验还表明,AsyncDiff能够轻松应用于视频扩散模型,并展现出了令人鼓舞的性能表现。

主要功能:

- 加速生成过程:AsyncDiff通过并行计算来加快扩散模型的生成速度,减少等待时间。

主要特点:

- 并行化:AsyncDiff将传统的按顺序去噪过程转变为异步过程,允许多个计算步骤同时进行。

- 模型并行性:通过将大型的去噪模型分割成多个组件,并在不同的设备上并行处理。

- 高效率:实验结果显示,AsyncDiff在保持生成质量的同时,显著提高了处理速度。

工作原理:

- 模型分割:AsyncDiff将去噪模型分割成多个组件,每个组件分配给不同的计算设备。

- 异步去噪:利用连续扩散步骤中隐藏状态的高相似性,每个组件可以独立预测不同时间步的噪声。

- 跨设备通信:组件间的输出需要在设备间进行通信,以便并行处理。

- 步长去噪:通过一次性完成多个去噪步骤来减少并行计算的轮数和通信频率。

具体应用场景:

- 图像和视频生成:在需要快速生成大量图像或视频的场景下,比如电影制作、游戏开发或虚拟现实体验。

- 数据增强:在机器学习中,快速生成更多的训练样本。

- 实时交互应用:需要快速响应用户输入并生成结果的应用,如实时语音或视频生成。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...