香港大学及字节跳动的研究人员推出新型图像生成模型家族LlamaGen,将大语言模型(Llama)中原用于文本生成的“下一个令牌预测”范式应用到了视觉图像生成领域。LlamaGen是对传统自回归模型在图像生成任务上能否达到最先进性能的一次肯定回答,特别是当这些模型得到适当扩展时。

- 项目主页:https://peizesun.github.io/llamagen

- GitHub:https://github.com/FoundationVision/LlamaGen

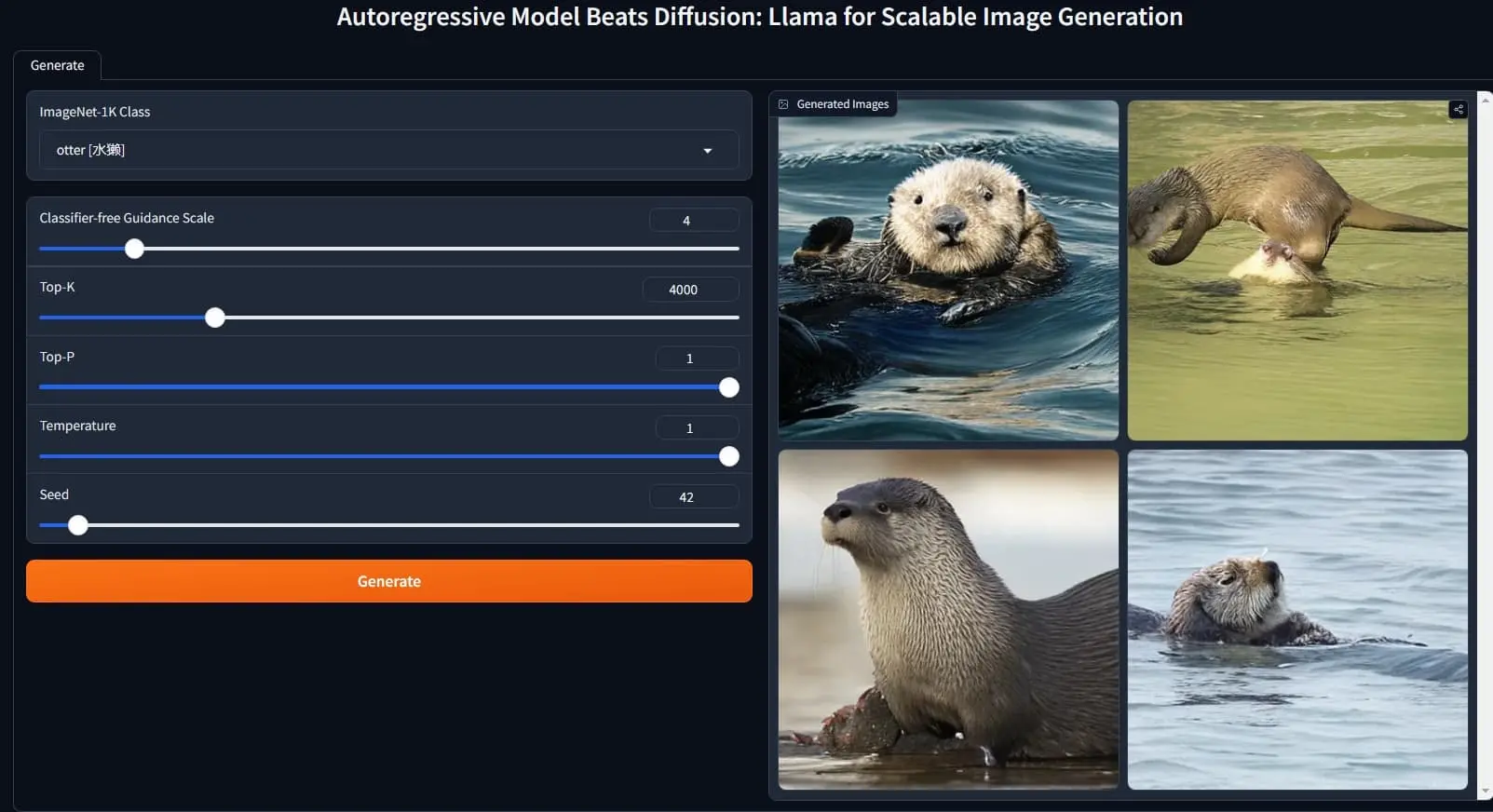

- Demo:https://huggingface.co/spaces/FoundationVision/LlamaGen

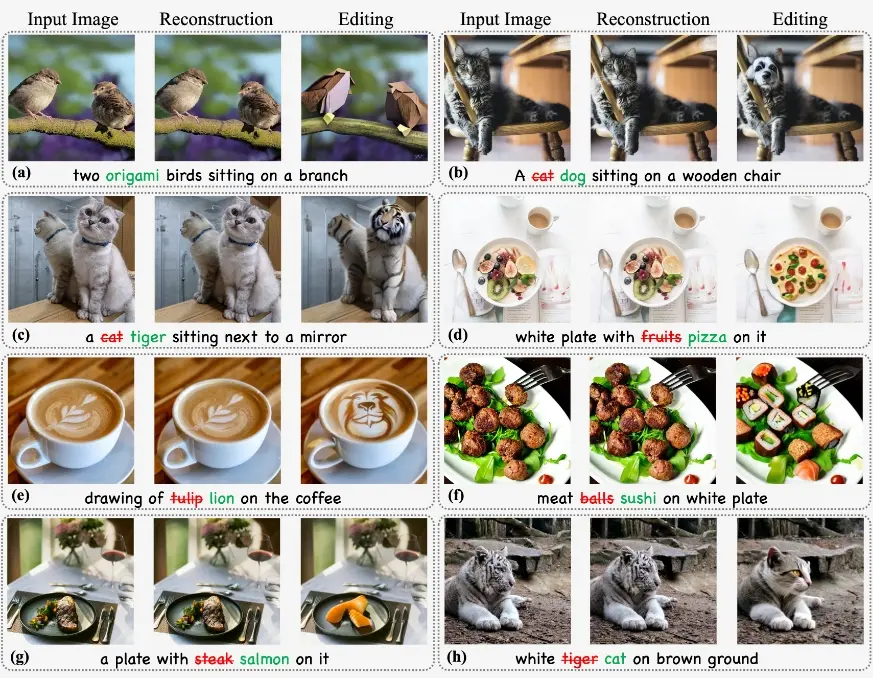

这一探索的结果包括: (1) 一款图像分词器,具有16倍的下采样率,在ImageNet基准上实现了0.94的rFID重建质量和97%的码本使用率。 (2) 一系列条件类别图像生成模型,参数量从1.11亿到31亿不等,在ImageNet 256×256基准测试中达到了2.18的FID分数,超越了诸如LDM、DiT等流行的扩散模型。 (3) 基于7.75亿参数的文本条件图像生成模型,经过LAION-COCO数据集及高审美质量图像的两阶段训练,展现了在视觉质量和文本对齐方面的竞争力。 (4) 开发人员验证了大语言模型服务框架在优化图像生成模型推理速度方面的有效性,实现了326%至414%的加速。

例如,你想要生成一幅画,描述为“一只站在岩石上的老虎”。使用LlamaGen,你只需将这个文本描述输入模型,它就能生成一幅图像,展示了这一场景。如果是一个更复杂的描述,比如“夕阳下的海滩”,LlamaGen同样可以根据这个描述生成一幅充满细节的海滩日落图像。这展示了LlamaGen在将文本转换为视觉图像方面的强大能力。

主要功能:

- 图像生成:LlamaGen能够根据类别条件或文本条件生成图像。

主要特点:

- 自回归模型:与传统的视觉模型不同,LlamaGen采用了自回归模型,这种模型在文本生成中表现出色。

- 扩展性:LlamaGen展示了自回归模型在图像生成任务上的可扩展性,通过增加模型大小,能够生成更高质量的图像。

- 开源:所有模型和代码都是开源的,有助于推动视觉生成和多模态基础模型的社区发展。

工作原理:

- 图像分词器:首先将图像像素量化为离散的标记,然后这些图像标记被重塑为序列,用于训练基于Transformer的自回归模型。

- 自回归模型:在图像生成过程中,模型通过预测下一个标记的方式生成图像标记序列。

- 两阶段训练:对于文本条件的图像生成模型,LlamaGen采用了两阶段训练策略,先在大规模数据集上训练,然后在高美学质量图像上进行微调。

具体应用场景:

- 艺术创作:艺术家和设计师可以使用LlamaGen根据文本描述生成图像,从而辅助创作过程。

- 游戏开发:在游戏设计中,LlamaGen可以用来快速生成游戏内的各种图像资源。

- 虚拟现实:在虚拟现实环境中,LlamaGen可以根据用户的想象或描述生成对应的视觉内容。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...