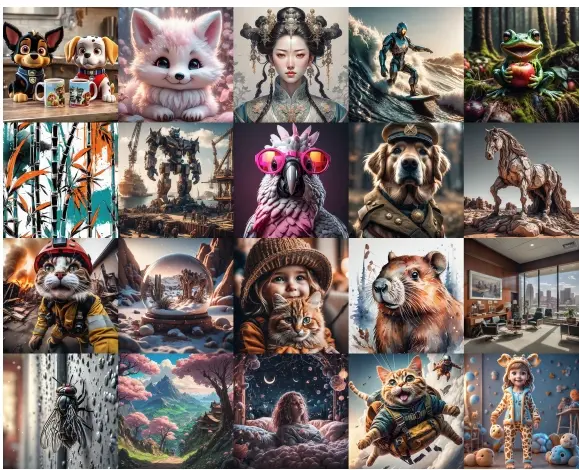

来自澳大利亚国立大学、利物浦大学、东南大学和微软亚洲研究院的研究人员推出新技术Step-aware Preference Optimization(SPO,步态感知偏好优化),用于改进文本到图像的扩散模型的训练过程,使其生成的图像更符合人类的审美偏好。例如,你想要一个AI根据你的描述生成一张图片。通常,AI生成的图片可能在布局和细节上有所欠缺,不够自然或不符合你的期望。SPO技术就是为了解决这个问题,它在AI生成图片的每一步中,都根据人类的评价来调整生成过程,确保最终结果更令人满意。

- 项目主页:https://rockeycoss.github.io/spo.github.io

- GitHub:https://github.com/RockeyCoss/SPO

- 模型地址:https://huggingface.co/SPO-Diffusion-Models/SPO-SDXL_4k-p_10ep

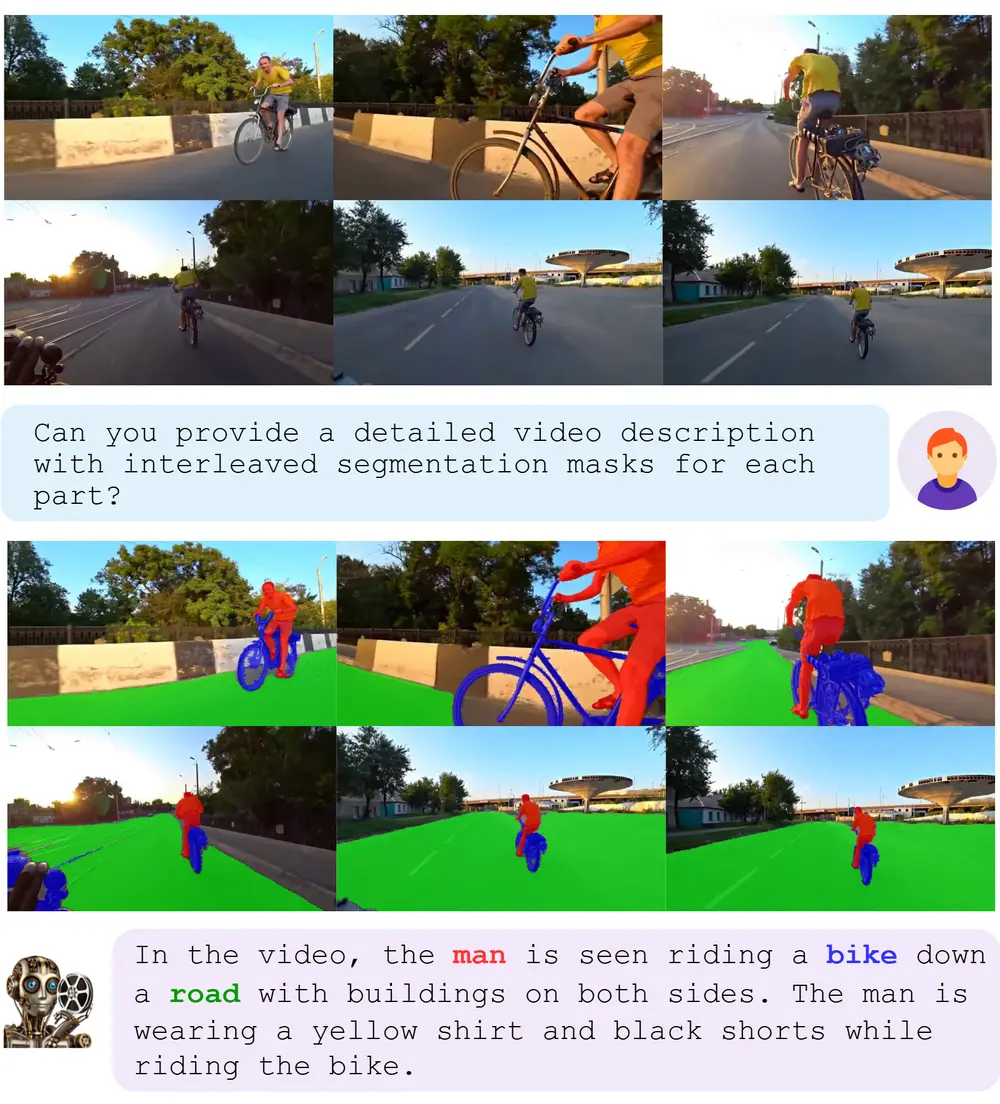

SPO是一种新颖的后训练方法,它独立地评估并调整每个步骤的去噪表现,利用步态感知偏好模型和步进式重采样器确保精确的步态感知监督。具体而言,在每一步去噪过程中,我们采样一个图像池,找出一个合适的胜负对,并且最重要的是,随机从该池中选择单个图像来初始化下一步的去噪。这一步进式重采样过程确保下一对胜负图像源自同一原始图像,使得胜负比较不依赖于前一步的结果。为了评估每一步的偏好,开发人员训练了一个独立的步态感知偏好模型,该模型可应用于含噪和清晰图像。

通过在SD1.5和SDXL上的实验,我们证明了SPO在根据复杂、详尽的提示调整生成图像以及提升美学效果方面,显著优于最新的Diffusion-DPO方法,同时在训练效率上也实现了超过20倍的提升。

主要功能和特点:

- 步态感知:SPO考虑了在图像生成过程中每一步的特定需求,比如早期步骤可能更关注布局,而后期步骤更关注细节纹理。

- 独立评估:SPO在每一步都独立评估图像的质量,而不是简单地将最终图像的偏好标签应用于所有步骤。

- 高效训练:与传统的偏好优化方法相比,SPO在训练效率上提高了20倍以上,因为它使用了更合理的偏好标签。

工作原理:

- SPO通过在每一步生成多个候选图像,并使用一个步态感知的偏好模型来评估这些图像的优劣。

- 该模型会从候选图像中选择最优质的图像和最不优质的图像,形成“胜者”和“败者”的对比。

- 然后,SPO使用一个随机采样器从候选图像中选择一个图像,作为下一步的起点,确保每一步的评估独立于前一步。

具体应用场景:

- 图像生成:用户可以提供文本描述,SPO能够生成更符合描述的高质量图像。

- 艺术创作:艺术家和设计师可以使用SPO来生成具有特定风格和细节的艺术作品。

- 游戏和动画制作:在游戏或动画中,SPO可以用于快速生成符合特定主题和风格的图像和角色。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...