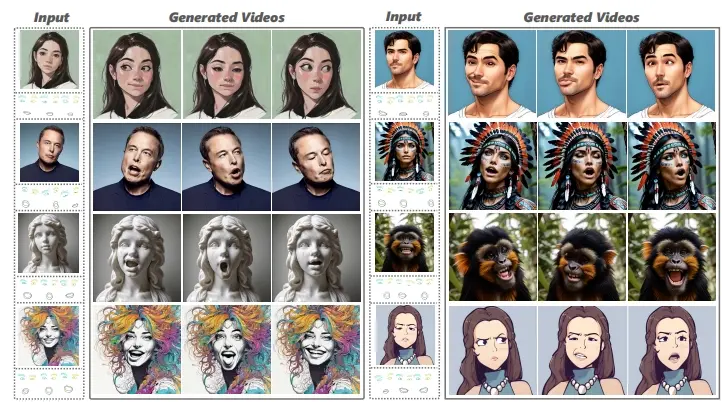

来自香港科技大学、腾讯混元团队和清华大学的研究团队推出Follow-Your系列新框架Follow-Your-Emoji,这是一种基于扩散模型的肖像动画框架。简单来说,它可以根据一系列目标表情和动作标记(landmark sequences),将这些表情和动作转移到一个参考肖像上,并且保持这个肖像的身份特征不变。

- 项目主页:https://follow-your-emoji.github.io

- GitHub:https://github.com/mayuelala/FollowYourEmoji

- 模型地址:https://huggingface.co/YueMafighting/FollowYourEmoji

这项技术通过引入表情感知的标记和面部精细损失,显著提高了自由风格肖像动画的控制性和表现力。通过简单有效的渐进式生成策略,还扩展了模型在稳定长期动画方面的潜在应用价值。此外,为了支持这一领域的研究,研究者们还引入了一个名为EmojiBench的综合基准测试,包含多种风格的肖像图像、驱动视频和标记,用于验证“Follow-Your-Emoji”的优越性。

例如,你有一个静态的肖像图片,可能是一个真实的人、卡通人物、雕塑,甚至是一只动物。现在,你想让它动起来,表达出一系列夸张的表情和动作。使用“Follow-Your-Emoji”,你只需要提供一系列表情和动作的标记,这个系统就能让静态的肖像动起来,就像它真的在做出这些表情和动作一样。

主要功能和特点:

- 身份保持:在动画过程中,能够保持参考肖像的身份特征,不发生身份信息泄露。

- 表情传递:能够将目标表情准确地传递给参考肖像,并且可以处理夸张的表情,比如瞳孔的大幅度运动。

- 时间一致性:生成的动画在时间上保持连贯性,动作流畅自然。

- 细节表达:通过面部精细损失(facial fine-grained loss)提高了模型对微妙表情变化的捕捉能力。

工作原理:

- 使用MediaPipe提取3D关键点,并将这些关键点投影到2D平面上,形成表情感知的标记(expression-aware landmarks)。

- 在投影过程中,忽略面部轮廓,只保留面部特征,以便更好地关注表情变化。

- 利用面部和表情掩码(masks),计算预测结果与真实结果在这些掩码区域内的空间距离,以此来训练模型,使其更专注于面部和表情的生成。

具体应用场景:

- 在线会议:为远程工作提供更生动的虚拟形象。

- 虚拟角色:在游戏或动画制作中,快速生成具有丰富表情的角色。

- 增强现实(AR):在AR应用中,为用户的虚拟形象添加逼真的表情和动作。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...