长久以来,视频 AI 能力被割裂为多个独立任务:

- 理解:靠视觉语言模型(如 Qwen-VL)

- 生成:依赖扩散模型(如 Sora、HunyuanVideo)

- 编辑:需专门的编辑网络或掩码引导

这种碎片化架构不仅增加部署复杂度,也限制了跨任务协同能力。

由滑铁卢大学与快手可灵团队联合提出的 UniVideo,首次将这三大能力整合进单一统一框架,用户只需一个模型,即可完成从“看懂视频”到“生成新视频”再到“自由编辑”的完整闭环。

- 项目主页:https://congwei1230.github.io/UniVideo

- GitHub:https://github.com/KlingTeam/UniVideo

- 模型:https://huggingface.co/KlingTeam/UniVideo

此模型基于HunyuanVideo(生成基座)、Qwen2.5-VL(理解基座)、MetaQueries(查询系统)开发。

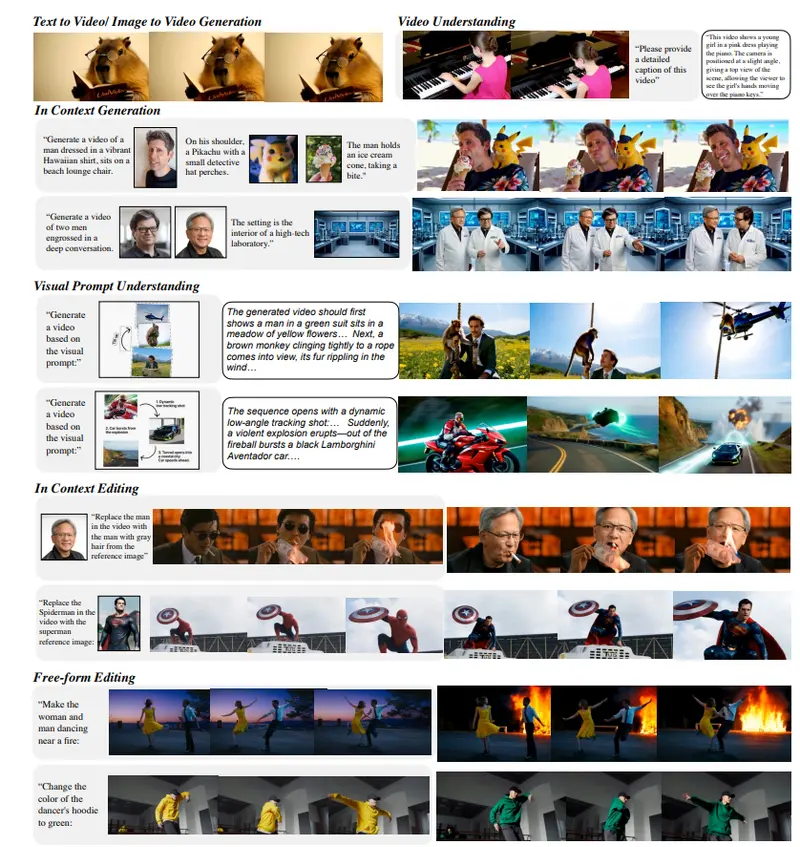

核心能力:三大任务,一套系统

- 视频理解

可回答多模态问题,如:“视频中女孩穿的是什么颜色的裙子?”、“钢琴是否在画面中央?”

在 MMBench 等基准上达到 83.5 分,媲美专用理解模型。 - 视频生成

- 文本到视频:输入“一个穿粉色连衣裙的女孩在海边弹钢琴”,生成对应高清视频

- 图像到视频:上传一张静态人像,扩展为自然动作序列(如眨眼、转头)

- 生成质量在多个指标上达到或超越当前顶尖模型

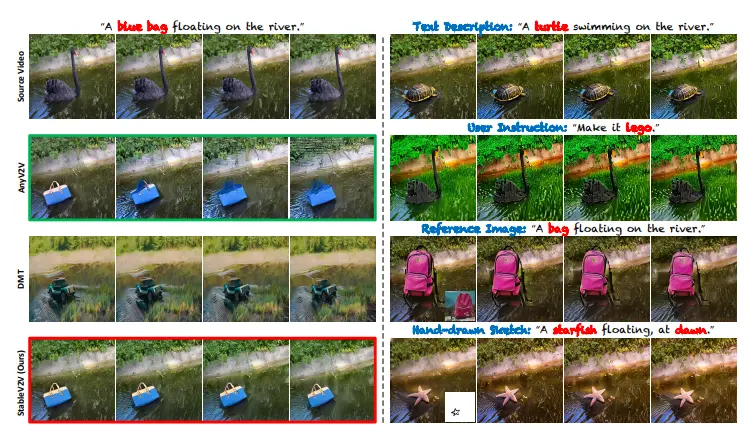

- 视频编辑

支持无掩码(mask-free)的自由形式编辑:- 替换人物身份(“把弹钢琴的女孩换成穿西装的男性”)

- 改变场景风格(“将海边背景换成夜晚森林”)

- 调整物体属性(“让钢琴变成红色”)

编辑后仍保持主体身份一致、动作流畅、视觉连贯

- 上下文感知生成/编辑

基于参考图像或视频片段,生成风格或身份一致的新内容。例如:给一张用户自拍 + 文字“在火星上跳舞”,生成该用户形象在火星场景中跳舞的视频。

技术架构:双流协同,语义驱动

UniVideo 采用双分支架构,实现理解与生成的深度耦合:

- 理解分支(基于 Qwen2.5-VL)

接收文本、图像、视频等多模态输入,解析用户意图,输出结构化语义指令。 - 生成分支(基于 HunyuanVideo 扩展的 MMDiT)

接收理解分支的语义信号 + 视觉输入(经 VAE 编码),通过扩散过程生成视频。 - 关键创新:可训练连接器(MLP)

两分支通过轻量级连接模块进行信息交互,确保生成过程严格遵循语义指令,避免“图文不符”。

训练采用多任务联合学习,同时优化文本到视频、图像到视频、上下文编辑等任务,提升泛化能力。

为何“统一”如此重要?

- 降低使用门槛:开发者无需集成多个模型,简化 pipeline

- 提升一致性:理解与生成共享语义空间,减少指令偏差

- 支持复杂指令:例如“把视频中穿红衣服的人换成穿蓝衣服,并让他走向镜头”——需先理解、再编辑,传统方案难以协同

- 节省资源:单一模型部署,减少显存与计算开销

局限与未来方向

- 当前依赖高质量参考图像/视频,对模糊输入泛化有限

- 长视频生成(>8 秒)仍具挑战

- 自由编辑的物理合理性(如光影、遮挡)需进一步优化

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...