Lightricks发布了首个基于 Diffusion Transformer(DiT) 架构的开源音视频联合生成模型LTX-2。它在一个统一框架中集成了现代视频生成的核心能力:同步的音频与视频输出、高保真画质、多阶段上采样、高效推理、API 支持与开放访问。

- GitHub:https://github.com/Lightricks/LTX-2

- 模型:https://huggingface.co/collections/Lightricks/ltx-2

- 魔塔:https://www.modelscope.cn/models/Lightricks/LTX-2

- 提示词:https://ltx.video/blog/how-to-prompt-for-ltx-2

与仅生成视频的模型不同,LTX-2 能从一段文本提示中,同时生成时间对齐的高清视频与匹配的环境音、配乐及音效,适用于叙事短片、动态演示、游戏素材等场景。

模型家族与部署选项

LTX-2 提供多种模型变体,兼顾性能、精度与硬件适配:

| 模型名称 | 说明 |

|---|---|

ltx-2-19b-dev | 完整 190 亿参数模型,支持 bf16 精度,适合训练与高保真生成 |

ltx-2-19b-dev-fp8 / fp4 | 量化版本,显著降低显存占用,适用于消费级 GPU |

ltx-2-19b-distilled | 蒸馏版,仅需 8 步采样(CFG=1),推理速度大幅提升 |

ltx-2-19b-distilled-lora-384 | 蒸馏模型的 LoRA 微调接口 |

ltx-2-spatial-upscaler-x2-1.0 | 空间上采样器,用于提升分辨率 |

ltx-2-temporal-upscaler-x2-1.0 | 时间上采样器,用于提升帧率 |

用户可根据硬件条件和输出需求,选择单阶段快速生成或多阶段高分辨率流程。

推理优化建议

为获得最佳性能,建议采取以下措施:

- 使用

DistilledPipeline:默认仅需 8 步(第一阶段)+ 4 步(第二阶段),大幅缩短生成时间; - 启用 FP8 加速:通过

--enable-fp8(CLI)或fp8transformer=True(Python)降低显存压力; - 安装注意力优化库:推荐

xFormers,Hopper 架构 GPU 可启用 Flash Attention 3; - 减少推理步数:通过梯度估计技术,可在 20–30 步内达到接近 40 步的质量;

- 禁用阶段间内存清理:若显存充足,可关闭自动清理以提升流水线效率;

- 单阶段模式:对分辨率要求不高时,使用

TI2VidOneStagePipeline获得最快响应。

如何编写有效提示词?

LTX-2 对提示词的时序性与细节密度高度敏感。建议按以下结构组织(200 字以内):

- 主动作:如“一位舞者在雨中旋转”

- 动作细节:手臂展开、裙摆飞扬、脚尖点地

- 角色外观:穿深红色丝绸长裙,黑发盘起

- 环境背景:夜晚城市街道,霓虹灯反射在湿漉漉的地面

- 镜头语言:低角度慢速环绕镜头

- 光影色彩:冷色调为主,霓虹红光点缀

- 动态变化:雨势渐大,音乐从钢琴转为弦乐

提示词应像摄影师的拍摄清单——具体、字面化、按时间顺序展开。

LTX-2 还支持通过 enhance_prompt=True 自动增强提示词语义,提升生成稳定性。

技术架构亮点

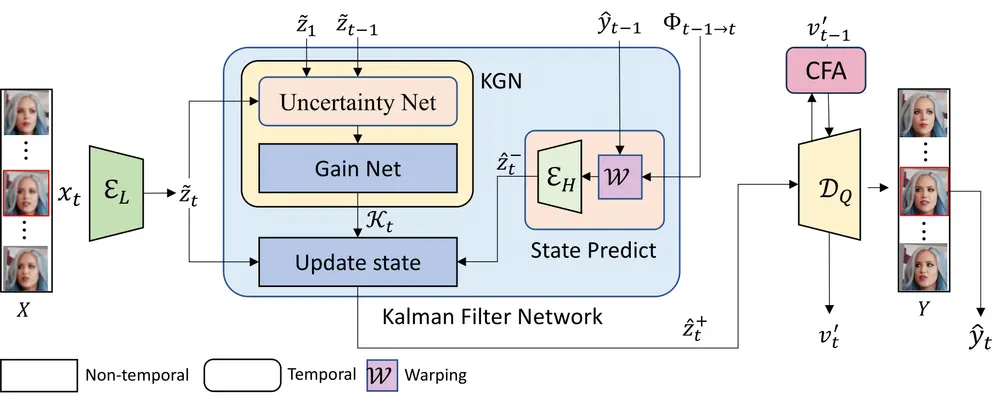

LTX-2 采用 非对称双流 Transformer 架构:

- 视频流(14B 参数):处理时空动态,使用 3D RoPE 时间位置嵌入;

- 音频流(5B 参数):处理一维音频序列,采用因果音频 VAE 生成紧凑潜表示;

- 跨模态注意力:双向连接两流,确保音视频严格对齐;

- 模态感知 CFG:可独立调节文本引导与跨模态引导强度,提升可控性;

- 多语言支持:基于 Gemma 3 的多语言编码器,支持中文、英文等多种语言输入;

- 长时序生成:支持最长 20 秒 的连续音视频输出,突破多数开源模型限制。

性能与对比

- 生成质量:在人类偏好测试中,显著优于 Ovi 等开源模型,接近 Veo 3、Sora 2 等专有系统;

- 推理速度:在 NVIDIA H100 上约 1.22 秒/步,比 Wan 2.2-14B(仅视频)快约 18 倍;

- 视频排名:在 Artificial Analysis 基准中位列开源模型前列;

- 开放性:模型权重、推理代码、工作流全部开源,支持本地部署与 API 调用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...