Mistral AI 正式推出新一代模型系列 Mistral 3,此次发布不仅包含适配边缘场景的 Ministral 3 系列小型密集模型,更带来了性能顶尖的稀疏专家混合模型 Mistral Large 3。全系列模型均基于 Apache 2.0 许可证开源,以多压缩格式对外开放,既为开发者社区提供灵活工具,也为企业级场景提供高性价比解决方案,真正实现让先进 AI 能力触达不同需求的用户。

- 官方介绍:https://mistral.ai/news/mistral-3

- Ministral 3:https://huggingface.co/collections/mistralai/ministral-3

- Mistral Large 3:https://huggingface.co/collections/mistralai/mistral-large-3

两大核心产品线:兼顾极致性能与边缘灵活部署

Mistral 3 系列采用“分级适配”思路,推出两大核心产品线,分别对应企业级复杂任务和边缘端轻量化需求,覆盖 3B 到 675B 参数的全场景跨度。

1. Mistral Large 3:开源领域的性能标杆

作为 Mistral 自 Mixtral 系列后首款专家混合模型,Mistral Large 3 堪称开源模型中的性能强者。它以 675B 总参数搭配 41B 活跃参数的架构设计,在 3000 块 NVIDIA H200 GPU 上完成从头训练,兼顾了算力效率与模型能力。

- 核心优势突出:通用提示处理能力比肩市面顶尖指令微调开放权重模型,同时在图像理解和非英语、非中文的多语言对话场景中表现尤为出色。

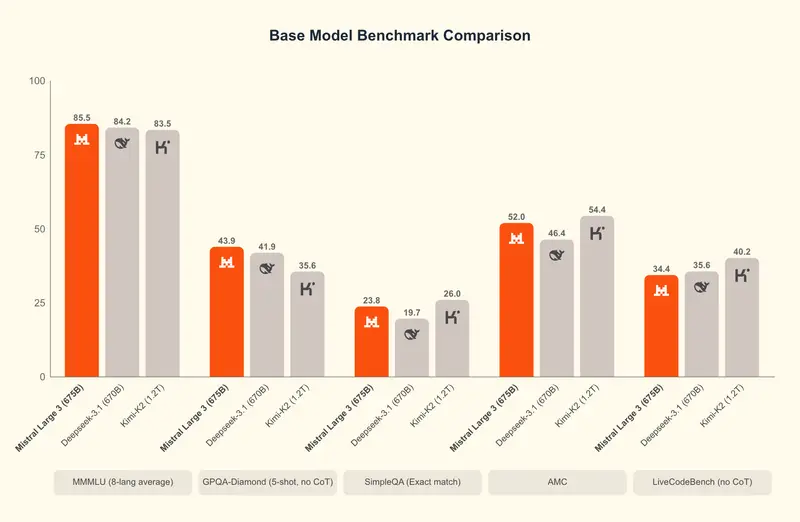

- 榜单成绩亮眼:首次亮相 LMArena 排行榜便在 OSS 非推理模型类别中位居第 2,在所有开源模型中排名第 6,实力得到权威榜单验证。

- 版本全面开放:同步发布基础版和指令微调版本,为企业和开发者的二次定制提供扎实基础,推理版本也将在后续上线。

2. Ministral 3:边缘设备的轻量化智能之选

针对边缘计算和本地部署场景,Ministral 3 系列提供 3B、8B、14B 三种参数尺寸,且每种尺寸均包含基础版、指令版和推理版变体,全版本都具备图像理解能力,适配不同边缘场景需求。

- 性价比拉满:在开源模型中性价比优势显著,指令模型的性能达到甚至超越同类别模型,而生成令牌数量却比同类模型少一个数量级,大幅降低部署和运行成本。

- 精准适配场景:推理变体可通过延长思考时间提升准确性,其 14B 变体在 AIME '25 中更是取得 85% 的优异成绩,适合对准确性要求极高的场景;原生支持的多模态、多语言能力,也让它能灵活应对各类边缘端智能需求。

多方技术合作:让模型部署更高效易用

Mistral AI 联合英伟达、vLLM、Red Hat 三大技术伙伴,从硬件适配、推理优化到部署场景拓展多维度发力,大幅降低了 Mistral 3 系列的使用门槛,提升了运行效率。

| 合作方 | 核心合作内容 |

|---|---|

| vLLM | 助力 Mistral Large 3 适配优化,其 NVFP4 格式检查点可支持模型在 Blackwell NVL72 系统,以及单个 8×A100 或 8×H100 节点上通过 vLLM 高效运行 |

| 英伟达 | 提供全链路技术支持:所有 Mistral 3 模型均基于 NVIDIA Hopper GPU 训练,借助 HBM3e 内存处理大规模工作负载;为系列模型适配 TensorRT - LLM 和 SGLang 实现低精度高效推理;针对 Large 3 的稀疏 MoE 架构,集成 Blackwell Attention 和 MoE 内核,支持预填充/解码分离服务;同时实现 Ministral 模型在 DGX Spark、RTX 电脑、Jetson 设备等多终端的优化部署 |

| Red Hat | 协同优化模型的开源适配性,助力模型在更多企业级开源环境中稳定运行 |

这些合作构建起从数据中心到机器人设备的全场景部署路径,让不同技术条件的用户都能获得高性能的模型运行体验。

多平台同步上线,即刻开启使用

目前 Mistral 3 系列已实现多平台全覆盖,开发者和企业可通过多种渠道快速接入:

已上线平台包括 Mistral AI Studio、Amazon Bedrock、Azure Foundry、Hugging Face、Modal、IBM WatsonX、OpenRouter、Fireworks、Unsloth AI 以及 Together AI;后续还将陆续登陆 NVIDIA NIM 和 AWS SageMaker,进一步拓宽获取和使用渠道。

定制化服务:满足企业专属需求

除了通用开源模型,Mistral AI 还为有特殊需求的组织提供定制模型训练服务。无论是针对特定领域任务优化模型、基于专有数据集提升模型性能,还是适配独特环境完成模型部署,其团队都会深度协作,打造贴合企业目标的 AI 系统。这种定制化模式能确保企业级部署的安全性、高效性和规模化落地能力,适配不同行业的个性化需求。

选择 Mistral 3 的四大核心理由

- 开放与性能兼顾:以开源模式提供透明可控的使用体验,同时实现媲美闭源模型的性能表现,打破“开源即性能妥协”的固有认知。

- 多模态多语言全能:原生支持文本、图像理解,可流畅应对 40 多种语言的相关任务,适配全球化、多场景的应用开发需求。

- 全场景可扩展:参数规模从 3B 到 675B 梯度分布,既能满足边缘设备的轻量化部署,也能支撑企业级复杂工作流的高效运行。

- 高适配性强灵活:可精准应用于编码、创意协作、文档分析、工具调用等多种工作流,轻松适配不同用户的差异化使用场景。

快速上手 Mistral 3 的行动指南

- 查阅详细文档:可针对性查看 Ministral 3 各参数版本(3B - 25 - 12、8B - 25 - 12、14B - 25 - 12)及 Mistral Large 3 的专属文档,了解技术细节;企业客户还能在 AI 治理中心获取专属技术文档。

- 快速启动开发:通过 Hugging Face 上的 Ministral 3 和 Mistral Large 3 资源,或直接登录 Mistral AI 平台,获取 API 访问权限并了解定价,快速开展应用构建。

- 定制专属方案:若通用模型无法满足需求,可联系 Mistral AI 团队,沟通模型微调或企业级定制训练事宜,打造贴合自身业务的 AI 解决方案。

相关文章