在影视后期、广告制作乃至虚拟内容创作中,“将一个新角色或物体自然地加入已有视频”是一项高频需求。传统方法依赖精确的遮罩标注、关键帧追踪和复杂的合成流程,成本高、耗时长。

近期,基于扩散模型的技术为这一任务带来了新的可能。然而,大多数现有方案仍需用户提供掩码、关键点或运动轨迹等控制信号,限制了易用性和自动化程度。

来自字节跳动智能创作实验室的研究团队提出了 OmniInsert ——一种全新的无遮罩视频插入框架,支持从单个图像或多个参考图中提取主体,并将其自然融入目标视频,全过程无需任何手动遮罩或位置指定。

该工作不仅展示了强大的生成能力,还构建了专用数据流水线与评估基准,推动了该方向的系统化发展。

什么是无遮罩视频插入?

简单来说,给定一段原始视频(如空旷街道)和一张或多张参考图像(如一个人、一只狗),OmniInsert 能自动:

- 识别并提取参考中的主体

- 判断其在视频中的合理出现位置与姿态

- 合成符合场景光照、视角和运动逻辑的新画面

- 将主体无缝插入,形成连贯自然的新视频

整个过程不需要用户绘制掩码、不依赖额外控制信号,真正实现了“上传即插入”。

面临三大挑战:数据、平衡与协调

尽管目标明确,实现高质量无遮罩插入仍面临三个核心难题:

1. 数据稀缺

缺乏大规模、多样化的“源视频+插入对象+真实融合结果”三元组数据,难以训练鲁棒模型。

2. 主体-场景失衡

模型容易过度关注主体细节而破坏背景一致性,或反之,导致插入对象显得突兀。

3. 插入协调性差

插入对象的姿态、运动轨迹、光影效果常与原始场景脱节,影响真实感。

OmniInsert 通过一套完整的技术链条,逐一应对这些问题。

技术架构解析:五大核心创新

一、InsertPipe:自动化构建训练数据

为解决数据瓶颈,团队提出 InsertPipe——一个自动生成多样化训练样本的数据流水线,包含三条分支:

- RealCapture Pipe:采集真实人物在不同场景下的动作视频,作为高质量主体来源。

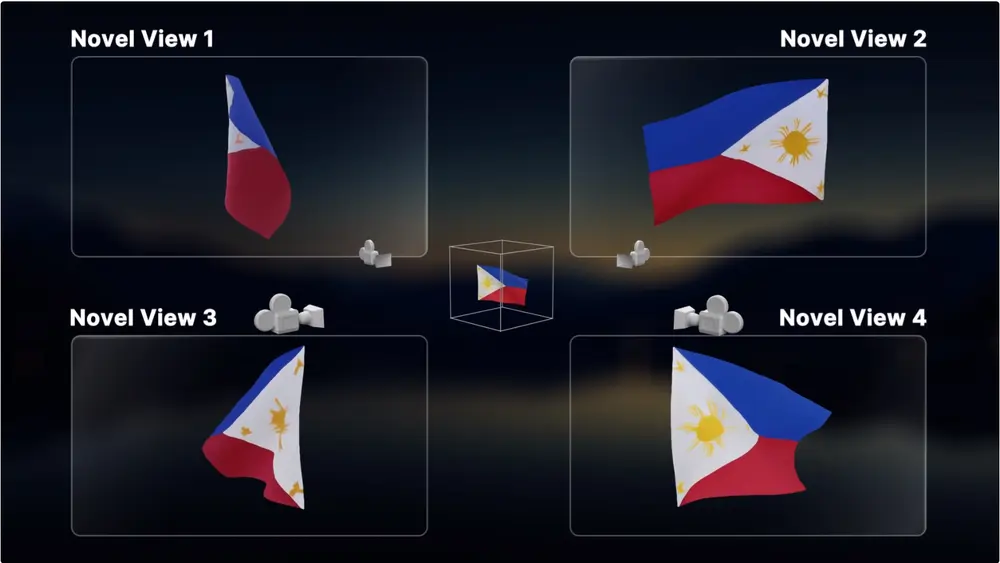

- SynthGen Pipe:利用3D建模与渲染技术生成虚拟主体与交互场景,增强多样性。

- SimInteract Pipe:模拟主体与环境的互动行为(如行走、跳跃),生成动态交互数据。

这些合成数据保留了真实的物理关系与视觉一致性,为模型训练提供了丰富且可控的监督信号。

二、条件特定特征注入(CFI):区分处理,保持平衡

传统方法常将视频上下文与参考对象混合编码,导致特征干扰。OmniInsert 提出 条件特定特征注入(Conditional Feature Injection, CFI),在U-Net结构中分别引入两类特征:

- 来自源视频的时间-空间上下文信息

- 来自参考图像的主体外观与结构特征

通过门控机制控制注入强度,确保两者互不干扰,实现主体与背景的协同演化。

三、渐进式训练策略(PT):分阶段优化插入质量

为了稳定训练过程并提升最终效果,OmniInsert 采用四阶段渐进训练:

- 基础重建:仅用源视频重建自身,建立时空建模能力

- 单对象注入:引入单一参考对象,学习基本插入逻辑

- 多对象协同:支持多个参考输入,处理复杂组合

- 偏好微调:结合人类反馈进一步优化视觉合理性

这种由简到繁的设计,显著提升了模型泛化能力和稳定性。

四、插入偏好优化(IPO):让模型更懂“自然”

即使生成结果技术上正确,也可能不符合人类审美。为此,团队收集了大量人工标注的偏好对(Preference Pairs),用于训练一个奖励模型,并在此基础上进行强化学习微调。

这项 插入偏好优化(Insertion Preference Optimization, IPO) 显著减少了颜色偏差、比例失调和物理不合理现象,使输出更贴近真实创作标准。

五、上下文感知重述器(CAR):让提示更“聪明”

在推理阶段,用户输入的文本提示往往过于简略(如“插入一只奔跑的狗”)。OmniInsert 引入 上下文感知重述器(Context-Aware Re-prompter, CAR),利用视觉语言模型(VLM)分析原视频内容,自动生成更详细的补充描述:

“一只金毛犬从左侧进入画面,在阳光照射的草地上向右奔跑,影子投射在地面,速度适中。”

这种增强后的提示显著提升了插入对象的空间定位准确性和视觉融合度。

新建基准 InsertBench:填补领域空白

目前尚无专门针对无遮罩视频插入的公开评测集。为此,团队构建了 InsertBench ——首个面向该任务的综合性基准测试,包含:

- 120段高清视频,涵盖城市、自然、室内等多种场景

- 每段视频配备多个精心挑选的插入对象(人、动物、车辆等)

- 多维度评估指标:主体一致性、文本-视频对齐、时间连贯性、视觉质量等

InsertBench 的发布,为后续研究提供了统一的比较平台。

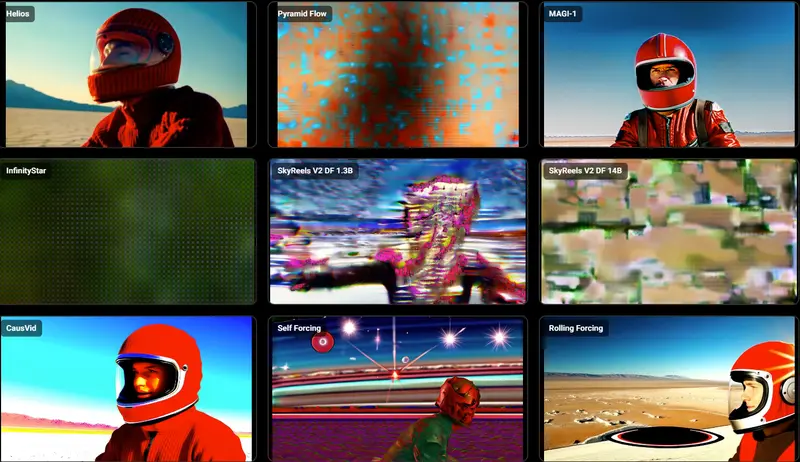

实验结果:超越主流闭源方案

在 InsertBench 上的全面评估显示,OmniInsert 在多项指标上显著优于现有先进方法,包括 Pika-Pro 和 Kling 等闭源商业模型:

| 指标 | OmniInsert | Pika-Pro | Kling |

|---|---|---|---|

| 主体一致性 CLIP-I* | 0.745 | 0.682 | 0.664 |

| 文本-视频对齐 ViCLIP-T | 25.945 | 24.721 | 23.091 |

此外,用户研究结果表明,OmniInsert 在以下方面获得更高评分:

- 主体一致性:65.50%

- 文本对齐:68.33%

- 插入合理性:64.41%

- 综合体验:68.34%

均明显领先基线方法。

当前局限与未来方向

尽管表现优异,OmniInsert 仍有改进空间:

- 颜色保真度:部分案例中存在轻微色偏,尤其在复杂光照下

- 物理合理性:少数情况下运动轨迹不符合真实动力学

- 推理速度:当前平均推理时间为90秒/视频,尚未达到实时水平

未来工作可探索:

- 更精细的物理约束建模

- 基于蒸馏或轻量化架构的加速方案

- 支持更大规模多主体并发插入

相关文章