Ollama 正式推出云模型(Cloud Models)预览功能,让开发者在不牺牲隐私和工具链的前提下,运行远超本地设备能力的大型语言模型。

现在,你可以在个人电脑上继续使用熟悉的 ollama run 命令和现有工作流,而实际计算由 Ollama 的高性能数据中心完成。这意味着:

✅ 更大模型可运行(如 480B、671B 参数级)

✅ 不再受限于显存或硬件配置

✅ 所有数据不会被存储,保障隐私安全

这一更新实现了 “本地体验,云端算力” 的无缝融合。

核心特性一览

| 特性 | 说明 |

|---|---|

| 🔗 统一操作接口 | 使用与本地完全相同的 CLI 和 API,无需学习新语法 |

| ☁️ 强大云端算力 | 支持数百亿甚至上千亿参数的大模型推理 |

| 🛡️ 隐私优先 | Ollama 云端不保留用户输入内容或生成结果 |

| 🧩 兼容现有生态 | 完美集成 Ollama 工具链、OpenAI 类 API 及第三方应用 |

快速开始

第一步:升级到 Ollama v0.12+

确保已安装最新版本客户端:

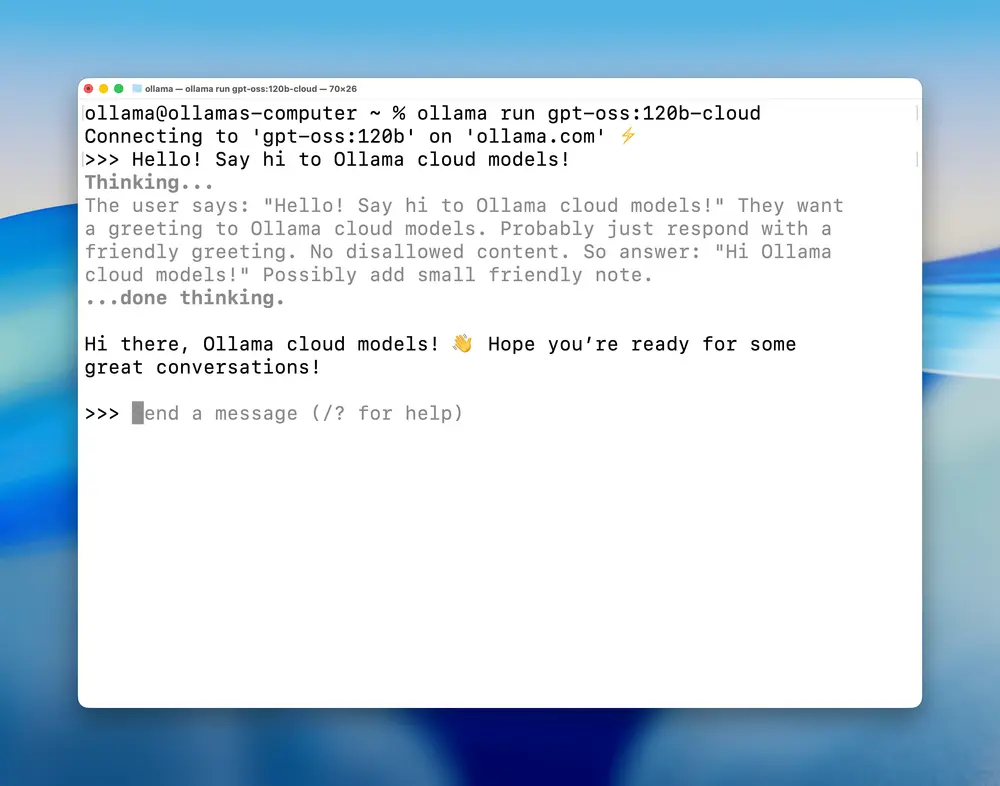

第二步:运行云模型

只需一条命令即可启动云端模型,语法与本地一致:

ollama run qwen3-coder:480b-cloud

支持的云模型包括:

qwen3-coder:480b-cloud—— 超大规模代码专用模型gpt-oss:120b-cloud/gpt-oss:20b-cloud—— 开源通用模型系列deepseek-v3.1:671b-cloud—— 高性能长上下文模型

注:带有

-cloud后缀的模型标识表示其运行在云端。

管理你的云模型

所有标准 Ollama 命令均适用:

# 查看已加载的模型

ollama ls

# 输出示例:

NAME ID SIZE MODIFIED

gpt-oss:120b-cloud 569662207105 - 5 seconds ago

deepseek-v3.1:671b-cloud d3749919e45f - 2 days ago

qwen3-coder:480b-cloud 11483b8f8765 - 2 days ago

你可以像管理本地模型一样进行拉取、调用和复制:

ollama pull gpt-oss:120b-cloud

ollama cp gpt-oss:120b-cloud my-large-model

在程序中调用云模型

云模型通过 Ollama 的 OpenAI 兼容 API 提供服务,支持 JavaScript、Python、cURL 等多种方式接入。

JavaScript 示例

npm install ollama

import ollama from 'ollama';

const response = await ollama.chat({

model: 'gpt-oss:120b-cloud',

messages: [{ role: 'user', content: 'Why is the sky blue?' }],

});

console.log(response.message.content);

Python 示例

pip install ollama

import ollama

response = ollama.chat(

model='gpt-oss:120b-cloud',

messages=[{'role': 'user', 'content': 'Why is the sky blue?'}]

)

print(response['message']['content'])

cURL 直接调用

curl http://localhost:11434/api/chat -d '{

"model": "gpt-oss:120b-cloud",

"messages": [

{"role": "user", "content": "Why is the sky blue?"}

],

"stream": false

}'

所有请求通过本地

ollama客户端转发至云端,终端用户无感知差异。

登录与认证

由于云模型使用 Ollama 数据中心资源,需登录账户以启用访问权限:

# 登录 ollama.com

ollama signin

登录后,所有模型调用将自动路由至云端(若为 cloud 模型),无需额外配置。

如需退出:

ollama signout

直接使用云 API

除了通过本地客户端访问,你也可以直接调用 Ollama 云端 API,适用于服务器端部署或 CI/CD 场景。

详情请参考官方文档:https://docs.ollama.com

更大的模型,不变的工作流

Ollama 云模型的核心理念是:让你专注于构建,而不是运维和硬件限制。

无论你是开发 AI 应用、做研究实验,还是尝试前沿大模型,现在都可以:

- 使用统一命令行工具

- 保持原有集成方式

- 安全地运行更大更强的模型

无需改变习惯,就能获得数据中心级别的推理能力。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...