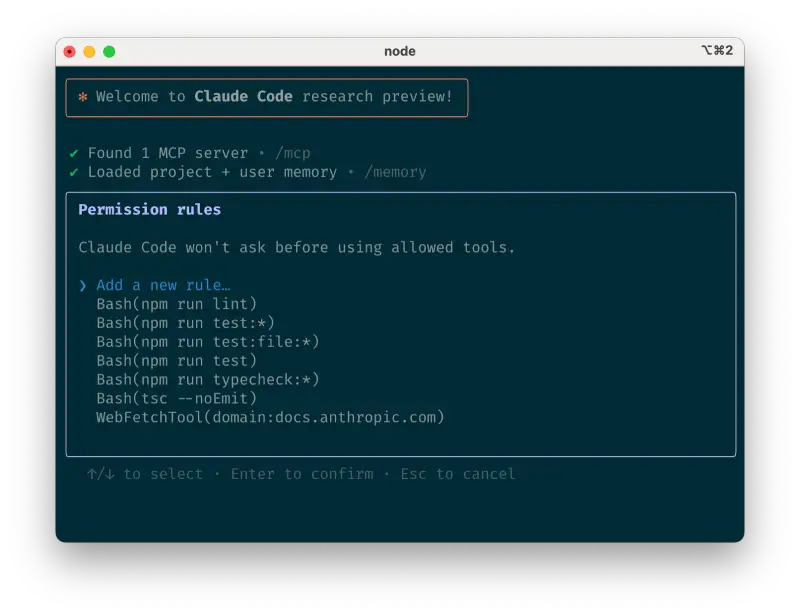

从本周二起,OpenAI 新发布的两款开源推理模型将正式在 AWS 平台上线,通过其 AI 服务 Bedrock 和 SageMaker 提供。这是 OpenAI 的模型首次在 AWS 上可用,标志着这家全球最大的云服务商终于接入了当前最热门的 AI 模型生态。

尽管这两款模型也可在 Hugging Face 免费下载,但 AWS 的集成是在 OpenAI 明确授权和支持下完成的——正如 OpenAI 产品负责人 Dmitry Pimenov 所指出,这种合作模式类似于今年早些时候 AWS 引入 DeepSeek-R1 的方式。

这意味着企业用户无需自行部署或管理模型,就能在 AWS 的托管环境中直接调用 OpenAI 的能力,用于构建生成式 AI 应用或数据分析系统。

为什么这次合作意义重大?

对 AWS 而言,这不仅是一次技术接入,更是一次战略补位。

长期以来,AWS 虽然在云基础设施领域占据领先地位,但在生成式 AI 的竞争中却显得被动。它的主要合作伙伴是 Anthropic——开发 Claude 的公司,也是 OpenAI 的重要竞争对手之一。此外,AWS 还集成了来自 Cohere、Meta、Mistral 等多家厂商的模型,力图打造一个“多模型共存”的 AI 平台。

然而,缺少 OpenAI 模型的支持,始终是其 AI 生态中的一个显眼缺口。

相比之下,微软 Azure 自 2023 年起便成为 OpenAI 的首选云合作伙伴,承担其训练和推理所需的绝大部分算力支持。即便今年初 OpenAI 开始拓展与其他云厂商的合作,Azure 依然是其最紧密的技术与商业盟友,甚至此次新模型也推出了专为 Windows 设备优化的 Azure 版本。

这让 AWS 高层倍感压力。

在最近一次财报电话会议上,亚马逊 CEO Andy Jassy 面对分析师接连提问时罕见地做出强硬回应。当被问及为何 AWS 在生成式 AI 领域“落后于人”、是否面临市场份额流失风险时,Jassy 明确表示:“所谓第二大云厂商,规模其实只有我们的 65%。” 言语之间,矛头直指微软。

不只是追赶:一场双向赋能的合作

这次与 OpenAI 的合作,远不止是 AWS 单方面的“补课”。

对 OpenAI 来说,在与微软关系趋于复杂的背景下,拓展与 AWS 的合作是一种关键的战略平衡。据多家媒体报道,双方正在重新谈判长期合作协议,而 OpenAI 也在积极寻求技术与资源上的多元化布局。

更值得注意的是,Oracle 最近披露了一项与 OpenAI 的潜在协议:每年高达 300 亿美元的数据中心服务交易。如果属实,这意味着 OpenAI 将把大量算力需求转向 Oracle,其支出甚至可能超过其他所有云客户的总和。

在此背景下,AWS 与 OpenAI 达成合作,虽初期规模有限,却释放出明确信号:OpenAI 正在有意识地构建多云部署能力,不再依赖单一供应商。

而对 AWS 的企业客户而言,这一变化带来了真正的便利——他们现在可以在熟悉的云环境中,无缝测试和部署 OpenAI 模型,而无需重构架构或迁移数据。

开源背后的战略博弈

此次上线的两款模型,属于 OpenAI 最新发布的开源系列,性能接近其商用 o 系列模型。更重要的是,它们采用 Apache 2.0 许可证发布,允许自由使用、修改和商业化。

这一举动也间接影响了另一家科技巨头:Meta。

近期,Meta 表示未来可能不再对所有高级 AI 模型保持完全开源。这与其此前推动 Llama 系列开源的立场形成对比。而 OpenAI 此次以宽松许可证发布高性能模型,无疑在开源社区投下了一颗重量级棋子——既赢得了开发者支持,也在与 Meta 的路线之争中占据了道德与生态高地。(来源)

相关文章