英伟达(NVIDIA)宣布与 OpenAI 深度合作,将后者最新发布的开放权重模型 gpt-oss-20b 和 gpt-oss-120b 带入消费级与专业级设备端,依托 GeForce RTX 与 RTX PRO 显卡 实现前所未有的本地推理性能。

这是 OpenAI 首次将其前沿模型通过优化支持在个人设备上高效运行,标志着 AI 能力正从“云端专属”加速向“本地普惠”演进。

“OpenAI 展示了在 NVIDIA AI 上能构建什么——现在,他们正推动开源软件的创新。”

——英伟达创始人兼 CEO 黄仁勋(Jensen Huang)

性能突破:RTX 5090 实现 250 token/s

在英伟达优化下,gpt-oss 系列模型在 RTX 硬件上展现出惊人效率:

- gpt-oss-20b:在 RTX 5090 上实现高达 250 令牌/秒 的推理速度,适合低延迟、高响应的本地 AI 应用;

- gpt-oss-120b:由 RTX PRO 系列专业显卡 加速支持,适用于科研、工程与企业级工作站场景。

这两款模型均在 NVIDIA H100 GPU 上完成训练,并首次在 RTX 平台支持 MXFP4 量化格式——一种在不牺牲精度的前提下显著降低内存占用、提升计算效率的技术。

此外,模型支持高达 131,072 token 的上下文长度,是当前本地推理模型中上下文最长的之一,适用于长文档分析、代码库理解等复杂任务。

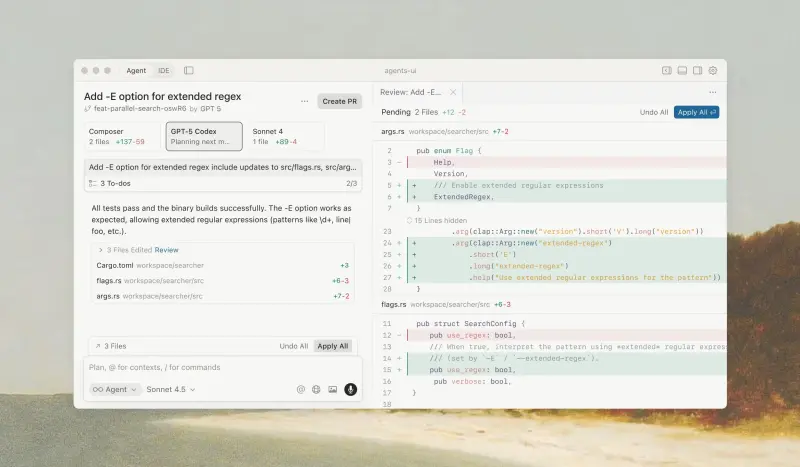

技术架构:为高效推理而生

gpt-oss 系列基于以下关键技术构建:

- 混合专家(MoE)架构:仅激活部分参数,大幅提升推理效率;

- 链式推理(Chain-of-Thought, CoT):支持多步逻辑推导;

- 工具调用能力:可集成代码执行、网页搜索等外部工具;

- 灵活部署:支持云、边缘、本地多种环境。

这些特性使其不仅适合生成任务,更能驱动 AI 代理完成复杂工作流。

如何在 RTX 设备上运行 gpt-oss?

英伟达联合多个生态伙伴,为开发者提供多种便捷接入方式:

✅ Ollama 应用(推荐入门)

- 提供图形化界面,一键下载并运行

gpt-oss:20b或gpt-oss:120b; - 原生支持 MXFP4 格式,针对 RTX 显卡 全面优化;

- 支持 Windows、macOS 和 Linux。

ollama run gpt-oss:20b

✅ Llama.cpp(高性能定制)

- 英伟达已向开源社区贡献多项 CUDA 优化;

- 使用 CUDA Graphs 减少内核启动开销,提升吞吐;

- 适合需要精细控制内存与性能的开发者。

GitHub 仓库:https://github.com/ggml-org/llama.cpp

✅ Microsoft AI Foundry(Windows 开发者)

- Windows 用户可通过 AI Foundry Local(公开预览版)直接调用模型;

- 命令行即可启动:

foundry model run gpt-oss-20b

该方案结合 ONNX Runtime 与 DirectML,充分发挥 RTX 显卡性能。

生态协同:英伟达+ OpenAI + Ollama 的“黄金三角”

此次合作不仅是硬件与模型的对接,更是全栈生态的协同升级:

- OpenAI 提供最先进的开放模型(Apache 2.0 许可)

- Ollama 提供极简本地运行环境

- NVIDIA 提供硬件级性能优化与 MXFP4 支持

这三者的结合,让普通开发者也能在笔记本上运行接近 o4-mini 能力的模型,真正实现“高端模型平民化”。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...