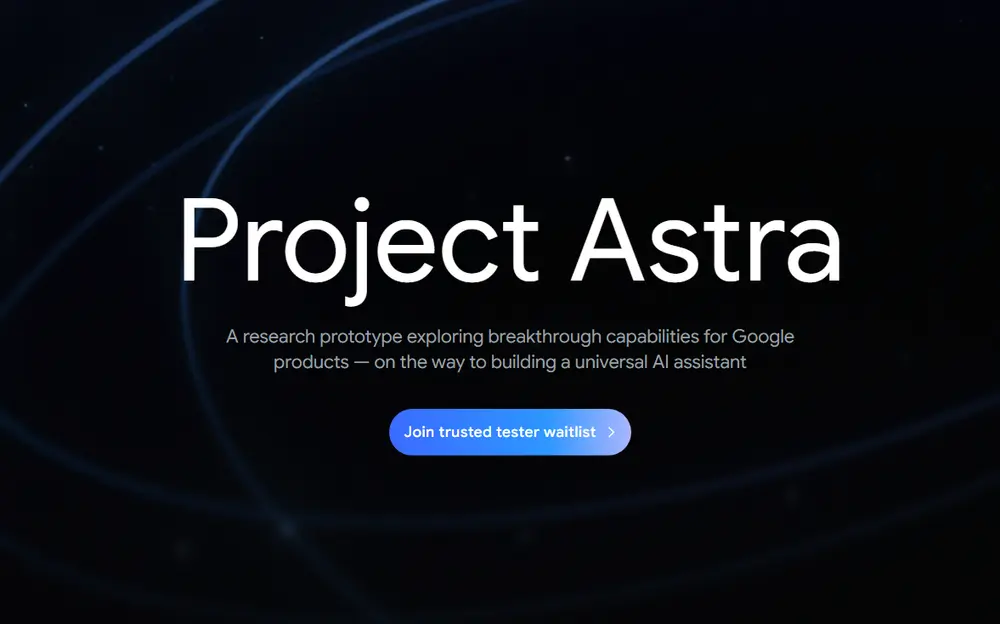

在刚刚结束的 Google I/O 2025 大会上,谷歌宣布其多模态 AI 系统 Project Astra 将正式进入多个核心产品线,包括 Google 搜索、Gemini 应用 以及面向开发者的 API 接口。这标志着该项目从概念验证迈向实际应用的关键一步。

Project Astra 是谷歌打造的一款低延迟、多模态 AI 体验系统,旨在实现语音、视觉和实时数据处理的高度协同。它最初于 2024 年 Google I/O 上以一款智能眼镜原型亮相,展示出近乎实时的 AI 视觉理解能力。如今,这一技术正在被更广泛地部署到日常使用场景中。

🎯 Project Astra 的核心应用场景

✨ 支持 Search Live:让“看到”成为搜索方式

这是本次更新中最引人注目的功能之一:

- 在 Google 搜索的 AI 模式 或 Lens(视觉搜索) 中,用户可以点击 “Live” 按钮;

- 通过手机摄像头拍摄现实世界中的画面,向 AI 提问所见内容;

- Project Astra 将实时视频流和音频输入模型,并几乎无延迟地返回回答。

这意味着你不再只是“输入关键词”去搜索,而是可以直接“指着东西提问”。

👓 智能眼镜合作推进中

虽然去年展示的 Project Astra 智能眼镜原型 尚未公布具体发布时间,但谷歌透露目前已与 三星、Warby Parker 等品牌展开合作,共同开发基于 Project Astra 的可穿戴设备。

尽管尚未商业化落地,但这些合作表明谷歌仍在持续推进其“第一视角 AI 助手”的愿景,未来或许将催生一个全新的智能眼镜品类。

🔧 面向开发者的 Live API 升级

为了让更多开发者接入 Project Astra 的能力,谷歌发布了新版 Live API:

- 开发者可构建支持音频+视觉输入 + 原生音频输出的 AI 应用;

- 新增了情感识别能力,使 AI 回应更加自然、贴合语境;

- 结合 Gemini 模型的推理能力,提升交互的深度与准确性。

该 API 已从大会当日开放访问权限,为第三方产品快速集成提供了基础。

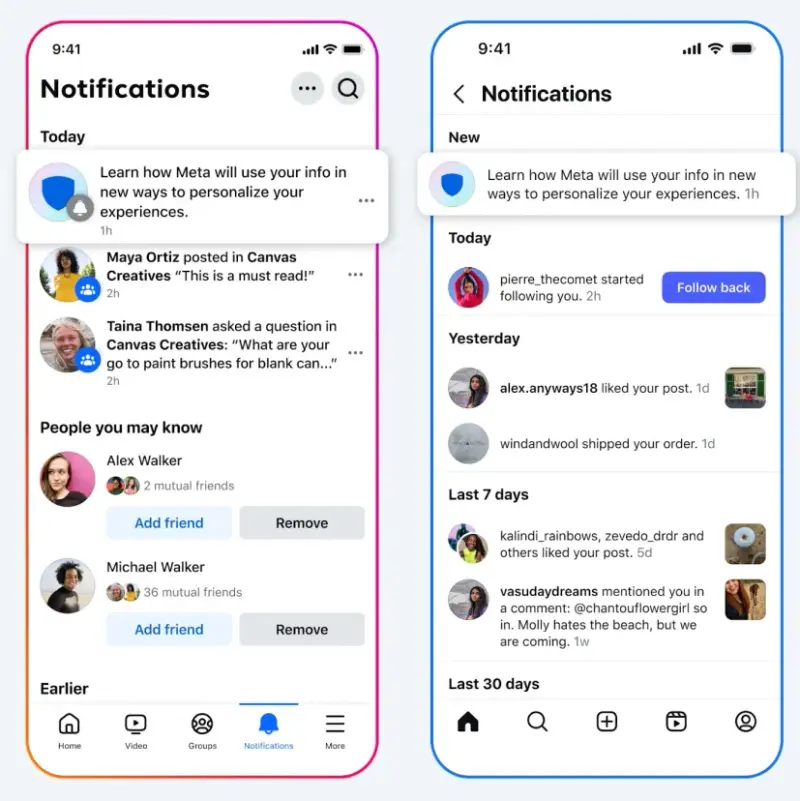

🧠 Gemini 应用全面开放视觉能力

此前,Gemini Live 的低延迟对话功能已受到用户欢迎,但视觉输入仅限于付费订阅用户。

现在,Project Astra 的视觉能力将对所有 Gemini 用户开放:

- 可上传屏幕截图、照片等图像内容;

- Gemini 能结合上下文进行分析并生成回应;

- 极大地提升了 AI 在教育、辅助写作、视觉问答等场景下的实用性。

📱 Android 与 iOS 用户同步受益

Project Astra 的能力不仅服务于谷歌自家产品,也将通过 SDK 和 API 向移动开发者开放:

- iOS 用户可通过官方 App 使用最新功能;

- Android 用户也将逐步获得相同体验;

- 所有开发者均可利用 Live API 构建自己的多模态 AI 产品。

虽然智能眼镜仍处于研发阶段,但 Project Astra 已经在搜索、Gemini、开发者工具等多个方向落地,预示着谷歌正朝着“无处不在的 AI 交互”目标稳步迈进。

相关文章