在代码编辑中,真正消耗时间的往往不是“写代码”,而是重构、调整、维护与迭代。传统自动补全工具只能在光标处插入文本,面对复杂的多行修改仍需手动操作,打断开发节奏。

为此,开发工具团队 Continue 推出全新开源模型 —— Instinct,一个专为“Next Edit”任务设计的开放代码编辑模型。它不仅能理解你的编辑意图,还能预测并执行下一步修改,将原本数十次按键的操作简化为一次确认。

据实测,Instinct 可使编辑效率提升 6.4 倍(相比最优手动路径),且完全支持本地运行,保护代码隐私。

什么是 Next Edit?超越传统补全的新范式

| 维度 | 传统自动补全 | Next Edit(Instinct) |

|---|---|---|

| 修改范围 | 仅光标处插入 | 跨行重写(增删改) |

| 复杂操作 | 多次接受 | 单次完成复杂重构 |

| 上下文感知 | 局限于当前行 | 理解近期编辑轨迹 |

| 开发流程影响 | 频繁中断 | 减少交互,保持流畅 |

举个例子:你想重构一个函数,删除旧参数、修改返回类型、更新函数体。这一过程通常需要超过 40 次按键和多次光标跳转。

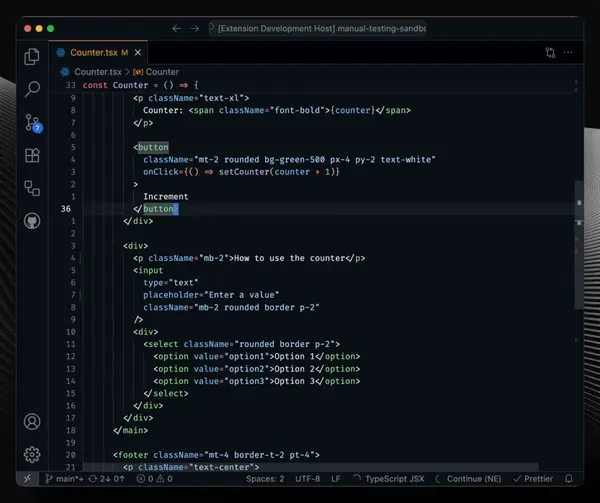

使用 Instinct,你只需继续编码,模型会基于你的编辑模式自动识别意图,生成完整修改建议,按 Tab 一键应用即可完成。

它不是“帮你写代码”,而是“帮你完成下一次编辑”。

为什么需要一个开放的 Next Edit 模型?

尽管近期已有如 Zed 的 Zeta 等模型在代理式编程领域取得进展,但面向 Next Edit 的高质量开放模型仍属空白。

Continue 团队认为,这类模型必须满足两个核心需求:

- 可本地运行:保障代码隐私,避免敏感信息上传;

- 可定制化:允许开发者根据项目风格微调模型行为。

因此,他们选择从零开始训练一个完全开放、可在本地 GPU 上运行的模型——Instinct,基于 Qwen2.5-Coder-7B 架构,现已开源权重、训练流程与数据集。

训练方法:真实数据 + 多语言扩展 + 稳健微调

1. 基于真实开发行为的数据采集

Instinct 的训练数据并非合成或来自 Git 提交日志,而是从 Continue 团队在真实开源项目中的开发行为中自动收集的 4000+ 个高质量编辑序列,数量级远超现有公开数据集。

每个样本包含:

- 最近五次编辑记录

- 相关文件上下文

- 当前可编辑区域(以光标为中心的代码块)

- 开发者最终的实际修改

通过基于行和时间的启发式规则,将原始按键流“分块”为语义完整的编辑单元,并过滤掉重复调试类操作,确保训练数据高效、非冗余。

2. 多语言能力构建

由于团队主要使用 TypeScript,为避免模型偏向单一语言,团队采用自托管的 Qwen3-Coder-30B 模型,将原始 TypeScript 编辑合成到 Java、C、Python 和 Rust 等语言中,构建多语言训练集。

配合严格的数据校正与过滤机制,确保合成数据保持语义一致性与编辑分布合理性。

3. 使用 SeleKT 算法进行高效微调

传统 LoRA 微调固定了参数更新范围,而全量微调易导致预训练知识遗忘。

Instinct 采用 Continue 自研的 Selective Knowledge Transfer (SeleKT) 算法:

- 先计算完整梯度(类似全量微调)

- 提取幅度最大的前 k% 参数进行稀疏更新

- 其余参数保持不变

这种方法只更新对 Next Edit 任务最关键的权重,既保留了原始模型的通用编码能力,又精准适配了编辑预测任务。

最终,仅微调 Qwen2.5-Coder-7B 的 5% 参数,训练 5 个 epoch,在多种语言上均达到高验证性能。

性能表现:质量与速度双领先

1. 质量评估:LLM 评判得分 3.877(开源 SOTA)

为客观评估生成结果,团队使用 Claude 作为评判模型,采用五分制评分标准:

| 分数 | 含义 |

|---|---|

| 5 | 功能完全匹配真实编辑 |

| 4 | 相似但非精确匹配 |

| 3 | 不同但合理 |

| 2 | 不合逻辑 |

| 1 | 可能阻碍开发 |

| 0 | 格式错误或无关 |

Instinct 在保留测试集上取得 平均 3.877 分,优于 Zed Zeta 的 3.735 分,成为当前开源 Next Edit 模型中的最高分纪录。

注:评分系统经过优化,避免了此前方法中“只出 0 或 5 分”的极端化问题。

2. 效率提升:比最优手动路径快 6.4 倍

团队通过 Coeditor 按键距离模型 估算手动编辑的最短时间:

- 使用 Levenshtein 距离提取字符级差异

- 将其转化为编辑操作序列(插入、删除、跳转)

- 模拟最优按键路径(含高亮删除、快捷跳转)

- 假设输入速度为 90 WPM

结果显示:即使开发者以理论最快方式手动修改,Instinct 的建议(推理 + 一次 Tab)仍能实现 6.4 倍的速度优势。

如何使用?支持本地部署与二次开发

Instinct是基于Qwen2.5-Coder-7B,在我们包含现实世界代码编辑的数据集上进行了稳健的微调模型,可在消费级显卡上运行,适合本地集成。

当前可用资源:

- Hugging Face 模型卡:https://huggingface.co/continuedev/instinct

- GitHub 开源仓库:https://github.com/continuedev/instinct (包含训练流水线、数据处理脚本与推理示例)

- 数据集公开:包含原始编辑轨迹与多语言合成样本

- 支持 KTO 微调:开发者可用自己的 accept/reject 数据进一步优化模型

💡 提示:虽然可在笔记本运行,但建议配备至少 16GB 显存以获得流畅体验。

相关文章