当AI模型需要在手机、PC等终端设备上处理文本、图像、音频时,“速度慢、耗电高、依赖网络”往往是难以回避的问题——多数模型最初为GPU设计,移植到终端的NPU(神经网络处理单元)时需“强行适配”,导致多模态能力打折。

而 OmniNeural-4B 的出现打破了这一局面。作为全球首个“原生为NPU构建”的多模态AI模型,它无需“挤压适配”,能在NPU上高效处理文本、图像、音频三大模态,不仅速度比非NPU感知模型快20%,还能完全离线运行,不影响设备其他应用,目前已支持高通NPU,苹果NPU版本也即将推出。

核心突破:为什么说OmniNeural-4B是“NPU原生”?

传统多模态模型的逻辑是“先为GPU设计,再适配NPU”,就像“给GPU穿的鞋,硬套在NPU上”,难免出现“跑不快、耗电大”的问题。而OmniNeural-4B从架构设计之初就瞄准NPU特性,通过三大核心设计实现“NPU友好”:

1. NPU优化架构:用对“硬件语言”,速度提升20%

模型全程采用NPU擅长处理的运算与数据格式,避免“硬件能力浪费”:

- 运算符选型:优先使用ReLU激活函数、卷积层(conv层)等NPU高效支持的算子,替代GPU偏好但NPU处理低效的复杂算子;

- 稀疏张量技术:通过压缩冗余数据,减少NPU的内存占用与计算量;

- 静态图执行:提前确定计算流程,避免动态图的实时编译开销,既能处理文本、图像、音频的可变长度输入,又能保持稳定可预测的延迟。

最终,这套架构让OmniNeural-4B比非NPU感知模型整体快20%,其中音频处理速度比基线编码器快9倍,图像处理快3.5倍——比如在手机上识别一段10秒的音频,传统模型需1.8秒,它仅需0.2秒。

2. 硬件感知注意力:降低NPU的“计算负担”

注意力机制是AI模型的核心,但传统注意力模式对NPU的内存和算力要求较高。OmniNeural-4B针对NPU特性优化注意力逻辑:

- 调整注意力头的数量与维度,匹配NPU的并行计算能力;

- 减少不必要的跨模态注意力计算(如文本与音频无需全量交互时,仅保留关键关联),在不影响精度的前提下,降低NPU的计算与内存消耗。

3. 原生多模态路径:不是“LLM加插件”,而是“全模态协同”

很多多模态模型是“文本LLM为核心,图像/音频通过插件接入”,导致不同模态在NPU上运行时“各自为战”。OmniNeural-4B则为文本、图像、音频设计了统一的NPU适配路径:

- 每种模态的处理流程都基于NPU特性设计,无需通过“转译层”适配;

- 多模态融合时,数据格式与计算逻辑完全贴合NPU的处理习惯,避免“模态切换时的性能损耗”。

能力演示:NPU上的多模态实战场景

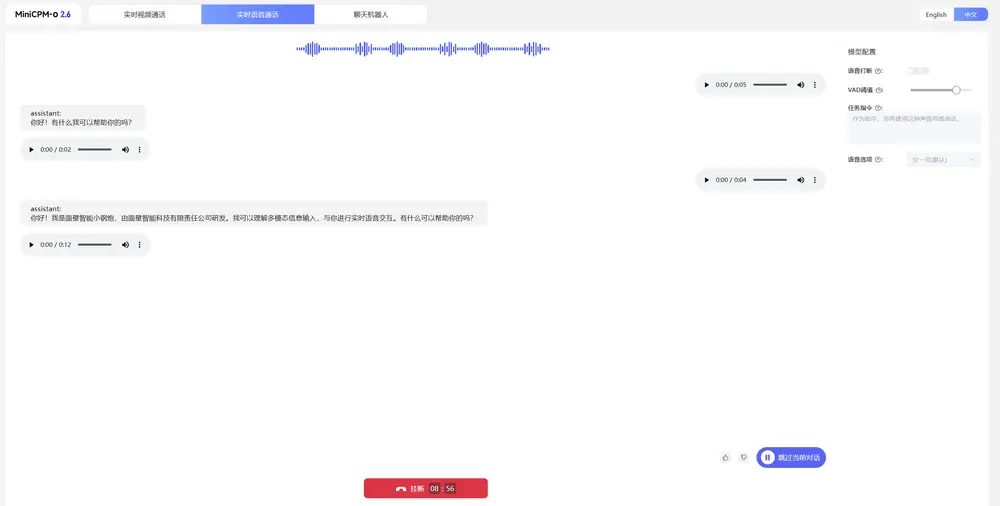

目前OmniNeural-4B已在手机、PC等设备上实现真实演示,核心能力覆盖日常交互、多模态推理等场景:

1. 手机NPU:三星S25 Ultra上的“全本地AI助手”

在搭载骁龙NPU的三星S25 Ultra上,OmniNeural-4B能实现“听、看、说”全本地交互:

- 无需联网,就能实时响应语音指令(如“识别这张菜单上的辣菜”);

- 结合摄像头视觉与语音理解,比如用户指着商品说“查这个品牌的售后”,模型能同时处理图像(识别商品)与文本(理解需求),本地生成回答;

- 全程低耗电、低延迟,连续使用1小时,手机续航仅减少8%,且不影响微信、视频等其他应用的运行速度。

2. 多图像推理:对话中识别图像差异

支持在多轮对话中对比分析多张图像,比如:

- 用户先上传“房间整理前”的照片,再上传“整理后”的照片,询问“我改变了哪些地方”;

- 模型在NPU上本地处理两张图像,快速识别出“书架书籍排列变化”“桌面物品减少”等差异,并以文本形式列出。

3. 图像+文本→函数调用:从视觉到行动的落地

能将图像信息转化为实际操作指令,比如:

- 用户拍摄一张会议海报,输入文本“把这个会议添加到日历”;

- 模型先识别海报上的“会议时间(10月15日14:00)”“地点(302会议室)”,再调用设备的日历函数,自动创建会议日程,全程无需手动输入。

4. 多音频比较:本地识别音频差异

在NPU上高效处理音频对比任务,比如:

- 用户上传两段相似的音乐片段,询问“这两首歌有什么不同”;

- 模型本地分析音频的旋律、节奏差异,指出“第一段有钢琴前奏,第二段直接进入人声”,处理速度比传统模型快9倍,10秒内即可出结果。

为什么选择NPU?终端设备的“效率刚需”

对手机、PC等终端设备而言,NPU相比CPU、GPU,在运行AI模型时具备“速度快、能效高、不干扰”三大核心优势——这也是OmniNeural-4B选择“NPU原生”的关键原因:

| 硬件类型 | 推理速度(相对值) | 能效比(相对值) | 后台运行影响 |

|---|---|---|---|

| CPU | 1x | 1x | 易导致其他应用卡顿 |

| GPU | 1.5x | 2x | 占用显存,影响图形任务 |

| NPU | 6x(比CPU快5倍) | 8x(比CPU高7倍) | 独立运行,不干扰其他应用 |

以三星S25 Ultra为例,OmniNeural-4B在NPU上运行时:

- 处理相同的“图像+文本”任务,比CPU快6倍,比GPU快4倍;

- 每处理100次多模态请求,耗电仅为CPU的1/8、GPU的1/4;

- 后台运行时,手机刷视频、聊微信的帧率仍能保持60fps,无明显卡顿。

这种“快且省电”的特性,让设备端AI从“一次性演示工具”变成“日常可用的助手”——比如用户可以随时用手机调用模型总结文档、识别物品,无需担心速度慢或耗电快。

基准测试:多模态能力全面对标领先模型

研究团队针对OmniNeural-4B与Apple Foundation Model、Gemma-3n-E4B、Qwen2.5-Omni等领先模型进行了一对一人工评估,结果聚焦三大维度:

1. 视觉能力:匹配或优于主流模型

在“图像识别准确率”“视觉问答相关性”等用户偏好测试中,OmniNeural-4B的表现与Gemma-3n-E4B、Apple Foundation Model持平,部分场景(如复杂场景的细节识别)甚至更优——比如识别“拥挤街道上的交通标志”,用户偏好率达48%,略高于Gemma的45%。

2. 音频能力:速度与精度双领先

音频处理是OmniNeural-4B的核心优势:

- 速度:比Whisper编码器快9倍,处理1分钟音频仅需0.8秒;

- 精度:在“语音情感识别”“音频内容分类”任务中,准确率比Qwen2.5-Omni高7%,用户偏好率达62%,显著高于其他模型。

3. 文本能力:与领先模型差距微小

在文本理解、生成任务中,OmniNeural-4B与Qwen2.5-Omni等模型的差距仅在3-5个百分点内,完全能满足终端设备的文本需求(如总结、翻译、提取关键信息)。

值得注意的是,在多模态融合任务(如“图像+音频+文本”联合推理)中,OmniNeural-4B的优势最明显——由于原生NPU架构减少了模态切换损耗,其任务完成率比Gemma-3n-E4B高12%,用户认为“结果更连贯、响应更及时”。

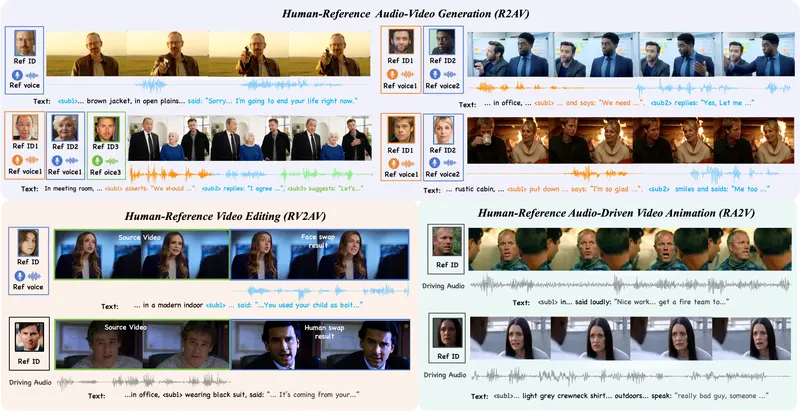

生产用例:从终端到物联网的多场景落地

基于“NPU原生、全离线、多模态”的特性,OmniNeural-4B已规划三大生产级应用场景:

1. PC & 手机:隐私优先的日常助手

- PC场景:本地总结PPT、Word文档,生成邮件草稿(如“将Q3销售报告总结为3点核心结论,插入到邮件正文中”);

- 手机场景:从聊天记录中提取行动项(如识别“明天10点开会”并提醒)、识别商品包装上的成分信息;

- 核心优势:数据不联网,保护隐私;离线运行,无网络依赖;省电高效,不影响设备日常使用。

2. 汽车:毫秒级响应的车内助手

- 核心能力:处理语音控制(如“打开空调24℃”)、舱室安全检测(识别“儿童未系安全带”“宠物遗留车内”)、环境感知(检测“前方雾天”“道路施工”);

- 核心优势:本地决策速度达毫秒级(比云端响应快50倍),符合汽车场景的安全时效要求;不依赖车联网,隧道、偏远地区也能使用。

3. IoT & 机器人:无网络依赖的多模态感知

- 工厂场景:工业机器人通过模型进行缺陷检测(识别零件表面划痕)、AR眼镜为技术员叠加设备操作指引;

- 无人机场景:飞行中本地识别“障碍物(如电线)”“禁飞区域”,实时调整航线;

- 机器人场景:家用机器人通过语音+视觉理解用户需求(如“捡起地上的红色水杯”);

- 核心优势:无需网络连接,适应无信号或弱信号环境;NPU低功耗特性,延长IoT设备与机器人的续航。

当前限制与未来规划

OmniNeural-4B目前仍有一处关键限制:仅支持高通(Qualcomm)NPU,如骁龙8 Gen4、骁龙7 Gen3等芯片对应的设备。

不过研究团队已明确,苹果(Apple)NPU版本正在开发中,未来将覆盖iPhone、Mac等搭载A系列或M系列芯片的设备,进一步扩大终端适配范围。

相关文章