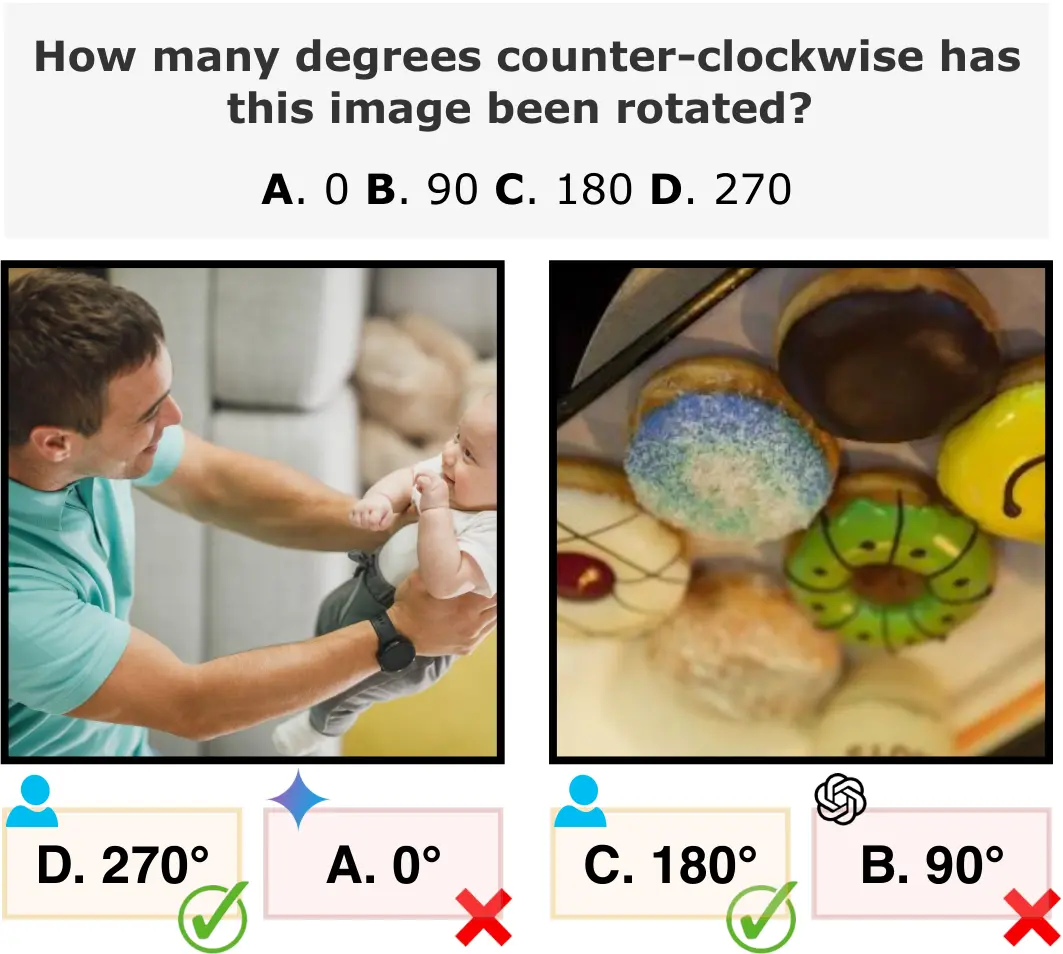

北卡罗来纳大学教堂山分校的研究团队,针对多模态大语言模型(MLLMs)的空间视觉推理能力展开专项测试——聚焦“图像旋转角度识别”任务(判断图像是否旋转0°、90°、180°、270°)。

研究发现,即便GPT-5、Gemini-2.5-Pro等最先进的MLLMs,也难以可靠区分90°与270°旋转的图像,且辅助信息、提示优化对性能提升有限,揭示出MLLMs空间推理能力与人类感知间的显著差距。

研究核心:为什么要测试“图像旋转识别”?

图像旋转角度判断看似简单,实则需要模型具备两大关键能力:

- 提取旋转线索:识别图像中的空间特征(如物体朝向、地平线位置、文字方向),判断是否存在旋转;

- 建立空间上下文:无论图像方向如何,都能理解物体间的相对位置关系(如“杯子在桌子上”而非“桌子在杯子上”)。

这项任务的核心价值,在于评估MLLMs的“视觉-语义关联能力” ——多模态模型不仅要“看见”图像,更要通过空间推理理解图像含义,而旋转识别正是检验这一能力的经典场景。

测试基础:RotBench基准数据集

为避免测试图像的随机性影响结果,研究团队手动构建了专属基准数据集RotBench,确保测试的标准化与公平性:

- 规模与筛选:包含350张手动筛选的图像,剔除模糊、无明显空间特征的内容;

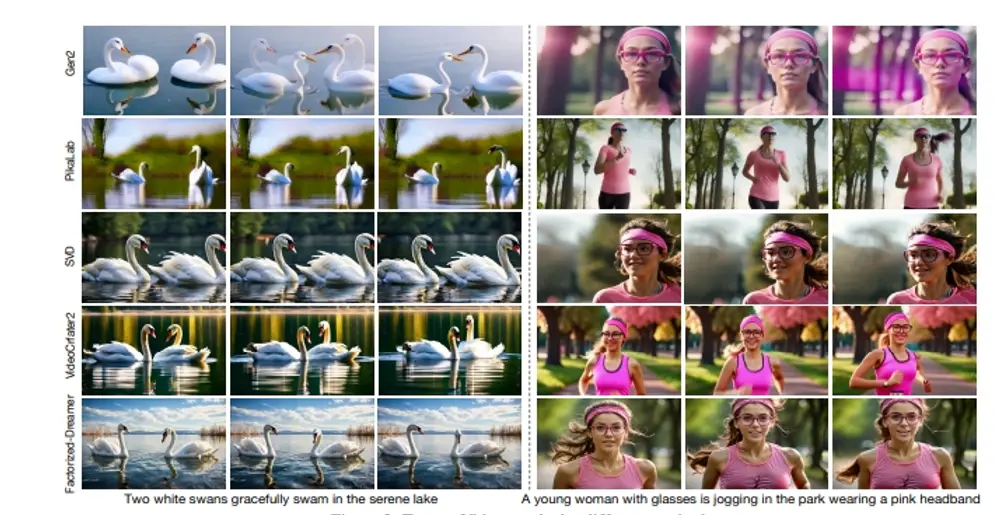

- 图像类型:覆盖三大场景——生活方式(如餐桌布置、家电使用)、肖像(人物正面/侧面照)、风景(如山脉、海岸线),确保模型面对不同场景时均能被有效测试;

- 旋转处理:每张图像均被逆时针旋转0°(正立)、90°、180°(倒立)、270°四个角度,以多项选择题形式呈现给模型,要求模型选出正确的旋转角度。

测试方案:模型选择与评估逻辑

1. 测试模型范围

涵盖当前主流开源与专有MLLMs,确保结果的代表性:

- 专有模型:GPT-5、GPT-4o、o3、Gemini-2.5-Pro、Gemini-2.0-Flash等;

- 开源模型:Llama-3.2-11B-Vision、Qwen2.5-VL-7B-Instruct、Qwen2.5-VL-32B-Instruct等。

2. 技术配置

测试通过VLLM服务器部署,不同模型对应固定本地端口,确保运行环境一致,具体配置如下:

| 模型名称 | 服务器端口 | 代码库别名 |

|---|---|---|

| Qwen3-8B | 7471 | - |

| Qwen2.5-VL-7B-Instruct | 7472 | Qwen7 |

| Llama-3.2-11B-Vision | 7473 | Llama11 |

| Qwen2.5-VL-32B-Instruct | - | Qwen32 |

| GPT-4o | - | GPT4o |

| GPT-4.1 | - | GPT41 |

| GPT-5 | - | GPT5 |

| o3 | - | o3 |

| Gemini-2.0-Flash | - | Gemini2 |

| Gemini-2.5-Flash | - | Gemini25 |

| Gemini-2.5-Pro | - | Gemini25pro |

3. 评估维度

除基础的“角度识别准确率”外,研究还额外测试了三类优化方案的效果:

- 辅助信息添加:向模型提供图像标题(如“客厅沙发场景”)、深度图(展示物体前后层次)、边界框(标记关键物体位置);

- 提示方法优化:使用“链式思维提示”(如“先看人物朝向,再判断地平线位置,最后确定旋转角度”);

- 特殊测试设置:①展示同一图像的所有旋转角度,让模型通过“投票”选最优结果;②对部分模型进行微调,观察性能变化。

关键结果:MLLMs的“空间推理短板”显著

1. 角度识别能力分化明显

所有模型的表现呈现“两极分化”,对不同旋转角度的识别能力差异巨大:

- 0°(正立)图像:大多数模型准确率接近100%,能可靠识别未旋转的正立图像;

- 180°(倒立)图像:部分模型(如GPT-5、Gemini-2.5-Pro)准确率可达70%以上,能通过“物体倒置”(如人物头朝下)判断旋转;

- 90°与270°图像:无任何模型能可靠区分——两类角度的识别准确率普遍低于50%,接近随机猜测水平,成为所有模型的共同短板。

2. 优化方案效果有限

各类提升手段仅带来微小且不稳定的改进,无法解决核心问题:

- 辅助信息:添加标题、深度图等信息后,模型准确率最高仅提升8%,且部分场景下(如风景图像)反而因信息冗余导致准确率下降;

- 链式思维提示:仅对Llama-3.2等开源模型有轻微提升(约5%),对GPT-5、Gemini-2.5-Pro等顶级模型基本无效;

- 特殊设置:①“多角度投票”仅能让较弱模型(如Qwen2.5-VL-7B)准确率提升10%,对强模型无帮助;②“微调”虽能将180°图像识别准确率提升至85%,但对90°/270°区分能力无任何改善。

研究结论:MLLMs与人类空间感知存在代差

此次研究的核心发现,在于揭示了MLLMs空间推理能力的局限性:

人类可通过日常空间经验(如“门通常是垂直的”“文字不会横向排列”)轻松区分90°与270°旋转,但MLLMs无法建立这种“视觉-常识”的关联——它们更擅长识别“是否旋转”(如0°vs180°),却难以判断“旋转方向”(如90°vs270°)。

这一结果为后续MLLM优化提供了明确方向:未来需重点强化模型的“空间常识融入”与“多角度特征关联”能力,才能缩小其与人类空间感知的差距。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...