随着图像生成模型(如Stable Diffusion、Flux等)在质量和可控性上的飞速进步,其潜在风险也日益凸显:

- 生成裸露或暴力内容

- 模仿特定艺术家风格引发版权争议

- 复现受保护的商标或人物形象

现有安全机制多依赖推理时过滤或后处理检测,但当用户拥有模型权重时,这些方法极易被绕过。真正的安全,必须从“源头”入手。

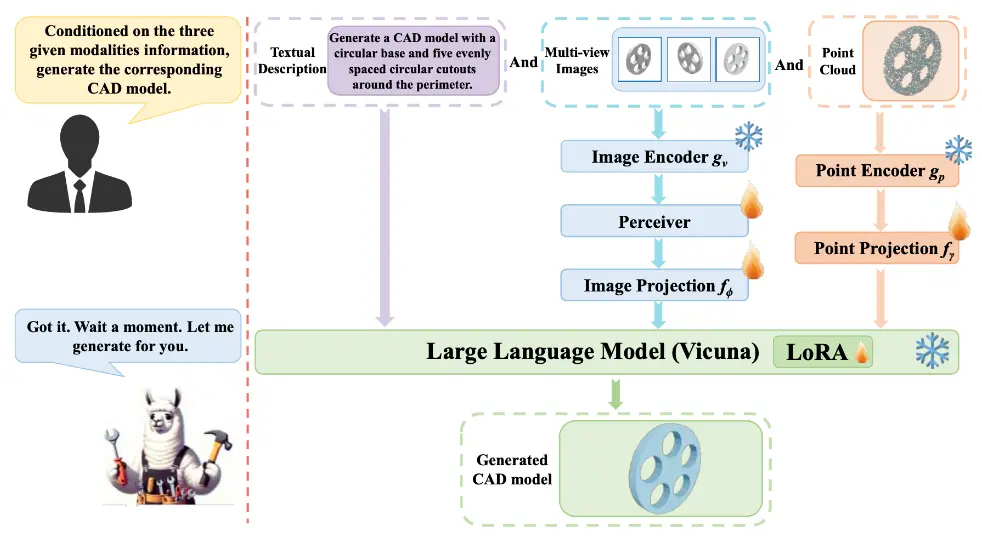

东北大学与麻省理工学院的研究团队提出一种新方法——Erasing(简称ESD),通过微调模型权重,直接从扩散模型中“擦除”特定视觉概念。该方法无需额外训练数据,仅凭一段文本描述即可实现永久性概念移除,且难以被规避。

为什么需要“擦除”视觉概念?

大型扩散模型是在海量互联网数据上训练而成的“视觉百科全书”。它们能生成精美图像,也能复现训练集中存在的敏感内容。

这带来了三类核心问题:

| 风险类型 | 具体表现 | 社会影响 |

|---|---|---|

| 安全风险 | 生成深度伪造色情内容、暴力图像 | 侵犯隐私、助长网络骚扰 |

| 版权争议 | 模仿特定艺术家风格(如Greg Rutkowski) | 艺术家集体诉讼,行业信任危机 |

| 法律合规 | 生成受版权或商标保护的形象(如米老鼠) | 企业发布模型面临法律障碍 |

尽管已有“安全潜扩散”(SLS)、负面提示引导等缓解手段,但这些方法均作用于推理阶段,用户只需移除过滤模块或修改提示词即可绕过。

真正的解决方案,必须写进模型本身。

核心思路:用模型的知识,让它学会“遗忘”

Erasing 方法的核心思想简洁而深刻:

既然模型能生成某个概念,那它就“知道”这个概念——我们可以利用这种知识,反过来教会它“不再生成”。

传统概念移除方法通常需要:

- 收集大量目标概念图像

- 在清洗后的数据集上重新训练整个模型

成本高、效率低、难以部署。

而 ESD 完全不同:

✅ 无需额外数据:仅使用预训练模型自身的生成能力;

✅ 仅需微调:不重新训练,大幅降低计算开销;

✅ 永久生效:直接修改权重,无法通过推理策略绕过。

技术实现:通过反向引导重塑生成分布

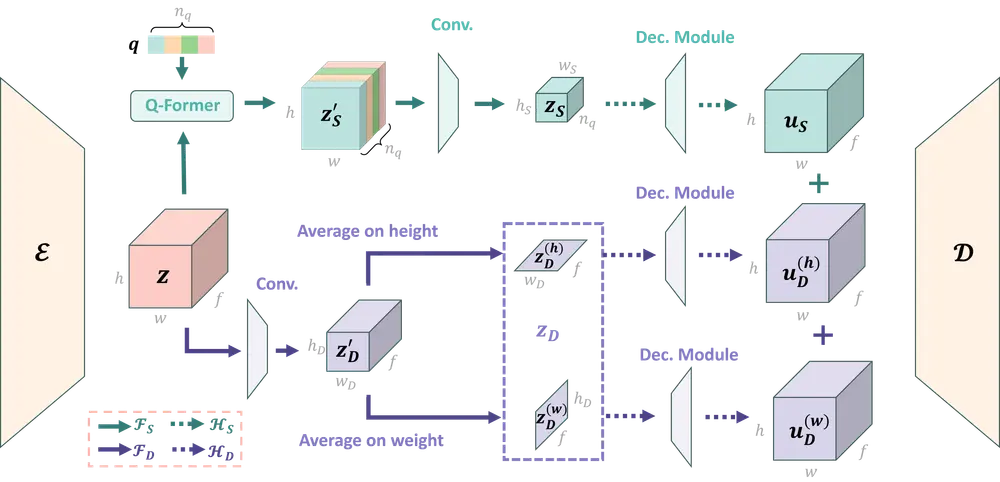

ESD 的核心机制是对抗性微调:

- 冻结原始模型,作为“教师”;

- 给定要擦除的概念(如“nudity”或“in the style of Van Gogh”),用该提示生成噪声预测;

- 训练新模型在相同条件下,向相反方向预测噪声;

- 重复迭代,逐步削弱该概念在生成过程中的影响力。

这一过程类似于“反向分类器引导”(classifier-free guidance),但应用于训练阶段而非推理阶段。

最终,模型学会在面对相关提示时主动抑制该概念的出现,实现概念级遗忘。

编辑哪些权重?两种策略适应不同场景

研究团队提出了两种微调策略,分别针对不同类型的擦除需求:

1. ESD-x:仅微调交叉注意力层

- 仅修改文本-图像对齐相关的交叉注意力模块

- 效果:仅当提示中明确提及某概念时才触发擦除

- 适用场景:艺术风格控制(如“不再生成毕加索风格”,但保留其他风格)

✅ 精细控制,干扰小

❌ 若提示绕开关键词,仍可能生成

2. ESD-u:微调无条件层(除交叉注意力外)

- 修改自注意力、前馈网络等与文本无关的模块

- 效果:无论提示如何,模型都难以生成目标概念

- 适用场景:敏感内容过滤(如裸露、暴力),即使提示隐晦也能有效拦截

✅ 泛化性强,安全性高

❌ 可能影响相关语义(如擦除“裸露”可能影响“游泳”场景)

实验验证:在多个任务上优于现有方法

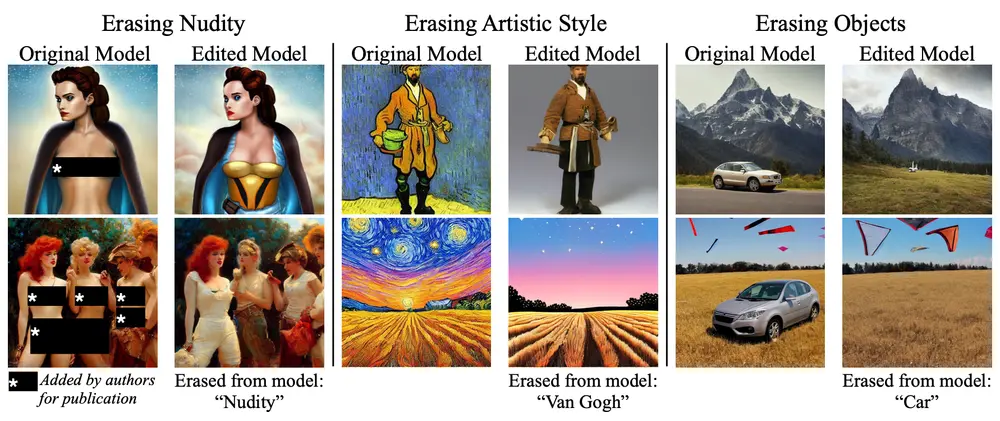

1. 艺术风格擦除

- 使用用户研究评估:相比负面提示、SLS等方法,ESD 在保留图像质量的同时,更彻底地去除了目标风格;

- 干扰测试显示,对其他未指定风格的影响极小。

2. 裸露内容过滤

- 对比 Stable Diffusion v2.0/v2.1(内置审查)、SLS(推理过滤):

- ESD-u 擦除成功率更高

- 在模糊提示(如“沙滩上的人”)下仍能有效拦截不当内容

- 微调仅需数小时,在单卡A100上即可完成

3. 物体类别擦除

- 成功从模型中移除“猫”“汽车”等类别

- 但发现:擦除大型语义类别时,可能对相关概念产生连带影响(如擦除“猫”影响“宠物”生成)

主要优势总结

| 特性 | 说明 |

|---|---|

| 永久性 | 直接修改模型权重,发布后也无法轻易恢复 |

| 抗绕过 | 不依赖推理时过滤,用户无法通过修改提示规避 |

| 高效性 | 仅需微调,无需重新训练整个模型 |

| 无数据依赖 | 利用模型自身知识,无需收集额外图像 |

| 灵活部署 | 可选择局部(ESD-x)或全局(ESD-u)擦除策略 |

局限与挑战

尽管 ESD 表现出色,但仍存在一些限制:

- 权衡擦除强度与干扰:完全擦除复杂概念(如“裸露”)可能导致语义邻近内容受损;

- 多义词处理困难:某些词在不同语境下含义不同(如“nude”可指肤色或裸体);

- 长期记忆问题:目前尚不清楚擦除效果是否在持续微调或任务迁移中保持稳定。

意义与展望

ESD 提供了一种从模型内部实现内容治理的新范式。它不是简单的“黑名单”,而是一种可编程的内容控制机制。

对于模型发布者而言,这意味着:

- 可在开源前主动移除高风险概念;

- 满足不同地区的内容合规要求;

- 减少版权纠纷风险,提升商业可用性。

未来,这类“可编辑性”技术或将与模型训练流程深度集成,形成“生成-审查-编辑”一体化的负责任AI开发框架。

相关文章