在跨语言实时沟通的长期挑战中,机器能否真正替代人类同声传译?字节跳动 Seed 团队给出了迄今为止最接近“是”的答案。

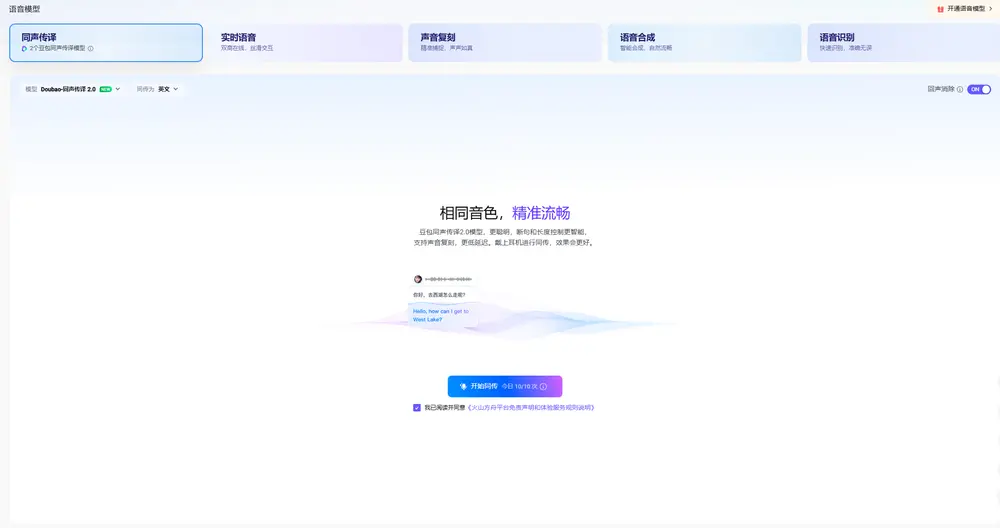

今日,字节跳动正式发布 Seed LiveInterpret 2.0 —— 一款端到端语音到语音同声传译模型,首次在翻译准确率与延迟表现上接近专业人类同传水平,并已具备产品级落地能力。

- 项目主页:https://seed.bytedance.com/zh/seed_liveinterpret

- API:https://console.volcengine.com/ark/region:ark+cn-beijing/experience/voice?type=SI

该模型支持中英互译,采用全双工“边听边说”架构,可在多人会议、演讲、对话等复杂场景下,实现低至 2–3 秒的语音到语音延迟,同时支持零样本声音复刻,让翻译输出听起来“像你自己在说外语”。

核心能力:像人类一样“边听边译”

传统机器同传系统通常采用“先听完整句,再翻译输出”的串行模式,导致延迟高、节奏僵硬。而 Seed LiveInterpret 2.0 借鉴人类同传工作方式,构建了全双工端到端语音生成理解框架:

- 实时接收源语言语音输入;

- 边理解、边生成目标语言语音;

- 无需等待完整语义结束即可开始翻译。

这意味着,当发言人讲出第一句话的前几个词时,系统已在准备输出对应的翻译语音,实现真正意义上的“同声”传译。

✅ 实测表现:面对长达 40 秒的中文演讲片段,系统可丝滑输出英语翻译,延迟稳定在 2–3 秒,流畅度接近人类译员。

技术突破:三大核心优势

1. 接近真人水平的翻译准确率

在多轮测试中,Seed LiveInterpret 2.0 展现出卓越的语义理解与翻译能力:

| 场景 | 翻译准确率(人类评分,满分100) |

|---|---|

| 多人会议(中英互译) | >70 分 |

| 单人演讲(中英互译) | >80 分 |

在语音到文本同传任务中,其平均得分为 74.8 分,较第二名基准系统(47.3 分)高出 58%。

💡 评估维度包括:语义完整性、术语准确性、文化适配性(如诗词、绕口令、饮食文化等)。

2. 超低延迟:2–3 秒实现“边听边说”

相比传统系统动辄 5–10 秒的延迟,Seed LiveInterpret 2.0 将语音到语音延迟压缩至:

- 语音→文本:首字输出平均延迟 2.21 秒

- 语音→语音:完整输出延迟 2.53 秒

这一表现较传统机器同传降低超 60%,已达到高水平人类同传的响应节奏。

⚙️ 技术支撑:全双工建模 + 动态语义切分 + 流式解码策略,确保在不牺牲质量的前提下最小化延迟。

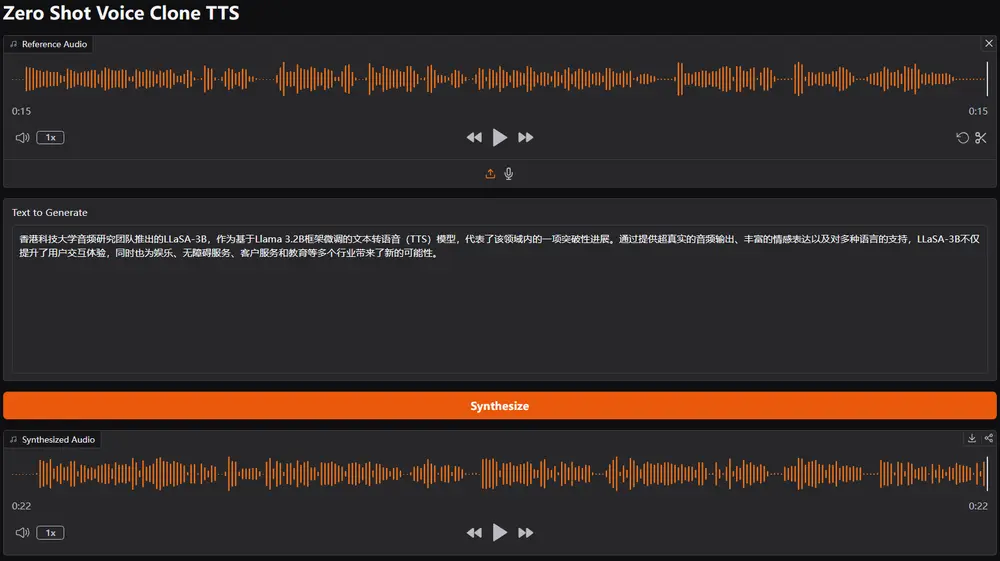

3. 零样本声音复刻:用你的声音“说外语”

这是 Seed LiveInterpret 2.0 最具突破性的功能之一。

无需预先训练或长时间录音,系统仅需实时采集几秒语音信号,即可提取说话人音色特征,并用该音色生成目标语言的翻译语音。

✅ 优势:

- 避免“机器人音”带来的疏离感;

- 在多人对话中清晰区分不同说话人身份;

- 提升跨语言沟通的亲和力与沉浸感。

该功能已在多人会议、访谈等场景中验证有效。

模型测评:全面领先现有系统

在语音到语音同传任务中,目前全球仅有 3 个系统具备类似能力。其中,Seed LiveInterpret 2.0 综合表现最优:

| 指标 | Seed LiveInterpret 2.0 |

|---|---|

| 语音到语音翻译质量(人类评分) | 66.3 分(满分100) |

| 支持声音复刻 | ✅ 是 |

| 支持中英互译 | ✅ 是 |

| 支持多人语音输入 | ✅ 是 |

📌 注:其他系统普遍缺乏声音复刻能力,且延迟更高、流畅度不足。

🛠️ 智能节奏控制:适应复杂语言场景

为应对非流利语音、长句、口音等问题,模型内置动态节奏调节机制:

- 根据语音清晰度、语速、语法复杂度自动调整输出节奏;

- 在信息密集段落保持紧凑输出,在停顿或思考时适当放缓;

- 即使面对超长语段,也能保证翻译语音自然流畅,不卡顿、不抢话。

这一能力使其在真实会议、讲座等高要求场景中更具实用性。

相关文章