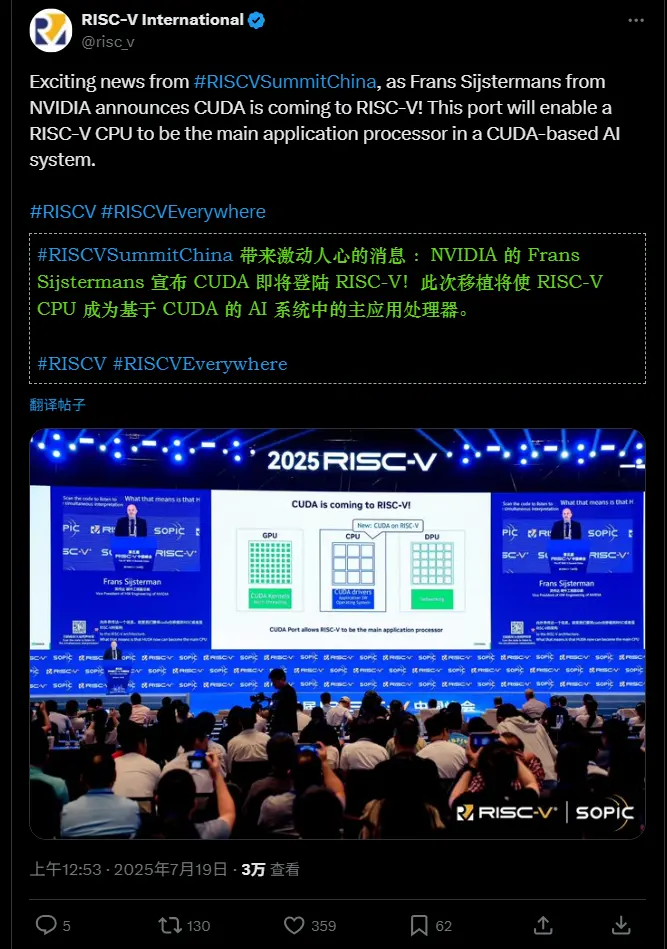

在2025年中国RISC-V峰会期间,一条看似低调却极具战略意义的消息悄然发布:

这意味着,RISC-V 处理器未来可作为运行 CUDA 应用的主控 CPU,与传统的 x86 和 Arm 架构并列,成为 AI 与高性能计算(HPC)系统中的合法“指挥者”。

这一决定,不仅是技术兼容性的扩展,更可能是英伟达在全球地缘与技术变局下的一次深远布局。

RISC-V 能做什么?协调 GPU 计算

根据英伟达硬件工程副总裁 Frans Sijsterman 在峰会主题演讲中的说明,RISC-V CPU 并不直接执行 AI 计算任务,而是承担系统级协调角色:

✅ 运行操作系统

✅ 执行应用程序逻辑

✅ 驱动 CUDA 运行时环境

✅ 向 GPU 下发并管理计算任务

换句话说:GPU 负责“算”,RISC-V CPU 负责“管”。

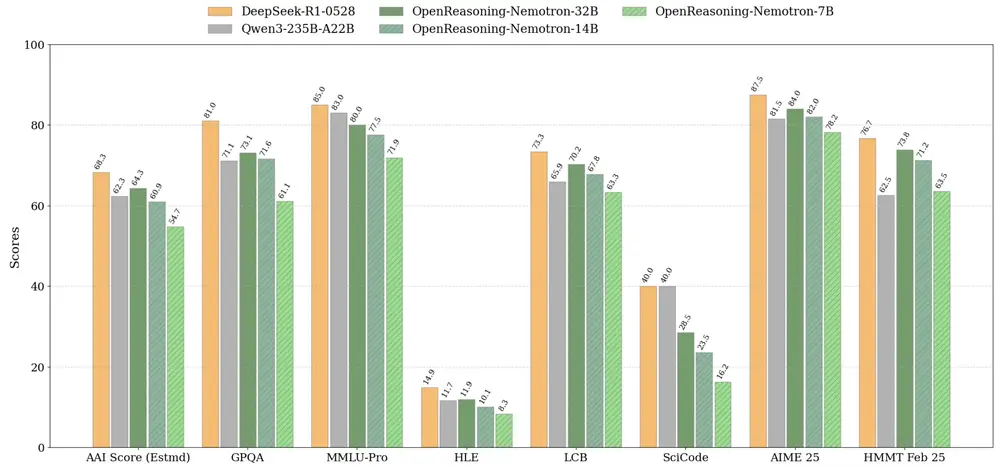

现场展示的架构图清晰呈现了这一异构系统模型:

- GPU:处理并行计算(如深度学习推理)

- RISC-V CPU:作为主机处理器,调度任务与资源

- DPU(数据处理器):负责网络通信与数据搬运

这套“三芯协同”架构,正是英伟达对未来边缘与数据中心系统的设想。

为何现在支持 RISC-V?

虽然 RISC-V 目前尚未具备挑战 x86 或高端 Arm 的能力,但英伟达的这一步棋,背后有多重动因:

1. 应对地缘限制,维持 CUDA 生态扩张

由于美国出口管制,英伟达无法向中国市场交付其最先进的 GB200、GB300 等 AI 芯片。

要维持在中国市场的影响力,就必须让 CUDA 生态 继续落地。

而 RISC-V 作为中国重点发展的开源指令集,已成为本土芯片设计的主流选择。

通过支持 RISC-V,英伟达实际上在说:

“即使你不能用我的旗舰 GPU,只要运行 RISC-V + CUDA,依然可以接入我们的 AI 软件栈。”

2. 拓展 Jetson 边缘计算生态

对于 NVIDIA Jetson 这类嵌入式 AI 模块而言,RISC-V 提供了更高的定制灵活性。

开发者可以基于 RISC-V 设计专用 SoC,集成传感器控制、低功耗协处理器等功能,同时仍能通过 RISC-V 主核调用 Jetson 的 GPU 能力。

这为机器人、工业自动化、智能终端等场景提供了更多系统设计自由度。

3. 推动异构计算的开放化

英伟达正从“硬件公司”转向“平台公司”。

其目标不再是卖 GPU,而是推广 以 GPU 为核心的异构计算平台。

支持 RISC-V,意味着这个平台不再绑定特定 CPU 架构,而是向更多定制化、专用化系统开放——无论是数据中心,还是边缘设备。

现实挑战:RISC-V 还需跨越性能门槛

尽管前景广阔,但 RISC-V 要真正承担“CUDA 主机 CPU”的角色,仍面临挑战:

- 当前多数 RISC-V 核心性能有限,难以胜任复杂任务调度

- 缺乏成熟的系统级软件支持(如完整 Linux 发行版、调试工具链)

- 生态碎片化,不同厂商实现差异大

因此短期内,RISC-V 更可能出现在:

- 特定行业定制设备

- 教学与研究平台

- 国产化替代项目

而非主流超大规模数据中心。

长远影响:可能改变AI计算格局

如果 RISC-V 在性能与生态上持续进步,英伟达此举可能带来连锁反应:

- 其他 GPU 厂商(如 AMD、Intel)或将跟进支持

- 更多国产 AI 芯片可借助 CUDA 兼容性加速落地

- 开源指令集 + 专有加速栈的组合,或成新范式

更重要的是,它释放出一个信号:

英伟达愿意将其封闭但强大的 CUDA 生态,部分向开放架构敞开大门。

这或许是其应对全球技术割裂的一种务实策略。

相关文章