香港中文大学(深圳)和华南理工大学的研究人员推出推出一个名为FusionAudio-1.2M的音频描述数据集,通过多模态上下文融合来生成细粒度的音频描述。该数据集通过模拟人类听觉感知的方式,整合了多种模态信息(如语音、音乐、一般声音和视觉信息),以生成详细且上下文准确的音频描述。这种方法不仅提高了音频描述的质量,还为音频理解任务提供了更丰富的语义信息。

- GitHub:https://github.com/FreedomIntelligence/FusionAudio

- 模型:https://huggingface.co/SatsukiVie/FusionAudio

- 数据集:https://huggingface.co/datasets/SatsukiVie/FusionAudio

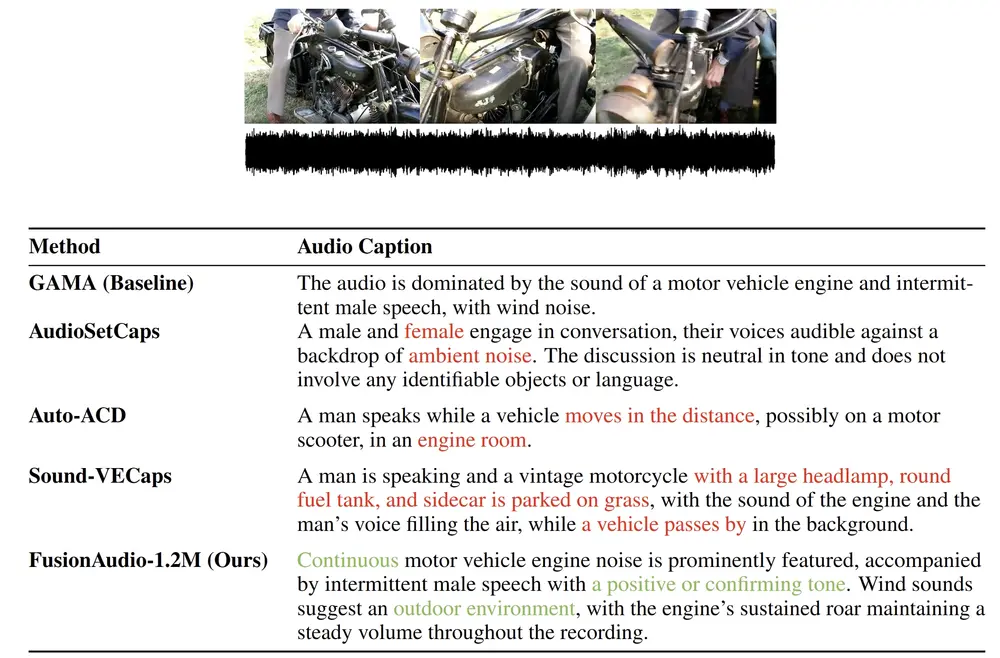

例如,对于一段包含背景音乐、对话和环境声音的音频片段,传统方法可能只能生成简单的描述,如“背景音乐和对话”。而FusionAudio-1.2M通过整合多模态信息,能够生成更详细的描述,如“一段对话在轻快的背景音乐中进行,背景中可以听到轻微的风声,表明这是一个户外场景”。

主要功能

- 细粒度音频描述生成:通过多模态信息融合,生成详细且上下文准确的音频描述。

- 大规模数据集构建:构建了一个包含120万条音频描述的大型数据集,支持音频理解任务。

- 多模态模型增强:利用FusionAudio-1.2M数据集,开发了更强大的音频模型,如基于CLAP的音频编码器,提升了音频-文本对齐和指令遵循能力。

主要特点

- 多模态上下文融合:整合语音、音乐、一般声音和视觉信息,生成更丰富的音频描述。

- 大规模高质量数据集:FusionAudio-1.2M是目前最大的音频描述数据集之一,提供了丰富的细粒度描述和问答对。

- 自动化生成流程:通过预训练模型提取多模态信息,并由大型语言模型(LLM)合成最终描述,实现了高效的数据生成。

工作原理

- 多模态信息提取:使用专门的预训练模型提取音频中的语音、音乐、一般声音和视频中的视觉信息。

- 大型语言模型合成:将提取的多模态信息输入到大型语言模型(LLM)中,通过自然语言生成技术合成详细的音频描述。

- 数据质量保证:通过人工评估和自动过滤机制,确保生成的音频描述的质量和准确性。

测试结果

- 音频-文本检索任务:在AudioCaps测试集上,使用FusionAudio-1.2M预训练的模型在文本到音频和音频到文本检索任务中均取得了最佳性能,Recall@1指标分别达到了44.3%和57.8%。

- 音频理解任务:在多个音频理解任务中,使用FusionAudio-1.2M微调的GAMA模型在多个子任务中取得了最高的平均分数,例如在高噪声条件下的音频分类任务中,准确率达到了59.0%。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...