小米正式发布并全量开源其自研声音理解大模型 —— MiDashengLM-7B。该模型在性能与效率上实现双重突破,标志着小米在多模态AI领域,尤其是声音理解方向的又一次重要进展。

- GitHub 主页:https://github.com/xiaomi-research/dasheng-lm

- 技术报告:https://github.com/xiaomi-research/dasheng-lm/tree/main/technical_report

- 模型参数(Hugging Face):https://huggingface.co/mispeech/midashenglm-7b

- 模型参数(魔搭社区):https://modelscope.cn/models/midasheng/midashenglm-7b

- 网页 Demo: https://xiaomi-research.github.io/dasheng-lm

- 交互 Demo:https://huggingface.co/spaces/mispeech/MiDashengLM

作为小米“人车家全生态”战略的核心技术之一,MiDashengLM-7B 不仅在多项指标上刷新纪录,更以完全开放的姿态推动行业技术共享。

性能突破:速度与精度的双重飞跃

根据小米官方介绍,MiDashengLM-7B 在关键性能指标上表现卓越:

- ✅ 首 Token 延迟仅为同类模型的 1/4:单样本推理时,响应速度极快,显著提升交互实时性。

- ✅ 同显存下并发能力提升超 20 倍:更适合高并发服务部署,降低推理成本。

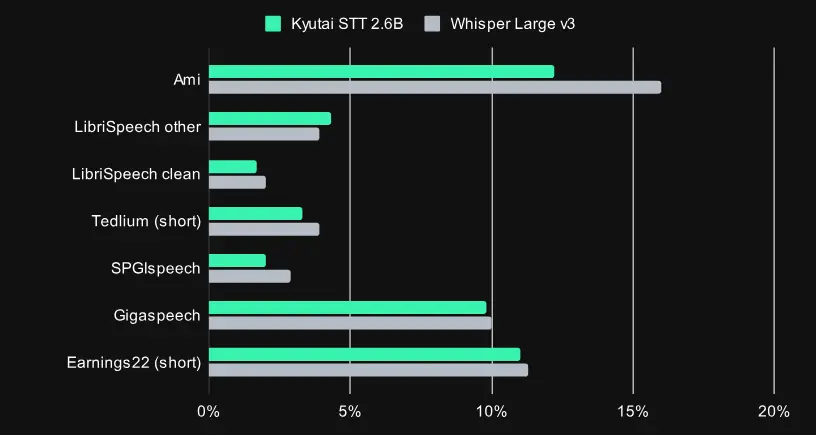

- ✅ 22 个公开评测集刷新 SOTA(State-of-the-Art)记录:在语音、环境声、音乐等多类任务中全面领先,成为当前多模态声音理解领域的最强模型之一。

技术架构:统一理解,跨域融合

MiDashengLM-7B 的核心架构由两部分组成:

- 音频编码器:Xiaomi Dasheng

小米自研的声音基座模型,已在国际权威基准上建立领先优势:- 首个在 AudioSet-50 上突破 mAP 50 的模型

- 在 HEAR Benchmark 的语音、环境声、音乐三大领域均保持领先

- 自回归解码器:Qwen2.5-Omni-7B Thinker

负责生成自然语言响应,实现从“听到”到“理解”再到“表达”的完整闭环。

通过创新的通用音频描述训练策略,模型实现了对三类声音的统一建模:

- 语音(如对话、指令)

- 环境声(如敲门声、玻璃破碎)

- 音乐(如旋律识别、风格判断)

这意味着模型不仅能“听清”,更能“听懂”——理解声音背后的语义与情境。

实际应用:已深度融入小米生态

Xiaomi Dasheng 系列模型已在小米多个产品线中落地超 30 项应用,涵盖智能家居与智能汽车场景:

- 🚗 车外唤醒防御:识别外部模仿唤醒声,防止误触发

- 🏠 全天候异常声音监控:手机/音箱可检测家中烟雾报警、玻璃破碎等危险信号

- ✋ “打个响指”控制 IoT 设备:通过特定环境音触发智能设备联动

- 🚘 小米 YU7 哨兵模式增强:利用划车声检测实现主动安全防护

MiDashengLM 作为其升级版,将进一步提升这些功能的准确性与泛化能力。

完全开放:数据、代码、许可全透明

小米强调,MiDashengLM-7B 是一个真正开放的模型:

- 🔓 训练数据 100% 来自公开数据集

- 📚 完整公开 77 个数据源的详细配比

- 📘 技术报告详述全流程:从音频编码器预训练、多任务学习到指令微调

- 📄 采用 Apache License 2.0 开源协议

支持学术研究与商业应用,无使用限制

这与部分未公开训练细节的闭源模型形成鲜明对比,体现了小米推动技术透明化的决心。

未来方向:向终端与交互延伸

在当前版本基础上,小米已启动下一阶段研发,重点方向包括:

- 终端离线部署:优化计算效率,实现在手机、音箱、汽车等设备上的本地运行

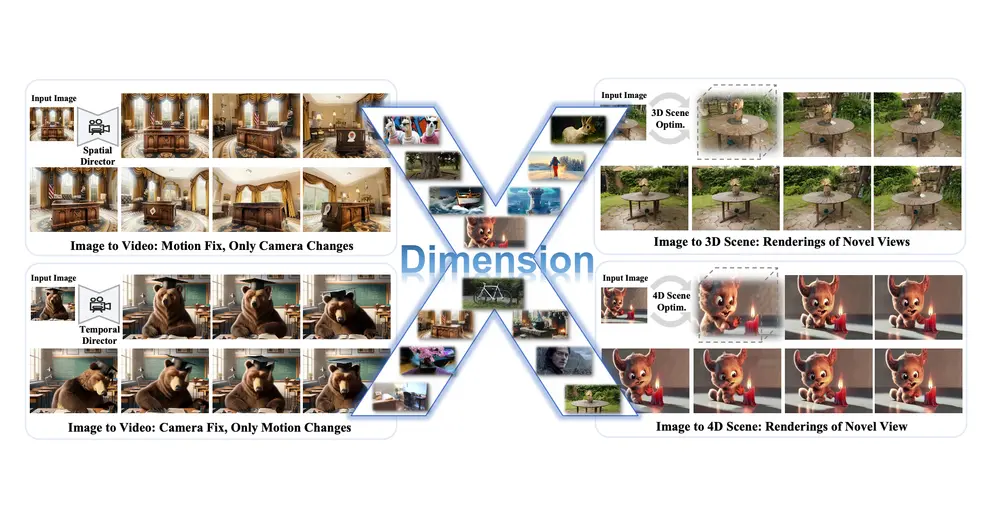

- 声音编辑能力:支持基于自然语言提示的声音修改与生成(如“把这段录音背景变安静”)

- 个性化反馈系统:为用户提供更人性化的交互体验

例如:

- 用户练习唱歌时,模型可提供发音纠正与训练建议

- 驾驶途中,用户可询问“刚才那声巨响是什么?”并获得实时解答

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...