随着AI技术的不断进步,视觉-语言模型(VLM)在机器人、自动驾驶、医疗保健等领域的应用日益广泛。然而,将长上下文能力与视觉理解相结合虽然显著提升了 VLM 的潜力,但也带来了新的挑战——尤其是在预填充阶段的高延迟问题。这一瓶颈限制了长上下文 VLM 在实际场景中的部署效率。

针对这一问题,萨里大学和微软的研究团队推出了MMInference,一种创新的动态稀疏注意力方法,旨在加速长上下文 VLM 的预填充阶段。通过优化视频输入中的时空稀疏模式和模态边界,MMInference 不仅大幅减少了计算开销,还在多个任务中保持了高精度。

- GitHub:https://github.com/microsoft/MInference

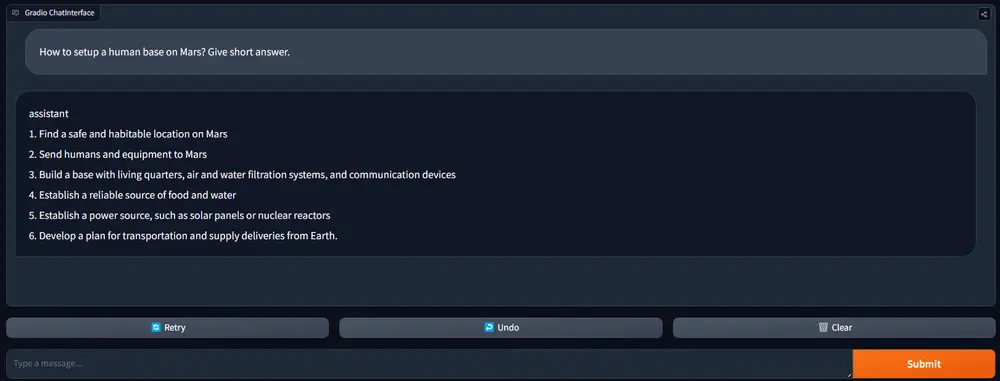

- Demo:https://huggingface.co/spaces/microsoft/MInference

背景:长上下文 VLM 的挑战

长上下文能力使 VLM 能够处理更长的视频序列和复杂的文本交互,从而提高时间分辨率和任务性能。然而,这种能力也带来了高昂的计算成本,尤其是在预填充阶段。注意力机制的二次复杂度导致首个令牌生成时间(Time-to-First-Token, TTFT)显著增加,这使得长上下文 VLM 的实时部署变得困难。

尽管已有多种稀疏注意力方法试图缓解这一问题,例如 Sparse Transformer、Swin Transformer 和 StreamingLLM,但这些方法通常无法充分捕捉混合模态输入的独特结构。视频和文本数据表现出独特的时空相关性,而现有技术难以有效处理这种复杂的模态交互。

MMInference:模态感知的稀疏注意力框架

MMInference 是一个专门为长上下文 VLM 设计的动态稀疏注意力框架,旨在通过识别和利用输入数据中的模态特异性稀疏模式来加速推理过程。其核心思想是避免密集计算,转而采用基于置换的策略和优化的 GPU 内核,以实现高效的稀疏注意力计算。

关键组件

模态内稀疏模式 Grid 注意力:捕捉视频帧内的局部相关性。 A-shape 和 Vertical-Slash 注意力:适应不同模态的时间和空间特性。

跨模态稀疏模式 Q-Boundary 和 2D-Boundary:明确处理模态之间的边界,减少不必要的计算。

模态感知的稀疏注意力搜索算法

动态识别每个输入的最佳稀疏模式,并为每个注意力头分配适当的稀疏分布,从而最大化计算效率。

优化策略

基于置换的张量操作:通过重新排列张量以匹配稀疏模式,减少冗余计算。 自定义 GPU 内核:利用高效张量处理和并行化技术,进一步加速稀疏注意力计算。

实验结果:性能与效率的双重提升

研究团队在多个基准测试中验证了 MMInference 的性能,包括视频问答(Video QA)、描述生成(Captioning)和混合模态大海捞针(Mixed-Modality Needle in a Haystack, MM-NIAH)任务。实验使用了最先进的模型,如Llava-Video和LongVILA,并与多种稀疏注意力基线进行了比较。

主要成果

计算效率:在处理长达 100 万个令牌的任务时,MMInference 实现了高达8.3 倍的加速。 任务性能:在多个任务中,MMInference 的表现接近全注意力模型,同时显著减少了计算开销。 鲁棒性:该框架在不同的上下文长度和输入类型中均表现出色,特别是在混合模态任务中表现尤为突出。

应用场景与意义

MMInference 的推出为长上下文 VLM 的实际部署铺平了道路,特别是在以下领域:

机器人:通过快速处理长视频序列和多轮对话,提高机器人对环境的理解能力。 自动驾驶:在复杂交通场景中,快速分析长时间视频数据以做出决策。 医疗保健:高效处理长视频记录和病历数据,支持精准诊断和治疗建议。

此外,MMInference 的设计无需修改现有模型或进行微调,可以直接集成到当前的 VLM 流程中,降低了部署门槛。

相关文章