自回归(AR)模型在语言生成领域取得了巨大成功,但在高分辨率图像合成中的应用却面临严峻挑战。与文本不同,图像需要数千个 token 来表示,导致计算成本呈二次方增长。这使得大多数基于 AR 的多模态模型只能处理低分辨率或中等分辨率图像,限制了其在细节生成上的表现。

为了解决这一问题,Meta AI 最近推出了Token-Shuffle,一种旨在减少 Transformer 处理图像 token 数量的新方法。这种方法不仅显著降低了计算成本,还保持了生成图像的视觉保真度,为高分辨率图像合成开辟了新的可能性。

Token-Shuffle 的核心思想

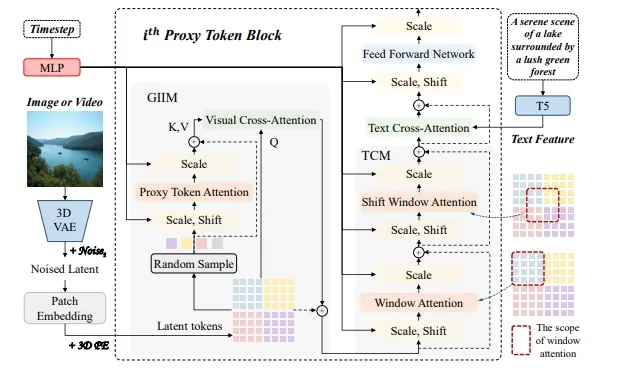

Token-Shuffle 的关键在于利用视觉词汇表中的维度冗余。与文本 token 相比,视觉 token 通常来源于向量量化(VQ)模型,虽然占据高维空间,但其内在信息密度较低。Token-Shuffle 通过在 Transformer 处理之前合并空间局部视觉 token,并在推理后恢复原始空间结构,从而减少了 token 的数量。

具体而言,Token-Shuffle 包括两个操作:

Token-Shuffle:在输入准备阶段,使用多层感知机(MLP)将空间相邻的 token 合并成压缩 token。这些压缩 token 保留了关键的局部信息,同时大幅减少了 token 的数量。 Token-Unshuffle:在 Transformer 层之后,通过轻量级 MLP 恢复原始的空间排列,重建图像的高分辨率表示。

这种方法无需修改 Transformer 架构本身,也不引入额外的预训练步骤或辅助损失函数,因此易于集成到现有的 AR 模型中。

技术亮点:无分类器指导调度器

为了进一步优化生成效果,Token-Shuffle 集成了一个专门为自回归生成设计的无分类器指导(CFG)调度器。与传统的固定指导尺度不同,这种调度器会动态调整指导强度,最大限度地减少早期 token 的伪影,并提高文本-图像对齐度。

性能评估与实验结果

Token-Shuffle 在多个基准测试中表现出色,展示了其在高分辨率图像生成中的潜力:

GenAI-Bench 基准测试

使用一个 27 亿参数的基于 LLaMA 的模型,Token-Shuffle 在“hard”提示下获得了0.77 的 VQAScore,优于其他自回归模型(如 LlamaGen,高出 +0.18)和扩散模型(如 LDM,高出 +0.15)。GenEval 基准测试

Token-Shuffle 获得了0.62 的总分,为在离散 token 机制中运行的 AR 模型设定了新的基线。人工评估

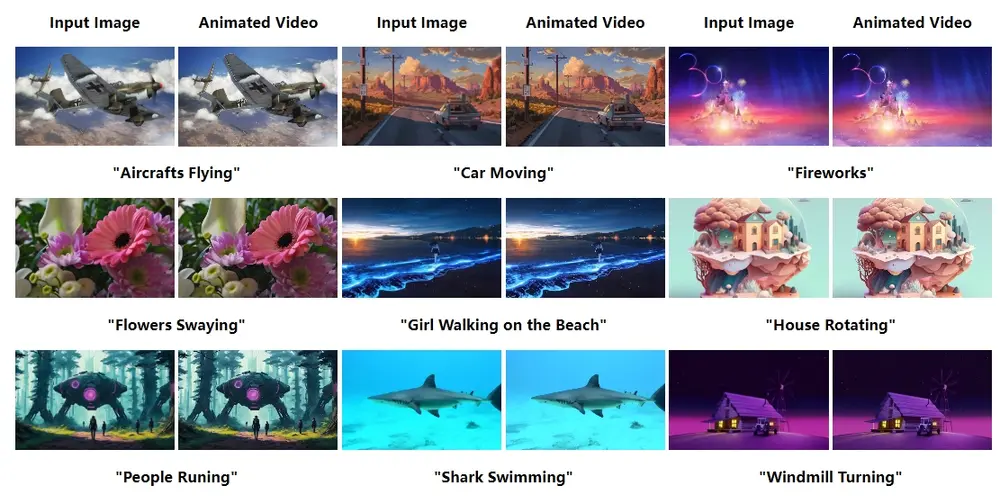

大规模人工评估表明,Token-Shuffle 在大多数情况下表现出与文本提示更好的对齐、更少的视觉缺陷和更高的主观图像质量。然而,在逻辑一致性方面仍略逊于扩散模型,这为未来改进指明了方向。视觉质量

Token-Shuffle 能够生成细节丰富且连贯的1024×1024 和 2048×2048 分辨率图像。消融研究表明,较小的 shuffle 窗口大小(如 2×2)在计算效率和输出质量之间提供了最佳平衡。

Token-Shuffle 的优势与意义

显著降低计算成本:通过减少 token 数量,Token-Shuffle 显著降低了 Transformer 的计算复杂度,使其能够处理高分辨率图像。 保持生成质量:尽管减少了 token 数量,Token-Shuffle 仍然能够生成高质量、高分辨率的图像,甚至在某些情况下超越传统方法。 易于集成:该方法与现有的下一个 token 预测框架完全兼容,无需修改 Transformer 架构或引入复杂的额外组件。 推动多模态生成研究:Token-Shuffle 为大规模处理文本和图像模态的高效统一模型奠定了基础,为未来的多模态生成研究提供了新的方向。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...