快手科技、中国科学技术大学和复旦大学的研究人员推出视频驱动人脸识别动画系统LivePortrait,它能够将静态的肖像照片生动地动画化,同时保持高效和精确的控制能力。例如,你有一张其他人物照片,LivePortrait可以让它动起来,模仿你的面部表情和头部姿势。

- 项目主页:https://liveportrait.github.io

- GitHub:https://github.com/KwaiVGI/LivePortrait

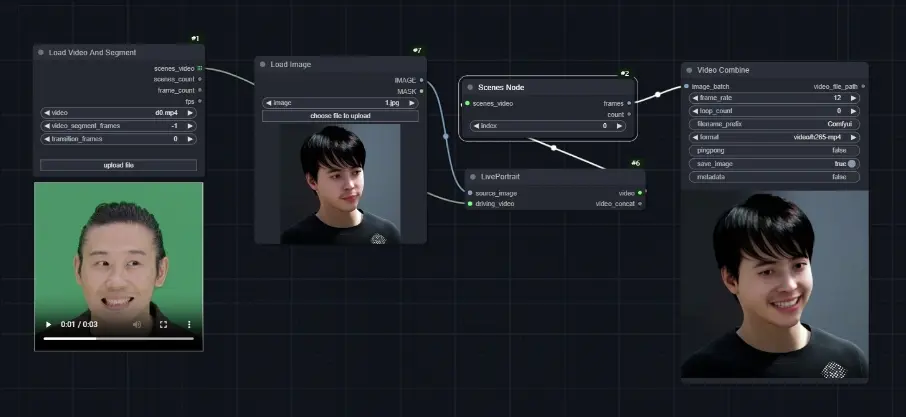

- Comfyui插件:https://github.com/shadowcz007/comfyui-liveportrait 或 https://github.com/kijai/ComfyUI-LivePortrait

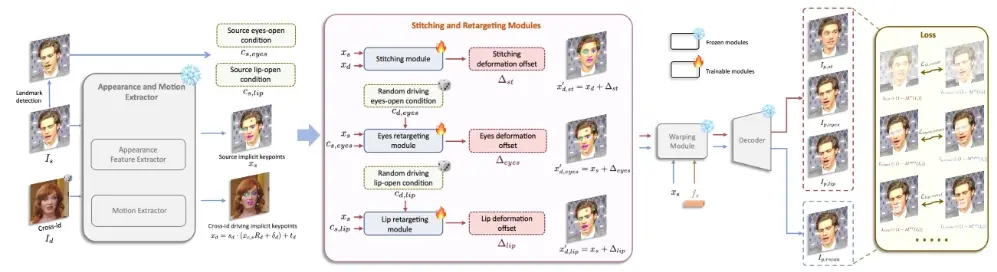

LivePortrait侧重于提升其在实际应用中的泛化性、可操控性和效率。为提升生成效果及泛化能力,研究人员扩充了训练数据至大约6900万帧的高画质影像,采用了融合图像与视频的训练策略,改进了网络结构,并且优化了运动转换与目标函数的设计。另外,研究人员发现精简的隐式关键点能有效编码一类混合形变信息,并因此细心设计了拼接及双重映射模块,这些模块借助一个计算开销微乎其微的小型MLP,增强了可控性。实验结果显示,相较于基于扩散的方法,LivePortrait同样表现出色。在配备PyTorch环境的RTX 4090 显卡上,其生成速度惊人地达到了每帧12.8毫秒。

主要功能和特点:

- 高效动画生成:LivePortrait能够在极短的时间内生成动画,具体到12.8毫秒就可以在高端GPU上完成一张肖像动画的生成。

- 精确控制:它提供了对眼睛和嘴唇动作的精确控制,甚至可以处理多人物肖像的无缝衔接。

- 通用性:不依赖于预训练的网络,使得该框架具有普遍适用性。

- 高质量生成:通过扩展训练数据和改进网络架构,LivePortrait在多个图像合成任务上实现了高质量的输出。

工作原理:

- 数据准备:LivePortrait使用了大量的高质量图像和视频数据进行训练,包括公共视频数据集和私人数据集。

- 网络架构:它采用了混合的图像-视频训练策略,升级了网络架构,使用了可扩展的运动转换和级联损失项。

- 隐式关键点:LivePortrait基于隐式关键点框架,通过一个小型的多层感知器(MLP)来增强控制能力,同时保持了计算效率。

- 拼接和重定向模块:设计了拼接模块和两个重定向模块,用于增强控制力,如拼接控制。

具体应用场景:

- 视频会议:在视频会议中,使用LivePortrait可以让参与者的静态头像动起来,提供更自然的交流体验。

- 社交媒体:用户可以将自己的静态照片转换成动态肖像,用于社交媒体上的个性化展示。

- 娱乐和游戏:在电影、游戏或虚拟现实中,LivePortrait可以用来生成逼真的角色动画。

- 音频驱动的角色动画:LivePortrait还可以通过音频输入来驱动角色的面部动画,适用于自动生成的语音或角色配音。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...