KoboldCpp是一款易于使用的AI文本生成软件,支持GGML和GGUF模型,其灵感来源于原始的KoboldAI。这是由Concedo开发的一个独立的可分发程序,基于llama.cpp构建,并增添了多功能的KoboldAI API接口、额外的格式支持、Stable Diffusion图像生成、语音转文本、向后兼容性,以及一个精美的用户界面。该界面具备持久化故事、编辑工具、保存格式、记忆功能、世界信息、作者注释、角色设定、场景等功能,包含了KoboldAI和KoboldAI Lite所提供的所有特性。

使用方法(Windows平台)

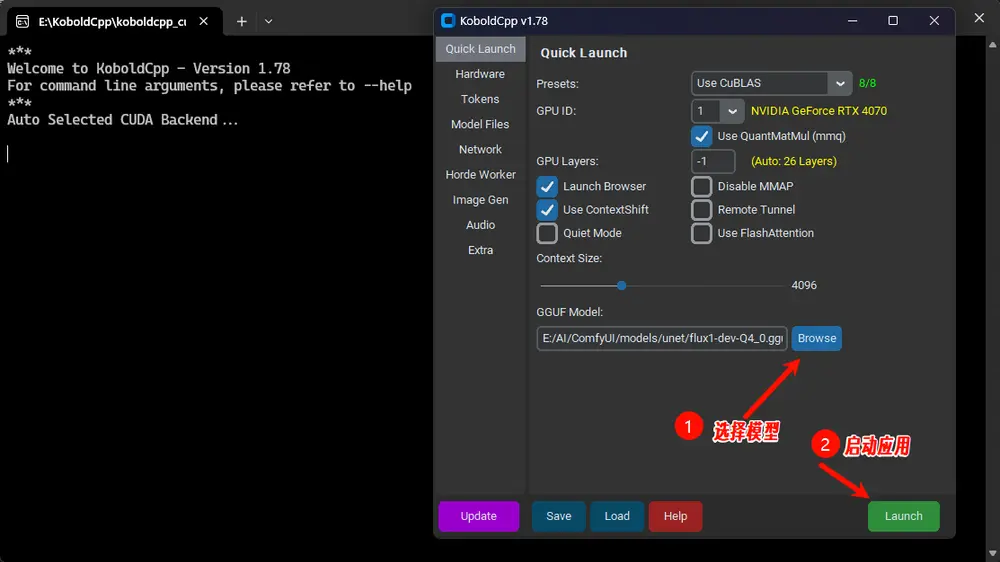

下载:访问 最新版本页面 下载最新的 koboldcpp.exe。运行:双击 koboldcpp.exe运行软件GUI 设置:首次运行时,默认会显示一个包含部分可配置设置的 GUI。通常情况下,您只需选择预设和 GPU 层数。更多设置信息请参见 koboldcpp.exe --help连接:默认情况下,您可以连接到 http://localhost:5001

版本选择

标准版: koboldcpp.exe(包含 CUDA 支持)无 CUDA 版: koboldcpp_nocuda.exe(适用于不需要 CUDA 的用户)旧 CPU 版: koboldcpp_oldcpu.exe(适用于旧 CPU 和英伟达显卡用户)CUDA 12 版: koboldcpp_cu12.exe(适用于较新的英伟达显卡,更大且稍快)Linux 版:选择适当的 Linux 二进制文件(非 .exe)MacOS 版: koboldcpp-mac-arm64(适用于 M1、M2、M3 用户)AMD 版:尝试 YellowRoseCx 的 fork 中的 koboldcpp_rocm

获取 GGUF 模型

KoboldCpp 使用 GGUF 模型。这些模型不随软件一同提供,但您可以在以下地方下载:

Hugging Face:在 huggingface.co 上搜索 "GGUF",可以找到许多兼容的 .gguf格式模型。模型转换:如果您有其他格式的模型,可以使用提供的工具将其转换为 GGUF 格式。运行 convert-hf-to-gguf.py进行转换,然后运行quantize_gguf.exe对结果进行量化。

性能提升

GPU 加速:使用带有英伟达显卡的 Windows 时,可以通过添加 --usecublas(仅限 Nvidia)或--usevulkan(任何 GPU)标志获得 CUDA 支持。GPU 层卸载:使用 --gpulayers将模型层卸载到 GPU,以提高生成速度。根据您的 GPU 内存情况调整层数。增加上下文大小:使用 --contextsize增加上下文大小,允许模型读取更多文本。同时,您可能需要在 KoboldAI Lite UI 中增加最大上下文。旧 CPU 兼容性:如果遇到问题,可以尝试添加 --noavx2标志以非 AVX2 兼容模式运行,或关闭mmap(使用--nommap)或减少--blasbatchssize(设置为-1以避免批处理)。

1.78版本新增功能

Flux 和 Stable Diffusion 3.5 模型支持:图像生成已更新为新的架构支持,并进行了额外增强。支持 FP16 和 FP8 safetensor 模型,或 GGUF 模型。提供了一体式模型和单独加载选项。 大图像处理:支持更大的图像处理,带有 VAE 平铺,1024x1024 应该适用于 SDXL 和 Flux。 调试模式:新增了调试模式,打印 XTC 的惩罚。 强制重新处理提示:新增了 --nofastforward标志,强制在每次请求时完全重新处理提示,以获得更一致的结果。CLBlast 支持:CLBlast 支持已降级为“兼容模式”,不再推荐使用。 身份提供者支持:新增了常见的身份提供者支持。 性能和稳定性改进:修复了多个问题,提高了性能和稳定性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...