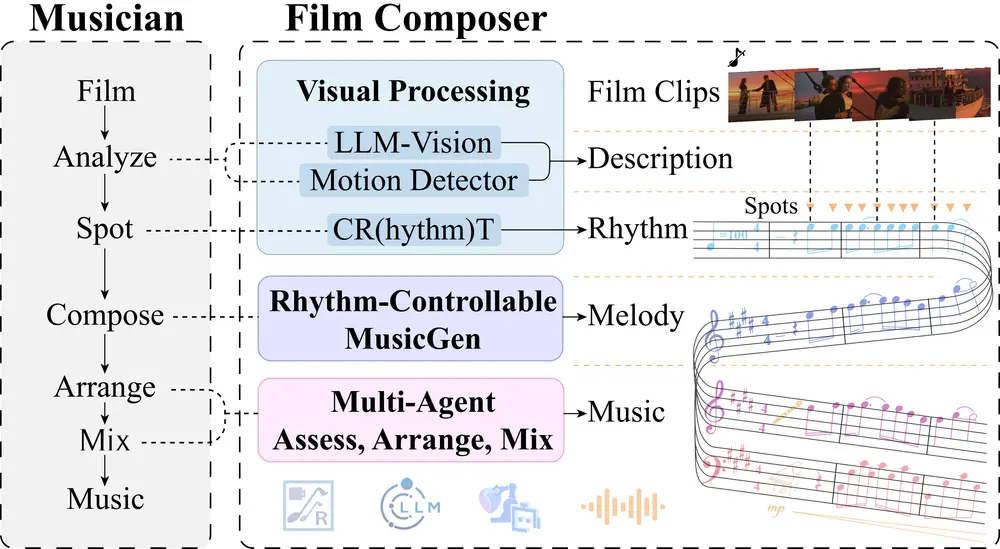

上海大学和上海电影特效工程技术研究中心的研究人员推出 FilmComposer,利用大语言模型(LLM)驱动的方法为无声电影片段生成音乐。FilmComposer 旨在模拟专业音乐家的实际工作流程,结合波形音乐和符号音乐生成的优势,为电影片段创作高质量、具有音乐性和音乐发展的音乐。

- 项目主页:https://apple-jun.github.io/FilmComposer.github.io

- GitHub:https://github.com/Apple-jun/FilmComposer

- 数据集:https://huggingface.co/datasets/apple-jun/MusicPro-7k

例如,给定一个无声电影片段,内容是“一位演员在舞台上表演,背景是华丽的剧院”。传统的音乐生成方法可能无法准确捕捉到场景的情感和节奏,生成的音乐可能与画面不匹配。而 FilmComposer 通过分析视频内容、提取节奏点和语义信息,并利用多智能体系统进行评估、编排和混音,能够生成与画面情感、节奏和主题高度一致的音乐。

主要功能

- 高质量音乐生成:生成符合电影工业标准(如 48kHz 采样率和 24 位深度)的音乐。

- 音乐与视频对齐:确保生成的音乐在节奏、情感和主题上与电影片段高度一致。

- 音乐性增强:通过多智能体系统评估和优化生成的旋律,确保音乐具有良好的和声、节奏和情感表达。

- 音乐发展:模拟专业音乐家的编排和混音过程,使音乐在时间上具有主题和动机的发展。

- 用户交互:允许用户在生成过程中进行干预,调整节奏点、语义描述和编排方案,提供高度的创作自由度。

主要特点

- 结合波形音乐和符号音乐生成:FilmComposer 是首个将大型生成模型与多智能体方法相结合的系统,利用波形音乐的丰富性和符号音乐的高质量。

- 多智能体系统:通过多智能体系统进行评估、编排和混音,确保生成的音乐在多个方面达到专业水平。

- 节奏可控的 MusicGen:通过节奏条件器和文本编码器,生成与视频节奏和语义对齐的主旋律。

- 专业数据集 MusicPro-7k:为训练 FilmComposer 构建了一个包含 7,418 个电影片段和音乐对的专业数据集,涵盖视觉描述、节奏点和主旋律。

工作原理

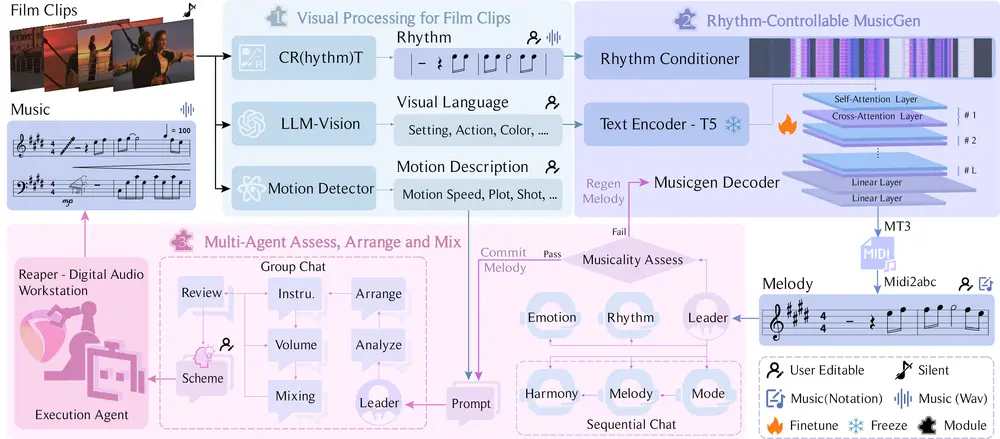

FilmComposer 的工作原理可以分为三个主要模块:

- 视觉处理模块(Visual Processing):

- 分析电影片段,提取节奏点、语义描述和运动特征。

- 使用 Controllable Rhythm Transformer (CRT) 提取节奏点,分析视频的情感、主题和动作。

- 提取运动速度、镜头切换和情节发展等信息,为后续的编排和混音提供指导。

- 节奏可控的 MusicGen:

- 结合节奏点和视觉描述,生成与视频对齐的主旋律。

- 使用 T5 文本编码器和 MusicGen 解码器,将节奏和语义信息转化为音乐。

- 生成的旋律被转录为 MIDI 和 ABC 符号,便于进一步的专业处理。

- 多智能体评估、编排和混音:

- 使用多智能体系统评估生成旋律的音乐性,如果不符合标准则重新生成。

- 基于角色扮演和链式思考,智能体协作完成编排和混音方案。

- 使用数字音频工作站(DAW)执行编排和混音方案,生成最终的高质量音乐。

应用场景

- 电影配乐:

- 应用场景:为无声电影片段生成高质量的背景音乐,增强视觉内容的情感表达和叙事连贯性。

- 优势:FilmComposer 能够生成与视频节奏、情感和主题高度一致的音乐,满足专业电影制作的需求。

- 视频内容创作:

- 应用场景:为个人项目、社交媒体内容或广告视频生成背景音乐。

- 优势:FilmComposer 提供了高度的用户交互性,非专业人士也可以轻松生成符合需求的音乐。

- 音乐教育:

- 应用场景:帮助初学者快速了解音乐制作流程,通过实践学习音乐创作技巧。

- 优势:FilmComposer 的交互系统允许用户在每个步骤进行干预,提供直观的学习体验。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...