香港科技大学(广州)和 Adobe 研究的研究人员推出一种先进的文本到视频生成方法 TransPixar,特别专注于生成包含透明度通道(Alpha Channel)的RGBA视频,也就是能够通过文本和图像生成透明背景的视频。这种方法通过在基于DiT架构模型中引入LoRA层和新颖的Alpha通道自适应注意力机制,实现了从文本到RGBA视频的高质量生成,同时保留了原始RGB视频生成的质量。目前已经释出了CogVideoX-5B的RGBA LoRA,大家可以下载尝试。

- 项目主页:https://wileewang.github.io/TransPixar

- GitHub:https://github.com/wileewang/TransPixar

- 模型:https://huggingface.co/wileewang/TransPixar

- Demo:https://huggingface.co/spaces/wileewang/TransPixar

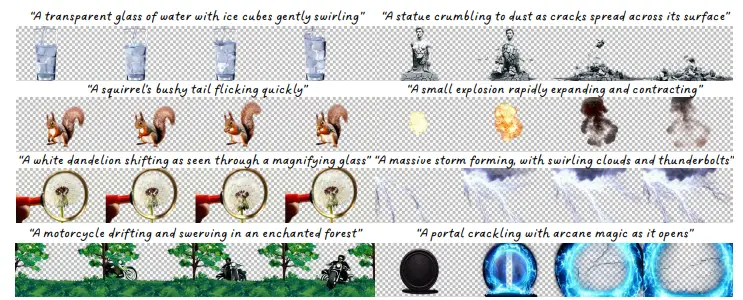

例如,通过TransPixar,可以从文本描述“一只松鼠的蓬松尾巴快速摆动”生成一个视频,其中不仅包括松鼠的RGB颜色信息,还包括其尾巴摆动时的透明度信息,使得视频中的松鼠尾巴在摆动过程中能够自然地与背景融合,产生逼真的视觉效果。

主要功能

- RGBA视频生成:能够从文本描述生成包含RGB颜色通道和Alpha透明度通道的视频。

- 高质量视频生成:在生成RGBA视频的同时,保留原始RGB视频生成的高质量。

- 文本到视频的对齐:确保生成的RGB视频和Alpha通道在运动和内容上高度一致,避免出现错位或不匹配的情况。

主要特点

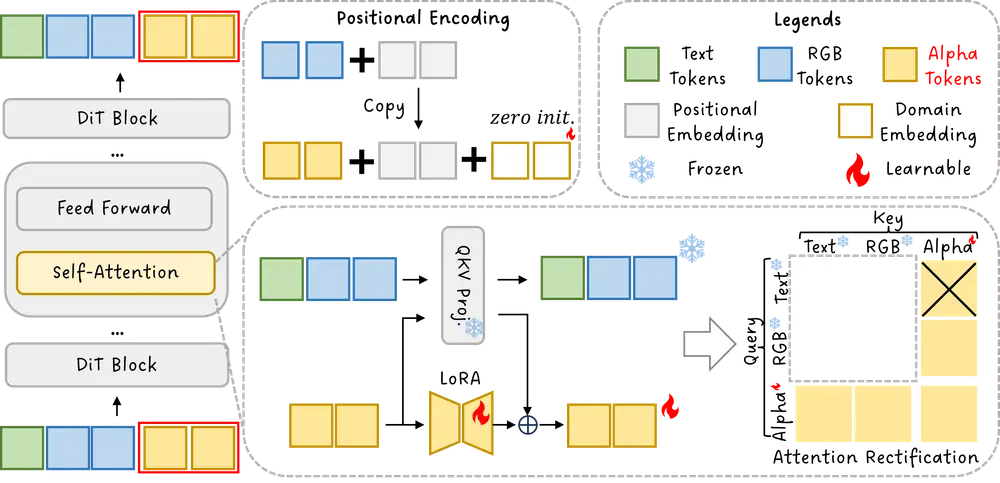

- 基于DiT架构:利用先进的扩散变换器架构,捕捉视频中的长期依赖关系,提升生成视频的质量。

- LoRA层的应用:通过LoRA(Low-Rank Adaptation)层进行微调,专门针对Alpha通道的生成,而不影响RGB通道的生成质量。

- 注意力机制优化:引入了新颖的Alpha通道自适应注意力机制,优化了文本、RGB和Alpha通道之间的交互,提高了生成视频的一致性和对齐度。

- 有限数据训练:即使在训练数据有限的情况下,也能生成多样且一致的RGBA视频,展示了强大的泛化能力。

工作原理

- 输入扩展:将预训练的RGB视频生成模型的输入序列长度加倍,以便同时生成RGB视频和对应的Alpha视频。

- 位置编码和域嵌入:为Alpha通道的token重新初始化位置编码,并引入可学习的域嵌入,帮助模型区分RGB和Alpha通道的token。

- LoRA微调:仅对Alpha通道的token应用LoRA层,将其投影到qkv空间,保持RGB生成质量不变。

- 注意力机制调整:通过设计特定的注意力掩码,保留必要的注意力计算,去除不必要的注意力,优化RGB和Alpha通道之间的对齐和生成质量。

具体应用场景

- 视觉特效(VFX):在电影、游戏和虚拟现实(VR)/增强现实(AR)应用中,生成包含透明元素(如烟雾、反射、魔法效果等)的视频,这些元素可以无缝地融入场景中。

- 视频编辑:为视频编辑提供更灵活的素材,允许编辑者在不修改背景的情况下,添加或修改视频中的透明对象。

- 广告和营销:创建具有创意和吸引力的透明视频内容,用于广告和营销活动,提升视觉效果和用户参与度。

- 教育和培训:生成包含透明标注或动画的教育视频,帮助学生更好地理解和学习复杂的概念。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...